что такое дипфейк простыми словами

Эйнштейн вместо тренера: что такое дипфейк и почему это тренд в обучении

Британский рекламный холдинг WPP обучает сотрудников при помощи нейросети. 50 000 человек осваивают основы маркетинга по видеокурсам с виртуальным наставником, который ведёт лекции на трёх языках: английском, испанском и китайском. При этом к каждому сотруднику наставник обращается лично по имени.

Видеокурсы на основе дипфейк уже создают компании Великобритании

и США. Рассказываем, что это за технология и чем полезна для бизнеса.

Что такое дипфейк и как работает

Дипфейк — видео, созданное с помощью искусственного интеллекта. Если упрощённо, нейросеть по пикселям собирает ролик на основе готовых изображений. Например, изучает тысячи фотографий Дэвида Бекхэма и выпускает видео, на котором спортсмен призывает людей бороться с малярией.

Дипфейк с Дэвидом Бекхэмом. Футболист на пяти языках призывает подписать петицию против малярии

Другой вариант работы — искусственный интеллект накладывает одного персонажа на другого и получается комбо: Джим Керри в роли злодея из фильма «Сияние» или Бред Питт в образе терминатора.

Нейросеть показала, как выглядел бы Джим Керри в фильме «Сияние». Смотреть пример целиком

Бред Питт в роли терминатора — очередная фантазия дипфейка

От архитектуры до журналистики — где используют дипфейк

Дипфейк изобрел студент Стэнфордского университета Ян Гудфеллоу

в 2014 году для разработчиков искусственного интеллекта. Но технология быстро вышла за пределы узкого круга учёных. Сейчас её используют

в массовой культуре: от архитектуры до журналистики.

С помощью дипфейка GauGAN детские наброски можно превратить в реалистичный пейзаж

У созданного при помощи дипфейка блогера Лил Микела два миллиона подписчиков в «Инстаграм»

Приложение Faceapp покажет, как бы вы выглядели в старости или женском образе

В чём польза дипфейка для корпоративного обучения

68% сотрудников предпочитают учебные видеоролики статьям, инфографике, презентациям и книгам. Это подтверждает международное исследование компании Wyzowl. При работе над видео дипфейк даёт бизнесу ряд преимуществ.

Это позволяет международным компаниям сэкономить деньги на локализации контента, снять языковой барьер и учить сотрудников во всех странах по единым стандартам.

Учебный ролик от стартапа Synthesia. При помощи нейросети тренер читает лекцию на французском, китайском и португальском. Технология меняет не только озвучку, но и движение губ тренера

При помощи технологии дипфейк лекция больше похожа на разговор по душам — тренер обращается к сотруднику по имени и говорит лично с ним

Как получить видеокурс по технологии дипфейк

Есть два способа: заказать у студии или создать самому при помощи специальных программ.

Чтобы сделать видеокурс в Synthesia Create не нужна студия, камера и даже ведущий — только сценарий. Остальное нейросеть делает за вас.

В Synthesia Create вы собираете видеокурс, как конструктор: выбираете персонажа, фон, язык озвучки, добавляете текст и нажимаете «Опубликовать». Курс готов — виртуальный персонаж ведёт тренинг по вашему сценарию

Synthesia Create полностью на английском языке. Есть бесплатная демоверсия. Чтобы её получить, достаточно оставить заявку на сайте.

Видеокурсы на основе нейросети кроме британского WPP уже создают в Reuters, SAP, Accenture и Buzzfeed, пишет издание Wired. Материалы используют для адаптации новичков, обучению технике безопасности и стандартам работы.

Технология дипфейк пока осваивается за рубежом. А позже, возможно, приживётся в и России, как это получилось с виртуальной реальностью.

Быстрый конструктор курсов и тестов

Поможет создать интерактивные курсы и тесты в рекордно короткие сроки. Без дизайнера и программиста.

Редактор iSpring. Пишу статьи по eLearning, помогаю экспертам выпускать материалы для блога iSpring. Если у вас есть интересная тема по дистанционному обучению, напишите мне.

Что такое дипфейк, почему он опасен и как его распознать?

Вы видели, как королева Елизавета танцевала на столе, произнося новогоднее послание? Или вы слушали речь Ким Чен Ына о демократии или восхищались Сальвадором Дали, рассказывающим о своей смерти (в которую он не верит)?

Все эти удивительные фильмы объединяет одно — они фальшивые. Deepfake — это создание и публикация ложной информации в виде видео, аудио и фотографий. Создавать Deepfake становится все проще, поэтому мы подготовили руководство по созданию, распознаванию и поиску дипфейков в Интернете.

Что такое дипфейк?

Deepfake — это, по сути, фото, видео или аудио материал, который не является реальным. Он создается с помощью алгоритмов, основанных на реальных образцах голоса, звука, видео или фотографий, которые объединены вместе. Алгоритм берет информацию из множества разных мест и затем объединяет их в один материал. В результате создается нечто новое (не настоящие), основанное на сопоставлении различных реальных данных.

Но не только это. Deepfake также может «рисовать» фотографии с нуля, например, создавая персонажей и лица людей, которых никогда не существовало.

Какова цель такой инновации? Deepfake используется для размещения ложной информации в Интернете (например, о политических событиях), взломе, краже (в том числе подделку голосовых команд). Его также можно использовать в образовательных и развлекательных целях.

Deepfake — как это работает?

Есть два метода создания дипфейк-материала.

Первый использует два алгоритма. Кодировщик ищет общие черты двух изображений (которые нужно объединить в одно), второй (декодер) может передать их в новое ложное изображение. Например, если мы хотим, чтобы актер двигался так же, как мы, кодировщик будет изучать движение из видео с танцами. Декодер превратит наше лицо в лицо актера и заставит его реагировать таким же образом. Ключевыми здесь являются выбранные функции, которые копируются в новое изображение (например, движение рта, жесты, мимика).

Второй способ — через генерирующие состязательные сети (GAN), где два алгоритма работают вместе. Первый называется генератором, потому что, используя общую информацию, он создает изображения (например, изображение человека), определяя другие его отличительные черты (у человека есть тело. У человека есть лицо. У человека есть глаза). Второй алгоритм — это дискриминатор, который оценивает, верны ли изображения, предоставленные ему генератором.

Со временем оба алгоритма становятся все более и более совершенными за счет обучения. Если генератор настроен так, что дискриминатор не распознает фальшивую фотографию (считает ее настоящей), процесс можно считать завершенным.

Поддельные записи остались в прошлом. Теперь нам нужно остерегаться фейковых видео.

Угроза Deepfake — с каких пор она существует?

Впервые подобная ложная информация появилась в 2017 году. На тот момент пользователь под псевдонимом deepfake опубликовал на Reddit несколько порнографических фильмов, в которых принимали участие знаменитости, в т.ч. Скарлетт Йоханссон, Галь Гадот и Тейлор Свифт. С тех пор эта область сильно развивается, потому что дипфейк-фильмы может делать практически любой.

Как сделать дипфейк?

Если дипфейк-видео может делать кто угодно, можно ли его снимать дома? Однозначно да, но их качество не будет идеальным. Для их создания вам потребуются большие вычислительные ресурсы и мощные видеокарты.

То, что у нас обычно есть в домашних компьютерах, недостаточно, а сам процесс разработки может занять несколько недель. Качество фильмов тоже оставляет желать лучшего — будут видны ошибки, движение рта может не совпадать со звуком, и будут видны места, где «старый» контент перекрывается с «новым».

Однако, если мы хотим немного «подправить» фотографию или сделать короткий дипфейк-фильм, программу можно загрузить прямо на смартфон. Очень простое в использовании приложение исправит недостатки красоты за несколько мгновений, превратит нас в избранных знаменитостей или позволит нашей собаке говорить человеческим голосом.

Как распознать дипфейк?

Профессиональные дипфейк-видео становится все труднее и труднее распознать. Первоначально у алгоритмов были проблемы с базовым поведением (например, с морганием глаз), и это сразу выдавало поддельное видео. Эта ошибка исправлена. Поддельные персонажи моргают, двигаются естественно, а также бегло говорят. Однако иногда у них возникают проблемы с естественным движением глаз.

Так как же обнаружить дипфейк? Вот на что следует обратить внимание при просмотре видео:

При анализе материалов на дипфейк также стоит полагаться на собственные ощущения. Иногда создается впечатление, что что-то «не так».

Прежде чем поверить найденной информации, обязательно ее проверьте.

Deepfake на русском языке — где можно встретить?

Ложный материал можно найти везде, где он может охватить большую аудиторию, то есть потенциальную аудиторию дипфейков. Вк, Одноклассники, Instagram, TikTok и другие социальные сети полны такого рода материалов. Это не только видео, но и «доработанные» фото и аудиозаписи. Некоторые из аутентично выглядящих профилей были полностью заполнены дипфейком!

Это не единственные места, где можно найти дипфейк. Приложение для смартфона, которое позволяет добавить на фото усы и бороду или другие спецэффекты (например, старение на несколько десятилетий), также основано на этом механизме.

Deepfake — фильмы

Deepfake можно использовать по-разному, как положительно, так и отрицательно.

Материалы Deepfake также могут иметь образовательные функции, «воскрешая» умерших артистов, певцов и музыкантов. Некоторые музеи (в том числе Музей Сальвадора Дали во Флориде) используют эту технологию. Благодаря этому сам художник показывает туристам свои коллекции, с которыми можно поговорить и даже сфотографироваться.

Записи Deepfake можно использовать в генераторах голоса — устройствах, предназначенных для людей, потерявших способность говорить. Благодаря им они все еще могут говорить с нами своим голосом.

К сожалению, мы также имеем дело с негативным использованием дипфейка. Политика — это пример того, как ложная информация такого рода может иметь далеко идущие глобальные последствия, в том числе: дискредитировать общественных деятелей, влиять на фондовый рынок, экономику или результаты выборов. Хорошо подготовленный фильм также упрощает манипулирование общественным мнением. Прогрессивное развитие технологий затруднит различение настоящих и поддельных материалов. Следовательно, это шаг к снижению общественного доверия и информационному хаосу.

Обязательно посмотрите примеры дипфейков

Угроза Deepfake — реальна для всех нас

Deepfake — это проблема не только американских актеров и политиков. Подделка может повлиять на любого. Созданное видео, в котором мы совершаем преступление или попадаем в не однозначную ситуацию, может стать элементом шантажа и вымогательства. Если вы ведете активный бизнес, дипфейк можно использовать для дискредитации компании среди ее подрядчиков.

Растущее количество подтасованных материалов также повлияет на социальное доверие и веру в предоставленную информацию. Как верить чему-либо, когда фильм, являющийся доказательством в суде, может быть неправдой, а в новостях описываются несуществующие события?

Чем больше записей с данным человеком, тем проще создать дипфейк.

Борьба с дипфейком

Поток ложной информации настолько велик, что многие социальные сети решили бороться с дипфейком. Facebook и Twitter пытаются обнаружить поддельные видео и автоматически удалить их. Крупные корпорации (в том числе Microsoft или Amazon) вкладывают средства в создание программного обеспечения, которое легко обнаруживает подделанные материалы. Ученые также работают над решениями.

Однако в ситуации, когда приложения для смартфона достаточно для создания фейкового фильма, борьба с дипфейком — это борьба с ветряными мельницами. Также отсутствуют правовые нормы, которые определяли бы последствия манипулирования информацией или использования чьего-либо изображения таким образом.

Резюме

Deepfake становится все более популярным, и его все труднее отличить от правды. Это связано с совершенствованием технологий, лучше имитирующих движения и жесты человека. Программное обеспечение Deepfake можно использовать с хорошими целями, создавая учебные материалы, но они также являются инструментом для хакеров, шантажистов и интернет-троллей.

Поэтому, если вы снова наткнетесь на удивительное видео в сети, сначала проверьте, не было ли оно создано искусственно. Возможно, то, что вы смотрите, никогда не происходило!

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Дипфейки: кому и зачем они нужны

Дипфейк (deepfake) – производная от «глубокого обучения» и «подделки»; штука, про которую сегодня большинство говорит с опаской. Само название как бы кричит: «Я зло!». А наша гипотеза в том, что это технология с огромнейшим позитивным потенциалом, которая пока используется в основном как игрушка в руках неразумного человека. Что это и как на самом деле? Давайте разбираться.

Дипфейки используют технологии искусственного интеллекта для синтеза изображений, в результате чего один персонаж как бы накладывается на другого и получается «комбо»: оживает Мона Лиза или Терминатором становится Бред Питт.

Эта технология позволяет легко манипулировать аудио- и видеоконтентом, а по мере того, как она развивается, разобраться, где правда, а где фейк – становится всё сложнее. Так в прогремевшем на весь интернет видео Барак Обама критикует Дональда Трампа, называя его «полным провалом». В США считается, что дипфейки представляют угрозу национальной безопасности. В Калифорнии некоторые виды дипфейков даже запретили законодательно.

Чаще всего дипфейки создаются с помощью генеративно-состязательной сети (GAN), в ней 2 системы: генератор и дискриминатор. Они работают как пара студентов в университетской микрогруппе: один предлагает идеи, другой их критикует. Генератор создаёт изображения, а обученный на реальных фотографиях дискриминатор подсказывает, что нужно исправить.

Заметим, что технология постоянно развивается. Так, например, алгоритм BigGAN от Google и NVIDIA позволяет не просто воссоздавать, а создавать лица несуществующих людей, которые невозможно отличить от настоящих.

Недавно разработчики из Samsung и Сколково представили алгоритм на основе BigGAN, который позволил «оживить» Мону Лизу, то есть для (относительно) хорошего результата нейросети достаточно одного кадра. Нейросеть работает лучше всего, если дать ей несколько изображений человека, снятых под разными углами.

Сейчас на рынке десятки приложений, с помощью которых любой может сделать дипфейк, самые известные – Zao, DeepFaceLab, Deepfakes web β.

Конкурентные преимущества приложений похожи на классический треугольник «цена-качество-скорость»:

– Скорость. Одни выполняют конверсию за секунды, другим нужны часы.

– Необходимое количество исходного материала. Некоторым достаточно одной фотографии.

– Точность итогового результата. Обычно чем больше исходного материала и дольше идёт процесс анализа, тем точнее получается результат.

Год назад NVIDIA представила нейросеть, которая может превращать скетчи в реальные изображения. Технологию назвали GauGAN в честь Поля Гогена. Такую штуку можно использовать в архитектуре, дизайне, создании игр, да где угодно.

Технологию, которая лежит в основе дипфейков, можно использовать и в киноиндустрии, рекламе или при реконструкции исторических событий. Например, с её помощью была сделана социальная реклама, в которой Дэвит Бэкхем рассказывает об опасности малярии на 9и языках.

Музей Сальвадора Дали во Флориде «оживил» художника с помощью всё той же технологии. В результате зрители могли пообщаться с Дали, послушать его истории и даже получить совместное селфи. Для этого потребовалось 6000 фотографий Дали, 1000 часов машинного обучения и 145 видео с актером похожих пропорций, а ещё горы интервью и писем художника, чтобы воспроизвести голос, акцент и манеру речи.

Кстати, алгоритм GAN предлагается использовать и в астрофизике для того, чтобы избавляться от помех и шумов при съёмке космических объектов и получать качественные изображения.

Если вы тоже считаете, что человеческий интеллект создан для творчества, а машинный – для работы, присоединяйтесь к нам на YouTube или в Facebook!

Дипфейки: что это за технология и почему она опасна

Слово deepfake появилось несколько лет назад. Оно объединяет в себе два понятия: глубокое обучение (deep learning), то есть обучение нейросетей, и подделку (fake). Технология дипфейков заключается в синтезе ИИ человеческих изображений: алгоритм объединяет несколько фото, на которых человек изображен с разным выражением лица, и делает из них видео. При этом ИИ анализирует большое количество снимков и учится тому, как может выглядеть и двигаться конкретный человек. Об этом пишет американское издание Forbes.

С распространением дипфейков появились случаи «дискредитации» публичных личностей, чьих изображений много в открытом доступе. Например, весной 2019 года в Сети было опубликовано дипфейк-видео со спикером палаты представителей конгресса США Нэнси Пелоси. Автор ролика с помощью ИИ изменил речь Пелоси так, что она плохо выговаривала слова, и пользователи, посмотревшие видео, посчитали, что политик пьяна. Ситуация вылилась в громкий скандал, и лишь спустя некоторое время было доказано, что речь Пелоси была сгенерирована ИИ.

Этот дипфейк был сделан достаточно просто. Но есть и сложные алгоритмы. Они не просто меняют тембр голоса или замедляют речь, а генерируют такие видео, на которых человек делает то, чего никогда не совершал, или говорит то, чего никогда не говорил. Со временем дипфейки будут становиться все более реалистичными, пишет американское издание Forbes. Уже сейчас технология претендует на то, чтобы влиять на политику, а в дальнейшем такие видео и вовсе смогут стать угрозой национальной безопасности.

Дипфейки: что это такое, зачем и кому они нужны + 13 кейсов

Том Круз решил «побаловать себя»: ест чупа-чупс, находит в нем жвачку и удивляется. Все это, естественно, практически в прямом эфире. Звезды все ближе к обычным людям! Или нет? Нет, это всего лишь deepfake-версия Тома Круза, но сходство впечатляющее, правда?

В этой статье рассказываем о том, что такое дипфейки, как их создают, чем они опасны, а также делимся кейсами их использования не только в формате шуточных видео, но и в «серьезном» маркетинге.

Что такое дипфейки

В начале 2021 года TikTok-видео с участием Тома Круза и правда набрали популярность. Поражают и внешнее сходство дипфейка с актером, и то, как точно передан его знаменитый смех. Этого «Тома Круза» создал Крис Уме, бельгийский специалист по deepfake-эффектам.

Deepfake (deep learning, «глубокое обучение» + fake «фейк, подделка) — методика синтеза изображения, основанная на искусственном интеллекте. Она используется для соединения и наложения существующих изображений и видео на исходные изображения или видеоролики.

В создании дипфейков участвуют GAN — генеративно-состязательные сети. Генеративная часть алгоритма, обучаясь на существующих фото, создает изображение. А состязательная — буквально «соревнуется» с первой частью алгоритма, стараясь отличить настоящие изображения от ненастоящих. В процессе этого соревнования и создаются дипфейки — изображения и видео, которые действительно трудно отличить от реальных, созданных человеком.

Даниил Охлопков, Data Lead в Runa Capital: «Сгенерированные изображения и видео со временем станут реалистичнее. Будет меньше видимых артефактов — следов того, что изображение было сгенерировано нейронной сетью.

Обратите внимание, на первой картинке слева появился перевернутый рот, на второй смазаны зубы. Аналогичные неточности (артефакты) можно находить и на видео с дипфейками.

Сейчас для создания фотореалистичного deepfake необходима постобработка. Это наглядно показали создатели видео, где актер Том Круз баллотируется в президенты США.»

На мой взгляд, технологию ожидает бумообразный рост в ближайшие несколько лет. Нынешний уровень развития технологии и ее перспективы стимулируют интерес, а значит, все больше разработчиков будут применять и использовать ее для решения своих задач. Решения будут все доступнее, дешевле и при этом качественнее.

На развитие будет сильно влиять то, как эта технология воспримется законодательно.

С одной стороны, все понимают, что мировую эволюцию deepfake не сдержать силами государства в отдельных странах.

С другой, это одна из наиболее опасных технологий в рамках текущей парадигмы безопасности, которая поддерживает мнение о том, что биометрия — отличный способ идентифицировать человека.

Григорий Иванов, основатель группы компаний Neutronix

Опасность технологии

У дипфейков практически безграничные возможности: с их помощью можно «заставить» кого угодно говорить и делать что угодно. В 2018 году режиссер Джордан Пил создал видео, на котором Барак Обама говорит об опасности дипфейков и fake news (фальшивые новости) в целом:

«It may sound basic, but how we move forward in the age of information is going to be the difference between whether we survive or whether we become some kind of fucked-up dystopia».

«Это прозвучит банально, но пока мы на пути к веку информации, главный вопрос для нас — сможем ли мы выжить, или мир превратится в какую-то извращенную антиутопию».

На видео Обама ругает Трампа, не стесняясь выражений, и очень легко поверить в то, что это действительно бывший президент США. Видео было создано, чтобы предупредить пользователей об опасности дипфейков, а также призвать их не верить всему, что они видят.

Кроме того, дипфейки могут «помочь» развитию мошенничества в интернете или даже по телефону. В 2019 году CEO британской энергетической компании заплатил мошенникам 220 тыс. евро, потому что думал, что об этом попросил его босс, голос которого в телефонном разговоре сгенерировали киберпреступники.

В связи с этими проблемами появились программы и гранты для тех, кто создаст лучший детектор дипфейков.

Facebook активно занимается изучением дипфейков и способов им противостоять. В созданном компанией Deepfake Detection Challenge поучаствовали более 2 тыс. специалистов. Благодаря этому челленджу у AI-исследователей появятся новые методы для распознавания дипфейков, которые несут угрозу обществу.

В России на похожее исследование было выделено почти 5 млн р.

Будет война генераторов реалистичных дипфейков и их детекторов. Уже сейчас Facebook инвестирует в это направление, а на сайте по анализу данных Kaggle проходят соревнования на лучший детектор дипфейков. Twitter недавно добавил возможность помечать контент как фейк, включая видео с дипфейками. Решением может стать обязательное использование водяных знаков.

Даниил Охлопков, Data Lead в Runa Capital

«Хорошие» кейсы

Дипфейки сами по себе не опасны. Есть и хорошие кейсы использования deepfake-технологий.

Например, дипфейки могут помогать людям. У Microsoft есть приложение Seeing.AI для слепых и слабовидящих людей: cинтезированный голос комментирует все, что происходит вокруг человека с нарушениями зрения, помогая ему ориентироваться в мире

Дипфейки можно применять в образовании. WPP — британский международный холдинг в области коммуникаций, рекламы, связей с общественностью, технологий и торговли. Во время пандемии COVID-19 этой компании понадобилась программа для корпоративного обучения. Это было как раз в разгар локдауна, поэтому сделать видео с реальными спикерами было невозможно.

WPP обратилась к Synthesia, компании, специализирующейся на AI, и те создали для них обучающую программу, где в качестве лекторов выступают deepfake-аватары.

Дипфейки используются и в искусстве. Специалисты из Сколково и Samsung «оживили» Мону Лизу:

Кстати, при создании «Форсаж-7» тоже использовались deepfake-технологии. Получается, в теории они могут помочь решить проблему с дублерами и удешевить производство видеоконтента.

Представьте, как много рекламного и промо-контента можно генерировать даже без участия реальных знаменитостей. Может, в будущем они будут просто продавать свои образы, а студии получат возможность делать невероятный, но очень реалистичный контент. Меньше времени на съемку, возможность участвовать сразу в нескольких проектах одновременно вообще не выходя из дома. Все это — потенциально огромные рекламные контракты.

Юлия Плосконосова, аккаунт-директор Mailfit

Применение в маркетинге и рекламе

Можно ли применять deepfake-технологии в рекламе? Да! Ниже — несколько успешных кейсов, которые могут послужить референсами для ваших рекламных кампаний.

Vivienne Sabo

Бренд косметики — один из российских пионеров применения deepfake-технологий. В 2020 году компания запустила рекламный видеопроект с использованием технологии замены лиц.

На сцене кабаре мог оказаться каждый. Достаточно было загрузить свое фото на специальном лендинге или в приложении на базе Vk Mini Apps и получить видео. Кампания уже завершена, так что сделать видео больше нельзя.

Технология дополненной реальности позволяет покупателю примерить одежду, обувь, бижутерию, попробовать макияж виртуально. Deepfake-технология способна сделать то же самое. В отличие от AR, она показывает не просто то, подходит ли вещь, а как сам человек выглядит с ней со стороны.

Алексей Рыбаков, генеральный директор IT-компании Omega

Clarins

Этот бренд косметики тоже предлагает примерить макияж не выходя из дома. Нужно всего лишь перейти на страницу средства в интернет-магазине и нажать кнопку «Макияж онлайн». Можно загрузить фото из галереи телефона или снять новое. Примерять можно средства для лица, глаз и губ.

Похожие инициативы есть у Maybelline New York, NYX, Armani, Mary Kay, L’Oreal Paris (там даже можно «примерить» цвет волос и определиться с краской) — в общем, у многих марок косметики.

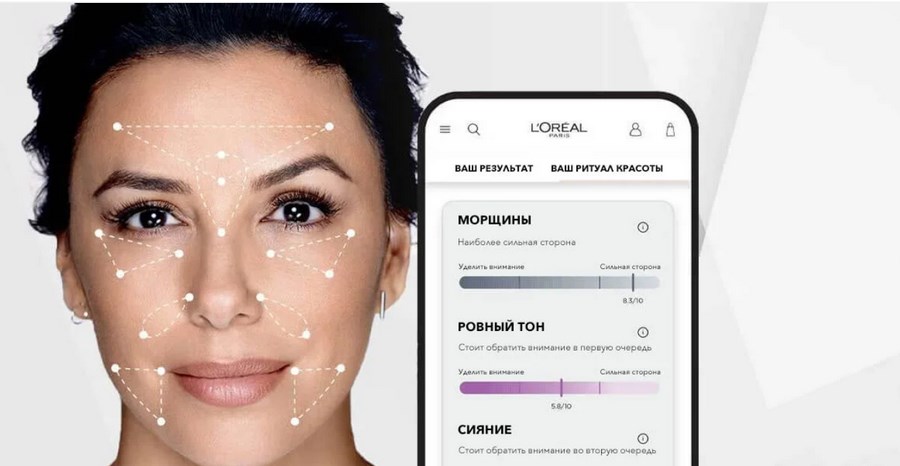

L’Oreal Paris

Кстати, о L’Oreal. У компании есть не только примерка макияжа онлайн. Skin Genius от L’Oreal — это digital-инструмент, который анализирует качество кожи в реальном времени с помощью AI. Программа сравнивает кожу с 10 000 реальных снимков от экспертов-дерматологов и на основе анализа рекомендует активные ингредиенты и конкретные советы и продукты по уходу за кожей.

С помощью deepfake-технологий «Сбер» «вернул к жизни» Жоржа Милославского, героя фильма «Иван Васильевич меняет профессию».

Герой предновогодней рекламы оказался в 2020 году, прокатился на «Ситимобиле», воспользовался приложением «Сбер.Онлайн», послушал музыку в «Сбер.Звуке», оплатил покупки телефоном, получил доставку из «Сбер.Маркета» и попал на концерт NILETTO.

Для воссоздания голоса героя была использована технология text-to-speech и реальные записи речи актера (Леонида Куравлева) общей длиной около 4-х минут. Несмотря на то, что это очень мало, специалистам «Группы ЦРТ» удалось синтезировать голос Милославского.

ESPN & Netflix

ESPN, американский кабельный канал, запустил рекламу документального сериала о Майкле Джордане («The Last Dance»). В рекламе спортивный ведущий Кенни Мэйн в 1998 году делает предсказания о том, что в 2020 ESPN снимет шоу о звезде баскетбола, а еще что «джинсы будут очень узкими», в целом делая отсылки к тому, каким будет будущее. Конечно, это не настоящий Кенни Мэйн, а его deepfake-версия.

Дипфейки удешевляют производство рекламы и любого видеоконтента. Недавно HBO сняла рекламу своего спортивного канала, в котором должны были принять участие звезды NBA. Из-за карантина путешествия и личные встречи со спортсменами были ограничены, поэтому создатели ролика сняли актеров с похожей внешностью, а потом с помощью технологии наложили лица реальных спортсменов.

Чтобы сделать видео, присутствие знаменитости на съемочной площадке вовсе не обязательно, а значит и гонорар звезды может быть значительно меньше.

Даниил Охлопков, Data Lead в Runa Capital

Malaria No More

Если компания работает на несколько рынков, снимать каждый раз новый ролик для каждого языка нет необходимости. Алгоритмы могут настроить движения лица модели и речь под необходимую языковую аудиторию.

Алексей Рыбаков, генеральный директор IT-компании Omega

Deepfake-технологии могут помочь брендам привлечь клиентов с помощью целенаправленных и персонализированных сообщений. Инфлюенсерам и селебрити дипфейки помогут больше и лучше взаимодействовать с аудиторией. Например, знаменитость может выступить в рамках модной рекламной кампании, даже не приходя на фотосессию.

Deepfake помогает повысить вовлечннность. К примеру, в 2020 году приложение Reface AI позволило пользователям виртуально примерить одежду Gucci.

В ретейле есть перспективы персонализировать обслуживание клиентов, используя deepfake-помощника, который обрабатывает онлайн-запросы, разговаривая с клиентом на одном языке. Так покупатели могут разговаривать с «настоящим» лицом, что повышает доверие к сервису.

Виталий Миняйло, сооснователь и СЕО IT-компании neurotrack.tech

Онлайн-примерочная

Русскоязычный разработчик Алексей Чаплыгин создал технологию, которая позволяет виртуально изменять параметры тела. Автор разрабатывал технологию для виртуальных примерочных, чтобы люди при просмотре одежды в интернет-магазине могли видеть вещи на себе, а не на моделях.

Бизнесу можно и нужно использовать дипфейки, если соблюдены два условия: на это есть колоссальные бюджеты, и остальные способы персонализации взаимодействия с аудиторией уже испробованы.

Сегодня deepfake — все еще дорогая технология, доступная далеко не каждой компании. Компаниям со скромными бюджетами предлагаем вместо одного взрывного ролика разработать грамотную стратегию продвиженияи вложиться в постоянный стабильный рост.

Раньше обращение телевизионной картинки прямо к конкретному зрителю было лишь сюжетом фантастических фильмов. Но теперь один и тот же рекламный ролик может быть настроен, например, под имя конкретного пользователя или сегмент целевой аудитории, которые не смогут понять, что движениями губ управляют алгоритмы, а не человек.

Алексей Рыбаков, генеральный директор IT-компании Omega

Скорее всего, технология станет привычным инструментом типа Photoshop. Ее можно будет использовать как в хороших целях — удешевление стоимости видеопродакшена с дорогими актерами, так и в сомнительных — для создания фейковых видео с известными личностями.

Даниил Охлопков, Data Lead в Runa Capital

Что думаете о развитии дипфейков? Видите в них качественный рекламный инструмент или пока не готовы использовать в работе?