что такое обратная энтропия

Введение в понятие энтропии и ее многоликость

Как может показаться, анализ сигналов и данных — тема достаточно хорошо изученная и уже сотни раз проговоренная. Но есть в ней и некоторые провалы. В последние годы словом «энтропия» бросаются все кому не лень, толком и не понимая, о чем говорят. Хаос — да, беспорядок — да, в термодинамике используется — вроде тоже да, применительно к сигналам — и тут да. Хочется хотя бы немного прояснить этот момент и дать направление тем, кто захочет узнать чуть больше об энтропии. Поговорим об энтропийном анализе данных.

В русскоязычных источниках очень мало литературы на этот счет. А цельное представление вообще получить практически нереально. Благо, моим научным руководителем оказался как раз знаток энтропийного анализа и автор свеженькой монографии [1], где все расписано «от и до». Счастью предела не было, и я решила попробовать донести мысли на этот счет до более широкой аудитории, так что пару выдержек возьму из монографии и дополню своими исследованиями. Может, кому и пригодится.

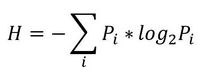

Итак, начнем с начала. Шенноном в 1963 г. было предложено понятие меры усредненной информативности испытания (непредсказуемости его исходов), которая учитывает вероятность отдельных исходов (до него был еще Хартли, но это опустим). Если энтропию измерять в битах, и взять основание 2, то получим формулу для энтропии Шеннона

То есть в этом случае энтропия напрямую связана с «неожиданностью» возникновения события. А отсюда вытекает и его информативность — чем событие более предсказуемо, тем оно менее информативно. Значит и его энтропия будет ниже. Хотя открытым остается вопрос о соотношениях между свойствами информации, свойствами энтропии и свойствами различных ее оценок. Как раз с оценками мы и имеем дело в большинстве случаев. Все, что поддается исследованию — это информативность различных индексов энтропии относительно контролируемых изменений свойств процессов, т.е. по существу, их полезность для решения конкретных прикладных задач.

Энтропия сигнала, описываемого некоторым образом (т.е. детерминированного) стремится к нулю. Для случайных процессов энтропия возрастает тем больше, чем выше уровень «непредсказуемости». Возможно, именно из такой связки трактовок энтропии вероятность->непредсказуемость->информативность и вытекает понятие «хаотичности», хотя оно достаточно неконкретно и расплывчато (что не мешает его популярности). Встречается еще отождествление энтропии и сложности процесса. Но это снова не одно и то же.

Для того, чтобы немного обрисовать области применения энтропии к анализу данных, рассмотрим небольшую прикладную задачку из монографии [1] (которой нет в цифровом виде, и скорей всего не будет).

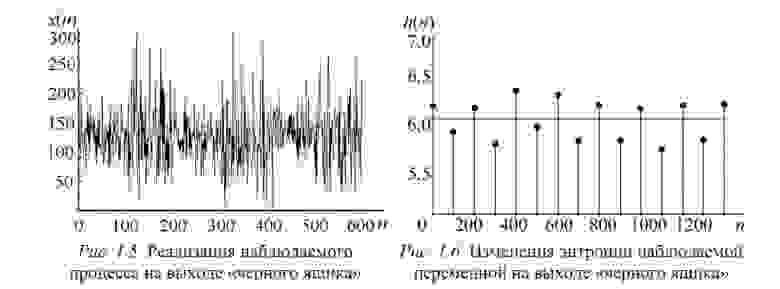

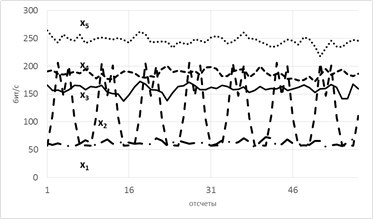

Пусть есть система, которая каждые 100 тактов переключается между несколькими состояниями и порождает сигнал x (рисунок 1.5), характеристики которого изменяются при переходе. Но какие — нам не известно.

Разбив x на реализации по 100 отсчетов можно построить эмпирическую плотность распределения и по ней вычислить значение энтропии Шеннона. Получим значения, «разнесенные» по уровням (рисунок 1.6).

Как можно видеть, переходы между состояниями явно наблюдаются. Но что делать в случае, если время переходов нам не известно? Как оказалось, вычисление скользящим окном может помочь и энтропия так же «разносится» на уровни.В реальном исследовании мы использовали такой эффект для анализа ЭЭГ сигнала (разноцветные картинки про него будут дальше).

Теперь еще про одно занятное свойство энтропии — она позволяет оценить степень связности нескольких процессов. При наличии у них одинаковых источников мы говорим, что процессы связаны (например, если землетрясение фиксируют в разных точках Земли, то основная составляющая сигнала на датчиках общая). В таких случаях обычно применяют корреляционный анализ, однако он хорошо работает только для выявления линейных связей. В случае же нелинейных (порожденных временными задержками, например) предлагаем пользоваться энтропией.

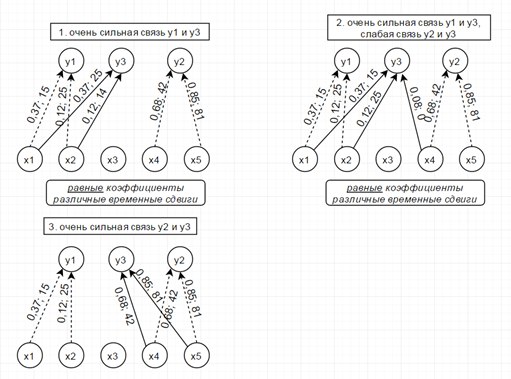

Рассмотрим модель из 5ти скрытых переменных(их энтропия показана на рисунке ниже слева) и 3х наблюдаемых, которые генерируются как линейная сумма скрытых, взятых с временными сдвигами по схеме, показанной ниже справа. Числа-это коэффициенты и временные сдвиги (в отсчетах).

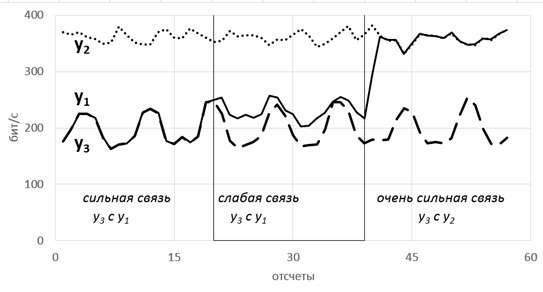

Так вот, фишка в том, что энтропия связных процессов сближается при усилении их связи. Черт побери, как это красиво-то!

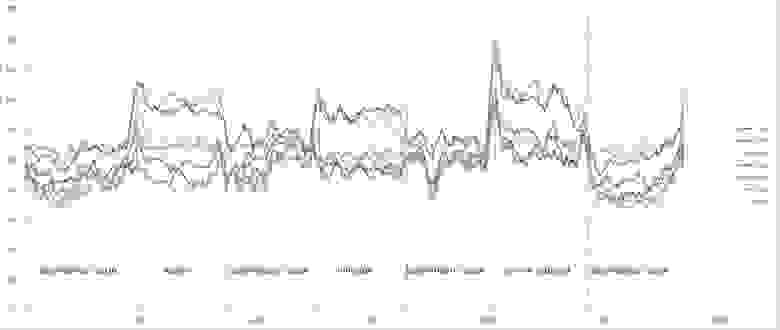

Такие радости позволяют вытащить практически из любых самых странных и хаотичных сигналов (особенно полезно в экономике и аналитике) дополнительные сведения. Мы их вытаскивали из электроэнцефалограммы, считая модную нынче Sample Entropy и вот какие картинки получили.

Можно видеть, что скачки энтропии соответствуют смене этапов эксперимента. На эту тему есть пара статей и уже защищена магистерская, так что если кому будут интересны подробности — с радостью поделюсь. А так по миру по энтропии ЭЭГ ищут уже давно разные вещи — стадии наркоза, сна, болезни Альцгеймера и Паркинсона, эффективность лечения от эпилепсии считают и тд. Но повторюсь-зачастую расчеты ведутся без учета поправочных коэффициентов и это грустно, так как воспроизводимость исследований под большим вопросом (что критично для науки, так то).

Резюмируя, остановлюсь на универсальности энтропийного аппарата и его действительной эффективности, если подходить ко всему с учетом подводных камней. Надеюсь, что после прочтения у вас зародится зерно уважения к великой и могучей силе Энтропии.

Трактат об энтропии

Приветствую тебя, читатель Гиктаймс!

Многие слышали о такой загадочной штуке, как энтропия. Обычно её называют мерой хаоса, мерой неопределённости и ещё прибавляют, что она непременно растёт. Я с огромной болью переношу употребление имени Энтропии всуе и решил, наконец, написать ликбез по этому вопросу.

Второе начало

Что будет, если бросить футбольный мяч на землю? Очевидно, он несколько раз подпрыгнет, причём каждый следующий раз на всё меньшую высоту, а затем и вовсе упокоится на земле. А что будет, если в горячий чай опустить металлическую ложку? Ложка нагреется, чай остынет. Ничего сложного, не так ли? В каждом из этих примеров направление протекания процессов кажется очевидным: мяч не может подпрыгивать выше и выше и даже не может вечно подпрыгивать до одной высоты, а чай не может ещё больше охладить ложку. Из таких житейских очевидностей были выведены два постулата (равноценных), каждый из которых может в равной степени называться вторым началом термодинамики:

— единственным результатом любой совокупности процессов не может быть переход теплоты от менее нагретого тела к более нагретому (постулат Клаузиуса);

— теплота наиболее холодного из участвующих в процессе тел не может служить источником работы (постулат Томсона), т.е. единственным результатом любой совокупности процессов не может быть превращение теплоты в работу.

Не зря эти два утверждения названы постулатами, они аксиоматичны, доказать их нельзя, они лишь подтверждаются своими следствиями и всем человеческим опытом.

Вроде всё и ясно: горячие тела остывают, холодные нагреваются, энергия рассеивается. Но как насчёт ещё одной задачки? Смешали по 1 моль водорода, азота и аммиака при температуре 500 o С в реакторе объёмом 10 литров в присутствии катализатора:

В какую сторону пойдёт реакция: образования аммиака или его разложения? Ммм… Кажется, нам нужно больше уравнений.

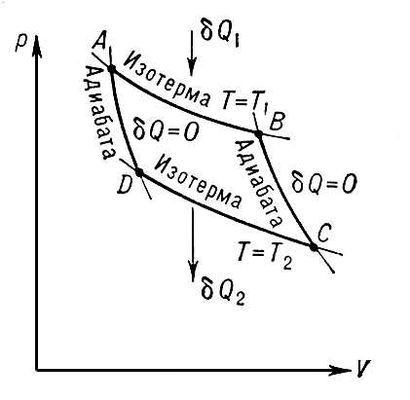

Цикл дедушки Карно

где Qн и Qх — количество теплоты, полученное от нагревателя и отданное холодильнику соответственно, Tн и Tх — температуры нагревателя и холодильника.

т.е., работа, совершаемая второй машиной, идет на перенос тепла от холодильника к нагревателю первой (помним, что теплота, полученная телом, положительна, теплота, отданная окружающей среде, — отрицательна, работа, совершенная телом, — положительна, работа, совершенная над телом, — отрицательна; в формуле КПД все знаки уже учтены, поэтому теплоты берутся по модулю).

Пусть КПД второй машины больше, чем КПД первой, тогда с учётом (3) имеем:

Логично предположить, что условие (4) неверно, а значит, верно:

Если вторая машина работает равновесно и обратимо, то система становится симметричной, т.е. первую и вторую машину можно поменять ролями и ничего не изменится. Очевидно, этому случаю отвечает знак равенства. Отсюда можно сделать вывод о том, что КПД машины, работающей по циклу Карно, не зависит от природы рабочего тела. Таким образом, для установления формулы КПД достаточно рассмотреть любой частный случай. Уравнение (1) было получено из решения для идеального газа. Также можно сделать вывод о том, что КПД (как и работа) машины, работающей необратимо и неравновесно, меньше КПД машины, работающей обратимо и равновесно.

Функции, изменение которых в результате любого циклического процесса равно нулю, называют функциями состояния. Их значение не зависит от пути процесса, а определяется только конечным состоянием.

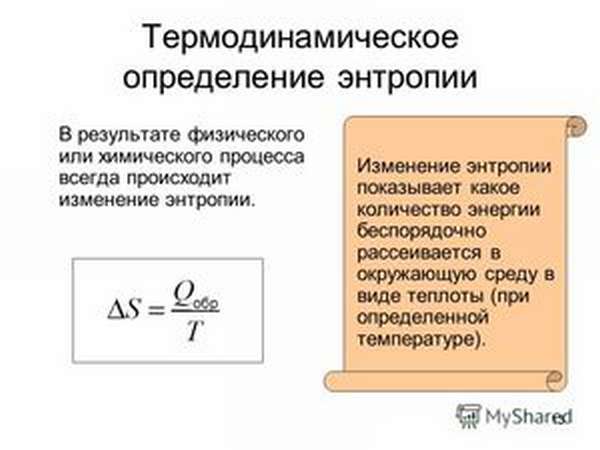

Функцию состояния системы, изменение которой в ходе равновесного процесса равно отношению теплоты процесса к температуре его протекания, назвали энтропией:

(знак равенства относится к равновесным процессам, а знак больше — к неравновесным).

Если система изолирована, то есть не обменивается с окружающей средой ни веществом, ни энергией, то Q=0 (система не обменивается теплотой с окружающей средой), тогда:

или энтропия изолированной системы возрастает в неравновесных процессах и остаётся прежней в равновесных, или энтропия изолированной системы не убывает.

Amen. Мы дошли до той самой формулировки второго начала термодинамики!

Итого, из сказанного выше, никак нельзя сказать, что энтропия — мера чего-либо, это просто функция. Расти всегда она не обязана, никто не запрещает ей убивать убывать.

По пути мы решили ту самую задачку про моли (да придётся пролистать назад, я и сам её забыл, всё-таки, термодинамика – захватывающая штука!). Чтобы решить, в какую сторону пойдёт реакция, нужно изолировать систему и посчитать изменение энтропии в ходе процесса: будет убывать – туда не пойдёт, будет возрастать – туда пойдёт, ну и остаётся вариант с равновесием, чтобы остановиться и передохнуть.

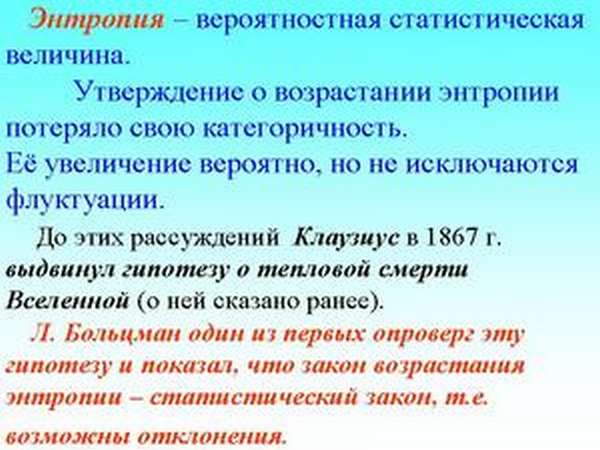

Что ж, с байкой про «энтропия всегда растёт» всё ясно: кто-то не дочитал «изолированной системы», но поспешил нести истину (с) в массы. А вот что с «мерой хаоса»? Я покажу вам ещё один подход.

The second father

Но поглазели и хватит, вернёмся к теме разговора. Термодинамическая вероятность тоже позволяет судить о пути протекания процесса: если мы идём из состояния (макросостояния), W которого ничтожно мала, к состоянию с огромным ЧСВ W, то можно уверенно сказать, что процесс пойдёт. Верно и обратное. Осталось связать W и S. Ничего сложного, тем более за нас это сделал Больцман:

где k – постоянная Больцмана.

Обнаружив такую связь, можно определённо заявить, что с ростом энтропии растёт термодинамическая вероятность, то есть растёт количество вариантов на микроуровне, которые реализуют один вариант на макроуровне. Такое огромное число вариантов реализации одного состояния некоторые назвают хаосом, но я сделать это никак не возмусь. Весь этот «хаос» подчинен закономерностям и Великому Рандому, который не хаос, а именно что Господин Случай. Я бы назвал энтропию – с точки зрения вероятностного подхода – мерой инвариантности системы и вам советую поступать так же!

Дописанная пятая страница в wordе мне подсказывает, что пора закругляться, хотя хотелось бы ещё сказать пару слов о границах применимости энтропии, её характере и тепловой смерти Вселенной. Но это потом, а сейчас пора спать…

Энтропия что это такое: объяснение термина простыми словами

Энтропия: определение и история появления термина

История появления термина

Энтропия как определение состояния системы была введена в 1865 году немецким физиком Рудольфом Клаузиусом, чтобы описать способность теплоты превращаться в другие формы энергии, главным образом в механическую. С помощью этого понятия в термодинамике описывают состояние термодинамических систем. Приращение этой величины связано с поступлением тепла в систему и с температурой, при которой это поступление происходит.

Определение термина из Википедии

Этот термин долгое время использовался только в механической теории тепла (термодинамике), для которой оно вводилось. Но со временем это определение перешло в другие области и теории. Существует несколько определений термина «энтропия».

Википедия даёт краткое определение для нескольких областей, в которых этот термин используется:«Энтропия (от др.-греч. ἐντροπία «поворот»,«превращение») — часто употребляемый в естественных и точных науках термин. В статистической физике характеризует вероятность осуществления какого-либо макроскопического состояния. Помимо физики, этот термин широко используется в математике: теории информации и математической статистике».

Виды энтропий

Этот термин используется в термодинамике, экономике, теории информации и даже в социологии. Что же он определяет в этих областях?

В физической химии (термодинамике)

Энтропия — это мера беспорядка. Как определить беспорядок? Один из способов — приписать каждому состоянию число вариантов, которыми это состояние можно реализовать. И чем больше таких способов реализации, тем больше значение энтропии. Чем больше организованно вещество (его структура), тем ниже его неопределённость (хаотичность).

Абсолютное значение энтропии (S абс.) равно изменению имеющейся у вещества или системы энергии во время теплопередачи при данной температуре. Его математическая величина определяется из значения теплопередачи (Q), разделённого на абсолютную температуру (T), при которой происходит процесс: S абс. = Q / T. Это означает, что при передаче большого количества теплоты показатель S абс. увеличится. Тот же эффект будет наблюдаться при теплопередаче в условиях низких температур.

В экономике

В статистической физике или теории информации

Информационная энтропия (неопределённость)— это мера непредсказуемости или неопределённости некоторой системы. Эта величина помогает определить степень беспорядочности проводимого эксперимента или события. Чем больше количество состояний, в которых может находиться система, тем больше значение неопределённости. Все процессы упорядочивания системы приводят к появлению информации и снижению информационной неопределённости.

С помощью информационной непредсказуемости можно выявить такую пропускную способность канала, которая обеспечит надёжную передачу информации (в системе закодированных символов). А также можно частично предсказывать ход опыта или события, деля их на составные части и высчитывая значение неопределённости для каждой из них. Такой метод статистической физики помогает выявить вероятность события. С его помощью можно расшифровать закодированный текст, анализируя вероятность появления символов и их показатель энтропии.

Существует такое понятие, как абсолютная энтропия языка. Эта величина выражает максимальное количество информации, которое можно передать в единице этого языка. За единицу в этом случае принимают символ алфавита языка (бит).

В социологии

Энтропия: тезисно и на примерах

Пример 1. Программа Т9. Если в слове будет небольшое количество опечаток, то программа легко распознает слово и предложит его замену. Чем больше опечаток, тем меньше информации о вводимом слове будет у программы. Следовательно, увеличение беспорядка приведёт к увеличению информационной неопределённости и наоборот, чем больше информации, тем меньше неопределённость.

Пример 2. Игральные кости. Выкинуть комбинацию 12 или 2 можно только одним способом: 1 плюс 1 или 6 плюс 6. А максимальным числом способов реализуется число 7 (имеет 6 возможных комбинаций). Непредсказуемость реализации числа семь самая большая в этом случае.

Пример. Н2О (всем известная вода) в своём жидком агрегатном состоянии будет обладать большей энтропией, чем в твёрдом (лёд). Потому что в кристаллическом твёрдом теле каждый атом занимает определённое положение в кристаллической решётке (порядок), а в жидком состоянии у атомов определённых закреплённых положений нет (беспорядок). То есть тело с более жёсткой упорядоченностью атомов имеет более низкое значение энтропии (S). Белый алмаз без примесей обладает самым низким значением S по сравнению с другими кристаллами.

Пример 2. Чем выше порядок на рабочем столе, тем больше информации можно узнать о вещах, которые на нём находятся. В этом случае упорядоченность предметов снижает энтропию системы «рабочий стол».

Пример 3. Информация о классе больше на уроке, чем на перемене. Энтропия на уроке ниже, так как ученики сидят упорядочено (больше информации о местоположении каждого ученика). А на перемене расположение учеников меняется хаотично, что повышает их энтропию.

Пример. При реакции щелочного металла с водой выделяется водород. Водород-это газ. Так как молекулы газа движутся хаотично и имеют высокую энтропию, то рассматриваемая реакция происходит с увеличением её значения. То есть энтропия химической системы станет выше.

В заключение

Если объединить всё вышесказанное, то получится, что энтропия является мерой беспорядка или неопределённости системы и её частей. Интересен тот факт, что всё в природе стремится к максимуму энтропии, а человек — к максимуму информации. И все рассмотренные выше теории направлены на установление баланса между стремлением человека и естественными природными процессами.

Что такое энтропия и как с ней бороться

Игорь Гладкобородов

Возьмите собранный кубик Рубика и начните произвольно поворачивать его грани. Через несколько поворотов он будет абсолютно разобран. Теперь продолжайте случайным образом поворачивать грани кубика до тех пор, пока он не соберется обратно.

Довольно быстро вы поймете, что ничего у вас не получится, но не расстраивайтесь: вы не собрали кубик Рубика, зато проиллюстрировали второе начало термодинамики:

Энтропия изолированной системы не может уменьшаться.

Героиня фильма Вуди Аллена Whatever Works дает такое определение энтропии: это из-за чего тяжело засунуть обратно в тюбик зубную пасту. Она еще интересно объясняет принцип неопределенности Гейзенберга, еще один повод посмотреть фильм.

Энтропия — это мера беспорядка, хаоса. Вы пригласили друзей на новогоднюю вечеринку, прибрались, помыли пол, разложили на столе закуску, расставили напитки. Одним словом, все упорядочили и устранили столько хаоса, сколько смогли. Это система с маленькой энтропией.

Вы все, наверное, представляете, что происходит с квартирой, если вечеринка удалась: полный хаос. Зато у вас утром есть в распоряжении система с большой энтропией.

Для того, чтобы привести квартиру в порядок, надо прибраться, то есть потратить на это много энергии. Энтропия системы уменьшилась, но никакого противоречия со вторым началом термодинамики нет — вы же добавили энергию извне, и эта система уже не изолированная.

Неравный бой

В общем случае звучит все довольно уныло: в природе все упорядоченные вещи стремятся к разрушению, к хаосу. Но откуда тогда на Земле жизнь? Все живые организмы невероятно сложные и упорядоченные и каким-то образом всю свою жизнь борются с энтропией (хотя в конце концов она всегда побеждает).

Все очень просто. Живые организмы в процессе жизнедеятельности перераспределяют энтропию вокруг себя, то есть отдают свою энтропию всему, чему только могут. Например, когда мы едим бутерброд, то красивый упорядоченный хлеб с маслом мы превращаем известно во что. Получается, что свою энтропию мы отдали бутерброду, а в общей системе энтропия не уменьшилась.

А если взять Землю в целом, то она вообще не является замкнутой системой: Солнце снабжает нас энергией на борьбу с энтропией.