что такое дипфейк приведите примеры

Технологии Deepfake как угроза информационной безопасности

В сети «Интернет» некоторое время назад возникло новое явление — т.н. дипфейки (deepfake), поддельный контент с наложением лиц и голосов известных людей на видеоматериалы различного содержания с применением технологий искусственного интеллекта. Мы расскажем о том, что такое Deepfake, чем он опасен и как подобные технологии могут использоваться киберпреступниками.

Что такое дипфейк?

Deepfake (от англ. deep learning — «глубокое обучение» и fake — «фальшивый») — реалистичная манипуляция аудио- и видеоматериалами с помощью искусственного интеллекта. Эта технология заставляет человека говорить то, чего он не произносил, и делать то, чего он никогда не совершал.

Технология Deepfake уходит корнями в далёкие девяностые. В то время подобными инструментами обладали лишь эксперты по спецэффектам в киноиндустрии. Впоследствии технология была доработана в интернет-сообществе, и программное обеспечение для создания дипфейков появилось в открытом доступе. В последнее время технология Deepfake привлекает большое внимание из-за её использования в финансовых махинациях, розыгрышах и фальшивых новостях (fake news).

Deepfake применяет возможности искусственного интеллекта для синтеза человеческого изображения: объединяет несколько снимков, на которых человек запечатлён с разных ракурсов и с разным выражением лица, и делает из них видеопоток. Анализируя фотографии, специальный алгоритм обучается тому, как выглядит и может двигаться человек. При этом работают две нейросети. Первая из них генерирует изображения, а вторая отвечает за поиск отличий между ними и настоящими образцами. В случае если вторая нейросеть обнаруживает подделку, изображение отправляется обратно первой для усовершенствования.

Deepfake работает при помощи открытых алгоритмов машинного обучения и библиотек, что позволяет достичь высшего качества контента. Нейросеть получает изображения из библиотеки и обучается при помощи роликов на видеохостингах. Искусственный интеллект тем временем сопоставляет фрагменты исходных портретов с тем, что есть на видео, и в итоге получается правдоподобный материал.

Чем опасна технология Deepfake?

В 2018 году появилась первая публичная программа для подмены лиц под названием FakeApp, которая открыла дипфейк-инструменты простому обывателю. Наборы для создания такого контента находятся с тех пор в свободном доступе и легки в освоении. Любой человек, который имеет доступ к интернету, свободное время, цели и мотивацию, может в режиме реального времени создавать фальшивый контент и наполнять им каналы социальных сетей.

Первые поддельные видеоролики стали появляться ещё в 2017 году. Поначалу большинство дипфейк-контента выглядело просто забавно: это были в основном любительские видеофайлы, созданные с использованием бесплатных инструментов и содержавшие лица знаменитостей, наложенные на порнографические записи. Однако за несколько лет технология развилась настолько, что создаваемые с её помощью материалы стали пугающе убедительными. Широкую известность она получила после того, как один из пользователей сайта Reddit с никнеймом Deepfakes разместил у себя на странице видео, где лицо актрисы из порнофильма удачно заменили на лицо актрисы Галь Гадот.

В качестве примера громкого дипфейка можно привести опубликованное в 2018 году фальшивое видео с экс-президентом США Бараком Обамой, где он якобы оскорбляет нынешнего главу американского государства. Видеоролик был сделан при помощи программ FakeApp и Adobe After Effects.

В середине 2019 года в Сети появилось сфабрикованное видео с Марком Цукербергом, который будто бы откровенно обрисовал текущее положение дел с персональными данными людей. В том же году в интернете опубликовали дипфейк-видео со спикером палаты представителей конгресса США Нэнси Пелоси. Автор ролика с помощью технологий искусственного интеллекта изменил речь Пелоси так, что она плохо выговаривала слова, и пользователи, посмотревшие видео, посчитали, что политик находится в состоянии алкогольного опьянения. Всё это переросло в большой скандал, и лишь спустя некоторое время было доказано, что речь Пелоси была сгенерирована компьютером.

В июне 2019 года пользователи увидели алгоритм DeepNude, который научился раздевать девушек на фотографиях. Если до этого подобные программы просто подменяли лица, то новый алгоритм самостоятельно перерисовывает тело героини снимка. Достаточно было загрузить изображение в программу и несколько секунд подождать.

Описанные события заставили правительство и промышленность Соединённых Штатов выявлять и ограничивать незаконное использование дипфейков. В октябре 2019 года губернатор Калифорнии Гэвин Ньюсом подписал документ AB 730, известный как «антидипфейк-законопроект», в котором говорится о запрете распространения дипфейк-видео во время предвыборной кампании в 2020 году.

В дополнение ко всему перечисленному существуют и технологии подделки голосов. Голосовые дипфейки также используются киберпреступниками — в частности, для того, чтобы убедить сотрудников какой-либо компании осуществить несанкционированные действия. Далее в статье мы расскажем об этом подробнее.

Deepfake как угроза для информационной безопасности бизнеса

Помимо политических информационных войн Deepfake создаёт и риски в области информационной безопасности корпоративного сектора. Дипфейки оказались неплохим инструментом в руках мошенников.

Например, целевой фишинг (англ. spearphishing) направлен на то, чтобы обмануть конкретных сотрудников определённой компании и заставить их выполнить вручную какую-нибудь операцию — оплату поддельного платёжного поручения, отправку документов, ручной сброс учётных данных пользователя для киберпреступника. Такие действия, как правило, труднее обнаружить технически (с точки зрения средств защиты информации), так как электронное письмо не содержит никаких подозрительных ссылок или вложений и обычно используется в сочетании с атакой Business E-mail Compromise (BEC), когда хакеры получают контроль над корпоративной учётной записью электронной почты и могут отправлять письма с легитимных адресов. По данным ФБР, за последние три года атаки типа BEC обошлись компаниям по всему миру более чем в 26 млрд долларов США.

Дипфейки имеют возможность «перегружать» подобные операции. Например, сотрудник компании получает электронное письмо от генерального директора с просьбой принять некоторые финансовые меры, затем ему приходит текстовое послание с мобильного номера того же топ-менеджера, а потом — и аудиосообщение, где голос генерального директора называет работника по имени и ссылается на предыдущие разговоры с ним. Скорее всего, сотрудник не задумается о том, дипфейк это или нет.

В качестве примера такой атаки можно привести инцидент, который произошёл в августе 2019 года в одной компании, которая работает в сфере энергетики. Было установлено, что киберпреступник использовал технологию создания дипфейков для осуществления мошеннических действий на сумму в 220 000 евро. Злоумышленник вышел на связь с финансовым отделом как управляющий из Германии. Он смоделированным голосом попросил срочно перевести деньги на счёт в Венгрии, и у бизнес-партнеров не было ни единого повода не верить звонящему.

Как бороться с дипфейками

Проблема дипфейков кажется весьма сложной. Поскольку они создаются с помощью искусственного интеллекта, для борьбы с ними нужно использовать нечто аналогичное.

В настоящее время рынок ИБ не предлагает специальных технологий и решений для защиты от дипфейков. Тем не менее, определённые шаги в данном направлении совершаются. Например, Facebook, Microsoft и исследователи из американских университетов начали разработку инструментов для обнаружения подобных подделок, а также в сотрудничестве с Amazon решили провести конкурс Deepfake Detection Challenge на лучший способ определения дипфейк-видео.

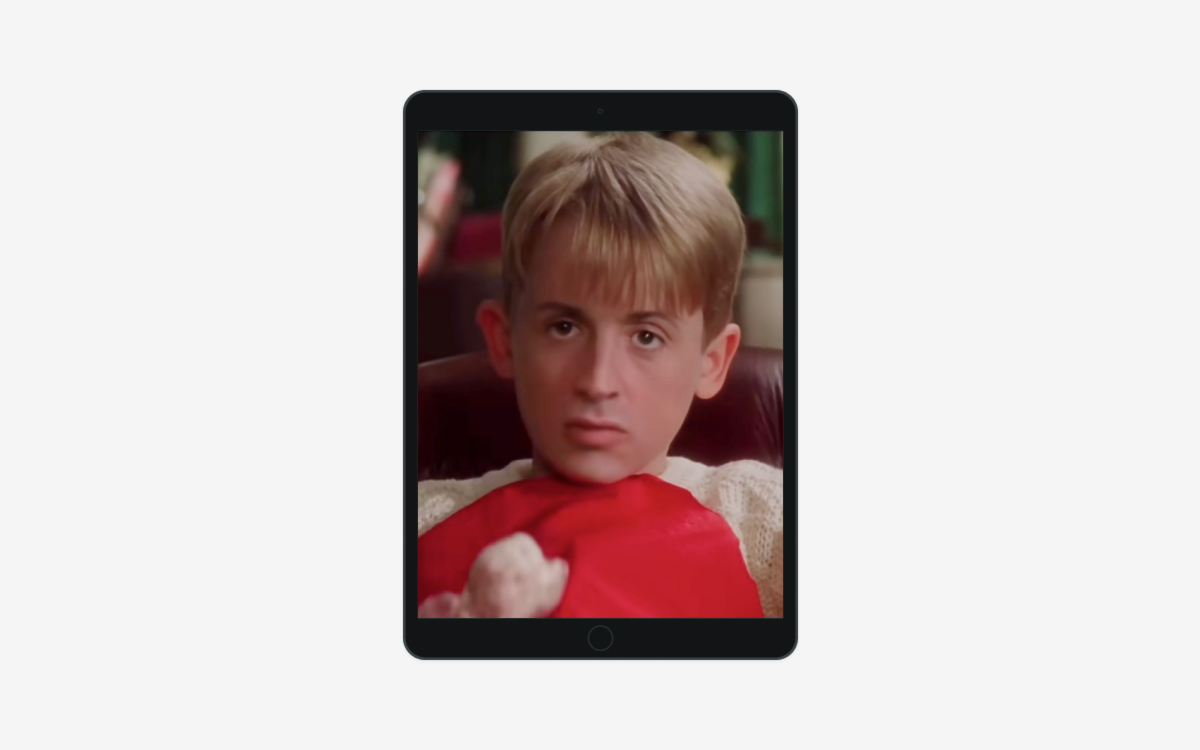

Управление перспективных исследовательских проектов Министерства обороны США (DARPA) запустило алгоритм выявления поддельных видеоматериалов. В статье «In Ictu Oculi: Exposing AI Generated Fake Face Videos by Detecting Eye Blinking» рассказывается о том, как анализ частоты моргания может помочь обнаружить дипфейк. Идея такова: обычно в открытом доступе трудно найти фотографии человека в момент моргания, так что нейронной сети просто не на чем учиться генерировать подобные кадры. Кроме того, у оригинала и подделки могут различаться некоторые примечательные части лица (подбородок, брови, скулы, усы и борода, веснушки и родимые пятна); любое несоответствие – свидетельство дипфейка. В качестве примера можно это увидеть на видео «Билл Хейдер пародирует Тома Круза с помощью нейросети».

Для того чтобы минимизировать риски целевых фишинговых атак при помощи дипфейков в корпоративной среде, необходимо информировать пользователей о новых типах вредоносной активности и быть начеку в ситуациях, когда поведение собеседника в телефонном разговоре или голосовом сообщении кажется необычным. Кроме того, рекомендуется:

Чтобы показать, насколько доступным стало создание дипфейков, рассмотрим несколько примеров бесплатных программ для генерации подобного контента.

Примеры бесплатных дипфейк-приложений и инструментов

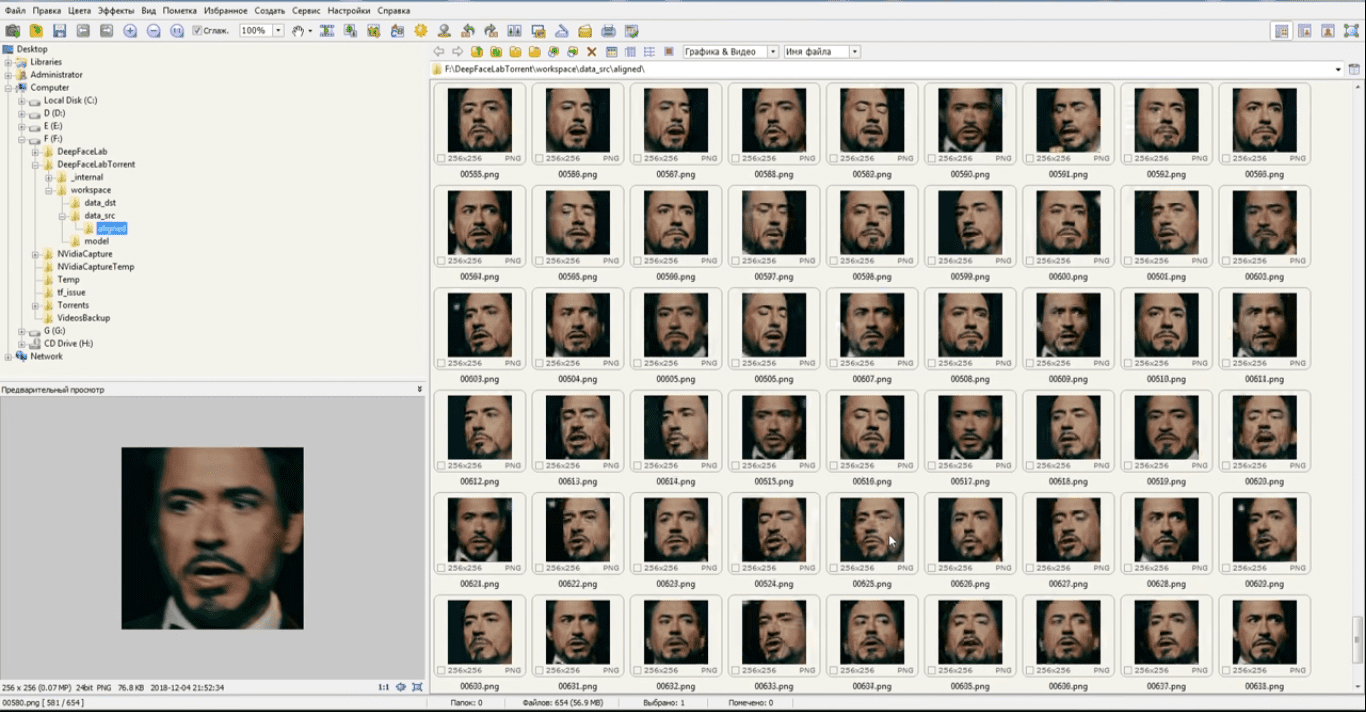

DeepFaceLab

Бесплатное ПО DeepFaceLab является одним из наиболее популярных приложений для создания дипфейков и использует новые нейронные сети для замены лиц в видео. Программа размещена на GitHub, исходный код выложен пользователем iperov. По словам разработчика, более 95% глубоких подделок видео создаётся с помощью DeepFaceLab.

Рисунок 1. Обработка изображения для создания дипфейка в ПО DeepFaceLab

DeepFaceLab распространяется в виде набора пакетных файлов для ОС Windows. Минимальные системные требования — 2 ГБ ОЗУ и место для файла подкачки, а также OpenCL-совместимая видеокарта с объёмом ОЗУ не менее 256 МБ.

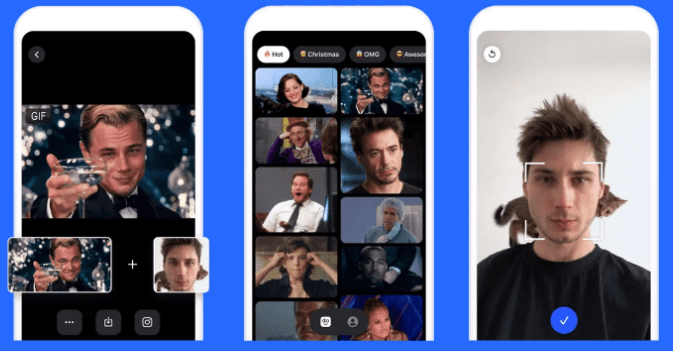

Doublicat

Разработчики сервиса Reflect в декабре 2019 года представили бесплатное приложение Doublicat для Android и iOS. Программа позволяет реалистично менять лица на двух фотографиях.

Рисунок 2. Обработка изображения для создания GIF-дипфейка в Doublicat

Для создания изображения нужно сделать селфи, а затем выбрать какой-либо из знаменитых GIF-мемов и вставить туда своё лицо.

В начале января приложение Doublicat стало вирусным. О нём написали десятки западных изданий.

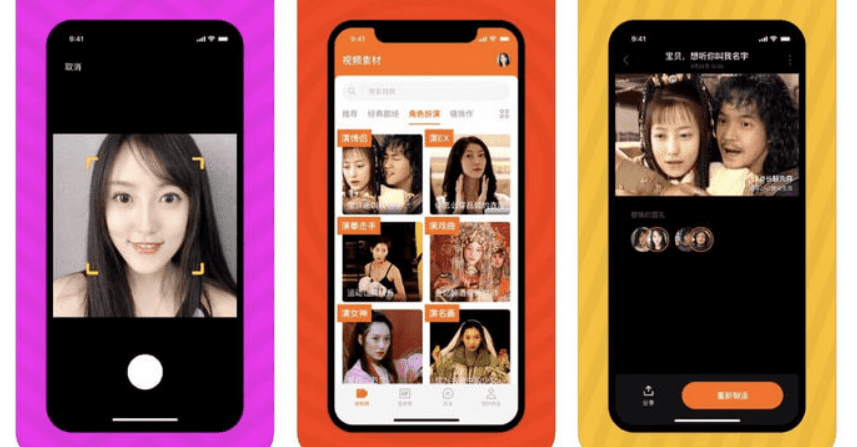

Бесплатное китайское дипфейк-приложение Zao для Android и iOS может заменить лицо известного героя или актёра на лицо пользователя в любом отрывке популярного фильма, сериала, шоу или клипа, и при этом не понадобится вдаваться в тонкости и нюансы монтажа и обработки видео. Zao позволяет модулировать голоса знаменитостей и накладывать своё лицо на тело актёра в сцене. Приложение предоставляет множество видеоклипов и нарядов, а также обширные возможности для изучения. В большинстве случаев результат выглядят не идеальным, но забавным.

Рисунок 3. Обработка изображения для создания видео-дипфейка в Zao

Многие пользователи сочли, что приложение может оказаться небезопасным, поскольку в политике конфиденциальности указано, что компания-разработчик Momo вправе применять сгенерированные видеоролики в собственных целях (т.е. ей принадлежит весь созданный программой контент).

Выводы

С распространением технологии Deepfake появилась опасность дискредитации любого пользователя, чей снимок или голос есть в общем доступе. Технологии создания дипфейков постоянно совершенствуются, и уже через несколько лет можно ожидать появления настолько естественно выглядящих или звучащих подделок, что выявить их можно будет только после тщательного анализа с использованием искусственного интеллекта.

При этом наиболее перспективные направления использования дипфейков — политические войны и мошенничество. Кроме того, с учётом постоянного совершенствования технологий дипфейки могут также навредить и судебной практике — в части доверия к аудио- и видеоматериалам доказательной базы (диктофонным записям, файлам видеорегистраторов и т.п.).

В настоящее время рынок ИБ не предлагает специализированных решений для защиты от дипфейков. Развитие инструментов, способных распознать поддельный контент, пока находится в зачаточном состоянии. Единственное решение, которое существует в настоящее время, заключается в том, чтобы информировать пользователей о новых типах атак и быть настороже относительно любого поведения, которое кажется необычным.

Возвращение юности и воскрешение мертвых: как устроена технология дипфейк

В Интернете популярны ролики, в которых известным актерам приделывают чужие лица или тела. Это одно из самых зрелищных применений искусственного интеллекта так называемый дипфейк. Технология работает так круто, что открывает множество новых возможностей как для добрых, так и не очень дел.

Восемь лет назад много шума наделал видеоролик, в котором Одри Хепбёрн через два десятилетия после своей смерти рекламировала шоколад. Тогда, чтобы воссоздать образ актрисы, потребовались специальное оборудование и целая команда специалистов, лица, компьютерная графика и год работы. Непросто делалась и реклама виски с участием Брюса Ли.

Но все это в прошлом. То же самое сегодня может сделать один человек, и гораздо быстрее с помощью технологии дипфейк. О ней начали говорить в 2018 году. Николас Кейдж появился в фильмах, где не снимался. Затем сразила танцующая британская королева. В одном из роликов участник интеллектуальных игр Александр Друзь оказался во всех ролях сериала «Друзья». Поменять лицо теперь можно кому угодно. В американском штате Флорида в музее Дали с посетителями общается «живой» Сальвадор и даже делает селфи.

Технологию дипфейка (не чтобы обманывать, а в чисто научных целях) разрабатывали сразу несколько команд исследователей. Например, Университет Вашингтона запустил проект «Синтезируя Обаму», где в уста президента США вкладывали любые речи, а в Университете Стэнфорда переносили мимику актеров на известных людей.

Свои разработки есть и в России. Одной из них пользуется Сергей Логинов, его творения набирают миллионы лайков. Само название технологии образовалось из терминов deep learning (глубинное обучение) и fake (подделка). Как это работает? Нейросеть сначала обучается, анализирует десятки тысяч изображений нужного лица в разных ракурсах и с разными эмоциями, а затем создает так называемую цифровую маску, которая накладывается на дублера. Например, на лицо бизнесмена Илона Маска накладывается лицо актера Роберта Дауни младшего. Что важно чем дольше обучение нейросети, тем лучше результат.

Появляются сейчас и приложения, которые позволяют обычным пользователям создавать более простые подделки, а некоторые программы даже делают дипфейк в режиме реального времени. Программа адаптирует работу под конкретных перевоплощаемых, результат получается разной степени похожести. Это, конечно, открывает новые возможности в кино и рекламе. Британцы выпустили программу, которая меняет мимику актеров, чтобы она совпадала с дубляжом на разных языках, например на французском.

Дипфейк позволяет артистам торговать своим образом, не уставая на съемках и не старея. Недавняя российская реклама с Брюсом Уиллисом тому подтверждение. Технологию пытаются применять для воссоздания юных образов постаревших артистов. Используется этот прием и в рекламе: фейковые Жорж Милославский и Брюс Уиллис позволили роликам со своим участием стать вирусными. Впечатленные пользователи охотно делятся такими видео, а заодно распространяют рекламу.

Дипфейк проник и в психотерапию. Примером может служить фрагмент корейского документального фильма, где для матери как бы воскресили погибшую от рака дочь, чтобы облегчить боль утраты. Психиатры, правда, говорят, что такое может быть опасно.

Скарлетт Йоханссон, актриса: «Мне было 17 лет. В моей карьере был фильм такого жанра. Это был сомнительный способ заработка, это в прошлом. А на дипфейки я давно не обращаю внимания».

Это побочный эффект развития технологий, защиты от этого пока нет. С подделками, конечно, пытаются справляться. Есть уже специальные программы для проверки видео на предмет использования дипфейка. Тем не менее в Британии учительницу уволили после того, как распространил компрометирующий дипфейк с ее лицом, и доказать она ничего не смогла. А писательница из Шеффилда жаловалась на подделку в полицию, но закон в большинстве стран от таких преступлений не защищает.

В Китае введение в заблуждение дипфейками уже считается уголовным преступлением, если нет предупреждающей пометки. Мошенники, конечно, тоже осваивают перспективную технологию. Например, в Сети есть видео, где синтезированный Олег Тиньков предлагает бонус за инвестиции, а в ОАЭ преступники обманули сотрудников банка с помощью голосовой подделки и украли 35 миллионов долларов. Специалисты предупреждают: наши фото и видео в соцсетях тоже могут вооружить мошенников.

Эйнштейн вместо тренера: что такое дипфейк и почему это тренд в обучении

Британский рекламный холдинг WPP обучает сотрудников при помощи нейросети. 50 000 человек осваивают основы маркетинга по видеокурсам с виртуальным наставником, который ведёт лекции на трёх языках: английском, испанском и китайском. При этом к каждому сотруднику наставник обращается лично по имени.

Видеокурсы на основе дипфейк уже создают компании Великобритании

и США. Рассказываем, что это за технология и чем полезна для бизнеса.

Что такое дипфейк и как работает

Дипфейк — видео, созданное с помощью искусственного интеллекта. Если упрощённо, нейросеть по пикселям собирает ролик на основе готовых изображений. Например, изучает тысячи фотографий Дэвида Бекхэма и выпускает видео, на котором спортсмен призывает людей бороться с малярией.

Дипфейк с Дэвидом Бекхэмом. Футболист на пяти языках призывает подписать петицию против малярии

Другой вариант работы — искусственный интеллект накладывает одного персонажа на другого и получается комбо: Джим Керри в роли злодея из фильма «Сияние» или Бред Питт в образе терминатора.

Нейросеть показала, как выглядел бы Джим Керри в фильме «Сияние». Смотреть пример целиком

Бред Питт в роли терминатора — очередная фантазия дипфейка

От архитектуры до журналистики — где используют дипфейк

Дипфейк изобрел студент Стэнфордского университета Ян Гудфеллоу

в 2014 году для разработчиков искусственного интеллекта. Но технология быстро вышла за пределы узкого круга учёных. Сейчас её используют

в массовой культуре: от архитектуры до журналистики.

С помощью дипфейка GauGAN детские наброски можно превратить в реалистичный пейзаж

У созданного при помощи дипфейка блогера Лил Микела два миллиона подписчиков в «Инстаграм»

Приложение Faceapp покажет, как бы вы выглядели в старости или женском образе

В чём польза дипфейка для корпоративного обучения

68% сотрудников предпочитают учебные видеоролики статьям, инфографике, презентациям и книгам. Это подтверждает международное исследование компании Wyzowl. При работе над видео дипфейк даёт бизнесу ряд преимуществ.

Это позволяет международным компаниям сэкономить деньги на локализации контента, снять языковой барьер и учить сотрудников во всех странах по единым стандартам.

Учебный ролик от стартапа Synthesia. При помощи нейросети тренер читает лекцию на французском, китайском и португальском. Технология меняет не только озвучку, но и движение губ тренера

При помощи технологии дипфейк лекция больше похожа на разговор по душам — тренер обращается к сотруднику по имени и говорит лично с ним

Как получить видеокурс по технологии дипфейк

Есть два способа: заказать у студии или создать самому при помощи специальных программ.

Чтобы сделать видеокурс в Synthesia Create не нужна студия, камера и даже ведущий — только сценарий. Остальное нейросеть делает за вас.

В Synthesia Create вы собираете видеокурс, как конструктор: выбираете персонажа, фон, язык озвучки, добавляете текст и нажимаете «Опубликовать». Курс готов — виртуальный персонаж ведёт тренинг по вашему сценарию

Synthesia Create полностью на английском языке. Есть бесплатная демоверсия. Чтобы её получить, достаточно оставить заявку на сайте.

Видеокурсы на основе нейросети кроме британского WPP уже создают в Reuters, SAP, Accenture и Buzzfeed, пишет издание Wired. Материалы используют для адаптации новичков, обучению технике безопасности и стандартам работы.

Технология дипфейк пока осваивается за рубежом. А позже, возможно, приживётся в и России, как это получилось с виртуальной реальностью.

Быстрый конструктор курсов и тестов

Поможет создать интерактивные курсы и тесты в рекордно короткие сроки. Без дизайнера и программиста.

Редактор iSpring. Пишу статьи по eLearning, помогаю экспертам выпускать материалы для блога iSpring. Если у вас есть интересная тема по дистанционному обучению, напишите мне.

Дипфейки: что это за технология и почему она опасна

Слово deepfake появилось несколько лет назад. Оно объединяет в себе два понятия: глубокое обучение (deep learning), то есть обучение нейросетей, и подделку (fake). Технология дипфейков заключается в синтезе ИИ человеческих изображений: алгоритм объединяет несколько фото, на которых человек изображен с разным выражением лица, и делает из них видео. При этом ИИ анализирует большое количество снимков и учится тому, как может выглядеть и двигаться конкретный человек. Об этом пишет американское издание Forbes.

С распространением дипфейков появились случаи «дискредитации» публичных личностей, чьих изображений много в открытом доступе. Например, весной 2019 года в Сети было опубликовано дипфейк-видео со спикером палаты представителей конгресса США Нэнси Пелоси. Автор ролика с помощью ИИ изменил речь Пелоси так, что она плохо выговаривала слова, и пользователи, посмотревшие видео, посчитали, что политик пьяна. Ситуация вылилась в громкий скандал, и лишь спустя некоторое время было доказано, что речь Пелоси была сгенерирована ИИ.

Этот дипфейк был сделан достаточно просто. Но есть и сложные алгоритмы. Они не просто меняют тембр голоса или замедляют речь, а генерируют такие видео, на которых человек делает то, чего никогда не совершал, или говорит то, чего никогда не говорил. Со временем дипфейки будут становиться все более реалистичными, пишет американское издание Forbes. Уже сейчас технология претендует на то, чтобы влиять на политику, а в дальнейшем такие видео и вовсе смогут стать угрозой национальной безопасности.

Дипфейки: как трансформируется авторское право на контент

Массовый дипфейк: тренд на синтетический контент

Технологии дипфейков развиваются быстрее, чем технологии их обнаружения и законодательная база для регулирования их создания. ИИ скоро достигнет точки, когда будет практически невозможно отличить аудио и видео людей, говорящих то, что они никогда не говорили.

Дипфейк (из двух английских слов «deep learning — глубокое обучение» и «fake — подделка») — это синтетический контент, в котором человек в существующем фото, аудио или видео заменяется на другого. Дипфейки могут использовать любой формат — ваше фото, видео или ваш голос. Дипфейки наиболее часто используют в рекламе, порнофильмах, порномести, фейковых новостях и для финансового мошенничества.

Технология дипфейков — это не абсолютное зло, она может революционно изменить, например, киноиндустрию. С помощью нее можно искусственно омолодить или состарить актеров, придать дублерам большее сходство с актерами, синхронизировать движения губ при дубляже перевода или даже доснять фильм с изображением внезапно умершего или переставшего участвовать в съемках актера. Как правило, применение таких технологий юридически невозможно без согласия актеров, чьи изображения будут использованы в конечном материале, либо их наследников, если человек уже умер.

«В мире уже много проектов коммерческого использования дипфейков (Synthesia, WPP, Rosebud, Rephrase.ai, Canny AI). Технология дипфейков открывает возможность создавать полностью синтетические личности — изображения и голоса людей, которых никогда не существовало. Использование таких изображений практически полностью снимает зависимость бизнеса от моделей и актеров, в том числе от необходимости «очистки» авторских и смежных прав и подписания различных релизов», — считает Вадим Перевалов, старший юрист международной юридической фирмы Baker McKenzie.

Аудиофейки: есть ли авторское право на голос?

Голосовые дипфейки представляют собой самую большую проблему, потому что на голос человека не распространяется право собственности ни в одной стране мира — если только имя человека не зарегистрировано как коммерческий бренд.

Однако в 2020 году был создан прецедент. YouTube-канал Vocal Synthesis делает юмористические дипфейки с использованием голосов политиков и знаменитостей. Команда канала в юмористической манере разместила несколько сгенерированных записей начитки текстов американской рэп-звезды Jay-Z без коммерческой выгоды, четко обозначив все видео как синтез речи.

Тем не менее, концертная компания RocNation, которая принадлежит Jay-Z, подала иск о нарушении авторских прав. Организация выдвинула требование удалить видео, где, по их мнению, незаконно использован ИИ для имитации голоса музыканта.

Только два из четырех видео Jay-Z были удалены — было признано, что полученный в результате звуковой продукт является производной работой, не имеющей ничего общего ни с одной из песен рэпера. В США не каждый случай коммерческого использования чужого голоса является нарушением закона.

«Перспективное направление дипфейков — использование изображений или голосов знаменитостей для производства контента без их участия. Например, в России использование чужой речи для создания «похожего» голоса в явном виде не запрещено законодательством. Имитация голоса, например, телефонными пранкерами, тоже не является нарушением и, скорее, зависит от содержания шутки, которая может попасть под уголовную ответственность. А использование технологий дипфейка в рекламе не должно вводить потребителей в заблуждение — например, о том, что известная личность якобы рекомендует какой-либо товар. Помимо этого, остается дискуссионным вопрос, не нарушит ли создание такого «голосового слепка» авторские и смежные права на фонограммы и актерское исполнение», — поделился мнением Вадим Перевалов.

В марте 2019 года в Великобритании произошел инцидент с аудиофейком — ПО на основе искусственного интеллекта было использовано, чтобы сымитировать голос исполнительного директора британской энергетической компании и дать сотруднику этого предприятия поручение о переводе третьим лицам €220 тыс. Работник подумал, что разговаривает по телефону со своим боссом, и отправил деньги мошенникам. Следователи так и не установили подозреваемых.

Защита авторского права исходников дипфейков

Основная проблема в отношении дипфейков — еще ни в одной стране мира не создано законодательной практики, которая могла бы повлиять как на создателей дипфейков, так и на процедуру по их удалению. Закон об авторском праве может действовать как эффективное средство регулирования дипфейков, но для этого его надо доработать. Вопрос защиты прав умерших (например, киноактеров) в отношении использования их голоса и образа остается также открытым.

Вероятно, в российском законодательстве дипфейки стоит рассматривать через призму производного произведения, при котором использование исходного произведения без согласия его правообладателя будет незаконно.

«Исключительное право на результат интеллектуальной деятельности возникает изначально у автора (соавторов), а потом может быть передано автором другому лицу по договору (ст. 1228 ГК РФ). Российское законодательство также предусматривает, что для возникновения, осуществления и защиты авторских прав не требуется регистрации или соблюдения каких-либо формальностей. Это главный подход для современной международной системы охраны авторских прав, предусматривающей также возможность подтверждения авторства с помощью презумпции авторства (статья 15 Бернской конвенции об охране литературных и художественных произведений), » — утверждает Дмитрий Игнатенко, руководитель юридической службы компании Rubytech.

Если рассматривать право авторства на дипфейк как результат интеллектуальной деятельности, созданной программой, то по российскому законодательству автором может быть только гражданин, творческим трудом которого создан этот результат (ст. 1228 ГК РФ). А правообладателем может быть лишь человек или юридическое лицо, обладающие исключительным правом на результат интеллектуальной деятельности или на средство индивидуализации (ст. 1229 ГК РФ). Так что за любой машиной должно стоять физическое или юридическое лицо, в противном случае не будет создан объект авторского права.

Технологии совершенствования дипфейков развиваются быстрее, чем законы в этой области. Американские Twitter, Facebook и китайский TikTok попытались самостоятельно отрегулировать распространение дипфейков разными способами

Twitter ввел правила по дипфейкам и манипулированию СМИ, которые в основном предусматривают пометку твитов и предупреждение пользователей об измененных новостях, а не их удаление. По заявлению компании, твиты, содержащие фальсифицированные или недостоверные материалы, будут удаляться только в том случае, если они могут причинить вред. В определение вреда также включены любые угрозы конфиденциальности или праву человека или группы лиц свободно выражать свое мнение. Это означает, что политика распространяется на преследование, навязчивое внимание, подавление или запугивание избирателей, а также на контент, содержащий фразы, предназначенные для того, чтобы заставить кого-то замолчать.

Facebook в начале 2020 года анонсировал политику для удаления дипфейков. Сообщения будут удалены, если они соответствуют таким критериям:

TikTok. Новая политика TikTok запрещает любой синтетический или манипулирующий контент, который вводит пользователей в заблуждение, искажая правду о событиях, и который влечет причинение вреда. Политика не столько запрещает конкретную технологию, основанную на ИИ, сколько призвана в большей степени предупредить использование любого вида обманного видео для очернения политических оппонентов в интернете.

Основной проблемой для соцсетей являлось отсутствие технологии обнаружения дипфейков. В 2019 году Facebook вместе с Microsoft и другими партнерами запустили конкурс для решения проблемы обнаружения The Deepfake Detection Challenge. Самой успешной стала модель белорусского разработчика Селима Сефербекова. Она достигла точности 65,18% на тестовых дата-сетах. На третьем месте — модель российской компании NTechLab.

Технологические лидер ы — «Яндекс», TikTok, Microsoft, IBM, Kaspersky Lab, Reface, FaceApp, Ntechlab, и др. отказались комментировать РБК тренды дипфейков и авторского права.

Подписывайтесь также на Telegram-канал РБК Тренды и будьте в курсе актуальных тенденций и прогнозов о будущем технологий, эко-номики, образования и инноваций.