что такое внутренняя энтропия системы

Энтропия в термодинамике — это что такое? Описание, теория и примеры

Понятие об энтропии в термодинамике — это достаточно важный и в то же время непростой вопрос, поскольку существуют различные точки зрения для ее интерпретации. Опишем энтропию подробно в статье, а также приведем примеры процессов, где она играет ключевую роль.

Значение понятия

Разговор об энтропии логичнее всего начать с ее определения. Итак, энтропия в термодинамике — это экстенсивная физическая величина, которая отражает число возможных микросостояний описываемой макросистемы. Иными словами, энтропия отражает уровень организации: чем более неоднородной является система, тем меньше ее энтропия.

Важно понимать два основных свойства энтропии:

Что определяет энтропия?

Другими словами, для чего она была введена в физику? Чтобы ответить на этот вопрос, достаточно рассмотреть простой эксперимент: всем известно, что если взять холодный прут металла и привести его в контакт с таким же прутом, но нагретым до некоторой температуры, то с течением времени горячее тело будет охлаждаться, а холодное – нагреваться. Никто никогда не наблюдал обратный процесс. Направление протекания рассмотренного явления описывается с использованием концепции «энтропия».

Любая изолированная система, предоставленная самой себе, всегда стремится занять наиболее вероятное состояние. Это состояние характеризуется хаотичным и однородным распределением элементов, составляющих систему, и понимается как состояние с максимальным значением энтропии.

Статистическая интерпретация

В конце XIX — начале XX века австрийский физик Людвиг Больцман развил новое направление в физике, получившее название статистическая механика. В этой новой науке он ввел понятие об абсолютной энтропии, которую ученый представил в виде: S = k*ln(Ω), где k — константа Больцмана, Ω — количество возможных состояний в системе.

Отметим, что в физике абсолютное значение энтропии мало кого интересует, поскольку все математические формулы, которые учитывают рассматриваемую физическую величину, включают в себя именно ее изменение.

Обратимые процессы в термодинамике

Еще одно определение энтропии в термодинамике — это связь с энергией, которая никаким способом не может быть переведена в полезную работу, например, в механическую. Известно, что эта энергия существует в виде тепла в данной системе, но для практического использования она непригодна.

Например, двигатель внутреннего сгорания работает с некоторым КПД (многие люди, возможно, об этом никогда не задумывались, но коэффициент полезного действия двигателей, которые находятся внутри их автомобилей, составляет всего около 20-25 %), который никогда не будет равен 100 %, какими бы совершенными ни были технологии. Это происходит потому, что в результате термодинамического процесса сгорания топлива часть энергии (большая часть в рассматриваемом случае) теряется на разогрев деталей и на трение. Процесс сгорания топлива — яркий пример увеличения энтропии.

В середине XIX века немецкий ученый Рудольф Клаузиус, анализируя разные термодинамические процессы, ввел понятие «энтропия системы» и смог математически его выразить в виде следующего выражения: dS = δQ/T, здесь dS — изменение энтропии системы, δQ — изменение энергии, которое произошло в результате данного процесса, T — абсолютная температура. Отсюда получаем, что единицей измерения dS в СИ является Дж/К.

Приведенная формула энтропии в термодинамике справедлива только для обратимых процессов, то есть таких переходов, которые могут происходить как в прямом, так и обратном направлении, если изменить внешние условия. Например, если сжать газ, находящийся в герметичном цилиндре с помощью внешней силы, а затем прекратить действие этой силы, то газ восстановит свой первоначальный объем (состояние).

Таким образом, согласно уравнению Клаузиуса, изменение энтропии во время обратимого процесса равно отношению изменения энергии между начальным и конечным состояниями к абсолютной температуре.

Изотермический и адиабатический обратимые процессы

Изотермический процесс — это частный случай, который предполагает, что конечное и начальное состояния системы имеют одинаковую температуру. Согласно формуле Клаузиуса, в результате обратимого изотермического процесса изменение энтальпии системы будет точно равно количеству тепла, которым она обменялась с окружающей средой, деленному на температуру.

Примером такого процесса является расширение идеального газа за счет подвода к нему теплоты извне. Вся подводимая энергия в этом случае тратится на выполнение механической работы (расширение), а температура газа при этом остается постоянной.

Рассматривая концепцию энтропии, интересно также вспомнить об адиабатическом процессе, под которым понимают любой переход в изолированной системе, то есть в ней сохраняется внутренняя энергия. Если этот процесс является обратимым, то согласно формуле dS = δQ/T = 0, поскольку δQ = 0 (нет обмена теплом с окружающей средой).

Необратимые процессы

Рассмотренные примеры разных процессов могут только в грубом приближении считаться обратимыми, поскольку в них всегда существуют различные тепловые потери. В нашей Вселенной практически все процессы являются необратимыми. Для них сформулирован 2 закон термодинамики, и энтропия играет важную роль. Приведем формулу: dS≥δQ/T. О чем говорит это выражение: согласно второму закону термодинамики, энтропия в результате абсолютно любого необратимого процесса всегда увеличивается (см. знак «>» в выражении).

Таким образом, подобно факту, что энергия не может быть создана из ничего и не может исчезать бесследно, второй закон термодинамики свидетельствует, что энтропия может быть создана, но не может быть уничтожена (постоянно увеличивается).

Историческая справка

Как было выше сказано, об энтропии физики стали задумываться только в середине XIX века. Причиной этому послужил тот факт, что первые паровые машины обладали чрезвычайно низким КПД (в начале XVIII века типичным значением КПД для этих машин было 2 %). То есть энтропия изначально понималась как «распыление» тепловой энергии во время термодинамического процесса.

Само слово «энтропия», введенное Клаузиусом, с древнегреческого языка означает «эволюция, преобразование», тем самым подчеркивается ее важность для описания протекающих процессов.

Согласно 2-му началу термодинамики, энтропия в нашей Вселенной постоянно увеличивается. Это означает, что в конце концов она достигнет своего максимального значения, когда вещество однородно распределится и температура выровняется во всем пространстве. Такая гипотеза была выдвинута тем же Клаузиусом и получила название тепловой смерти Вселенной.

Реализуется ли она в действительности, зависит от области применимости термодинамики. Дело в том, что на микроуровне, когда рассматриваются отдельные молекулы и атомы, энтропия в термодинамике — это бессмысленная величина, так как сами законы этой ветви физики перестают работать. Предполагается, что аналогичные ограничения их применимости существуют, когда масштабы системы достигают бесконечных значений, то есть размеров Вселенной.

Введение в понятие энтропии и ее многоликость

Как может показаться, анализ сигналов и данных — тема достаточно хорошо изученная и уже сотни раз проговоренная. Но есть в ней и некоторые провалы. В последние годы словом «энтропия» бросаются все кому не лень, толком и не понимая, о чем говорят. Хаос — да, беспорядок — да, в термодинамике используется — вроде тоже да, применительно к сигналам — и тут да. Хочется хотя бы немного прояснить этот момент и дать направление тем, кто захочет узнать чуть больше об энтропии. Поговорим об энтропийном анализе данных.

В русскоязычных источниках очень мало литературы на этот счет. А цельное представление вообще получить практически нереально. Благо, моим научным руководителем оказался как раз знаток энтропийного анализа и автор свеженькой монографии [1], где все расписано «от и до». Счастью предела не было, и я решила попробовать донести мысли на этот счет до более широкой аудитории, так что пару выдержек возьму из монографии и дополню своими исследованиями. Может, кому и пригодится.

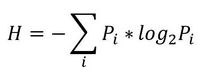

Итак, начнем с начала. Шенноном в 1963 г. было предложено понятие меры усредненной информативности испытания (непредсказуемости его исходов), которая учитывает вероятность отдельных исходов (до него был еще Хартли, но это опустим). Если энтропию измерять в битах, и взять основание 2, то получим формулу для энтропии Шеннона

То есть в этом случае энтропия напрямую связана с «неожиданностью» возникновения события. А отсюда вытекает и его информативность — чем событие более предсказуемо, тем оно менее информативно. Значит и его энтропия будет ниже. Хотя открытым остается вопрос о соотношениях между свойствами информации, свойствами энтропии и свойствами различных ее оценок. Как раз с оценками мы и имеем дело в большинстве случаев. Все, что поддается исследованию — это информативность различных индексов энтропии относительно контролируемых изменений свойств процессов, т.е. по существу, их полезность для решения конкретных прикладных задач.

Энтропия сигнала, описываемого некоторым образом (т.е. детерминированного) стремится к нулю. Для случайных процессов энтропия возрастает тем больше, чем выше уровень «непредсказуемости». Возможно, именно из такой связки трактовок энтропии вероятность->непредсказуемость->информативность и вытекает понятие «хаотичности», хотя оно достаточно неконкретно и расплывчато (что не мешает его популярности). Встречается еще отождествление энтропии и сложности процесса. Но это снова не одно и то же.

Для того, чтобы немного обрисовать области применения энтропии к анализу данных, рассмотрим небольшую прикладную задачку из монографии [1] (которой нет в цифровом виде, и скорей всего не будет).

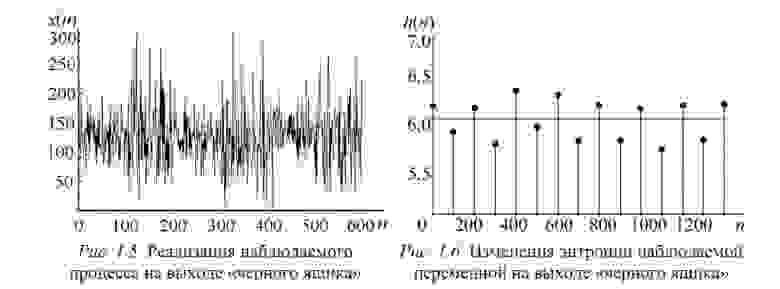

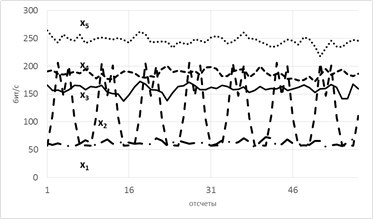

Пусть есть система, которая каждые 100 тактов переключается между несколькими состояниями и порождает сигнал x (рисунок 1.5), характеристики которого изменяются при переходе. Но какие — нам не известно.

Разбив x на реализации по 100 отсчетов можно построить эмпирическую плотность распределения и по ней вычислить значение энтропии Шеннона. Получим значения, «разнесенные» по уровням (рисунок 1.6).

Как можно видеть, переходы между состояниями явно наблюдаются. Но что делать в случае, если время переходов нам не известно? Как оказалось, вычисление скользящим окном может помочь и энтропия так же «разносится» на уровни.В реальном исследовании мы использовали такой эффект для анализа ЭЭГ сигнала (разноцветные картинки про него будут дальше).

Теперь еще про одно занятное свойство энтропии — она позволяет оценить степень связности нескольких процессов. При наличии у них одинаковых источников мы говорим, что процессы связаны (например, если землетрясение фиксируют в разных точках Земли, то основная составляющая сигнала на датчиках общая). В таких случаях обычно применяют корреляционный анализ, однако он хорошо работает только для выявления линейных связей. В случае же нелинейных (порожденных временными задержками, например) предлагаем пользоваться энтропией.

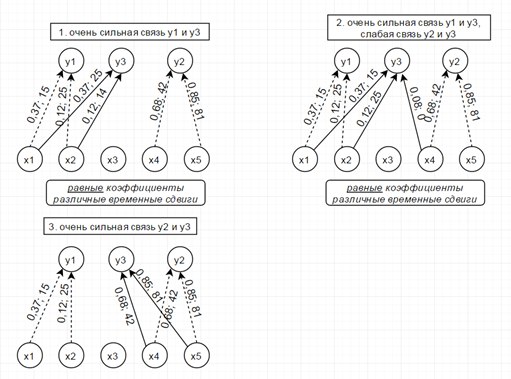

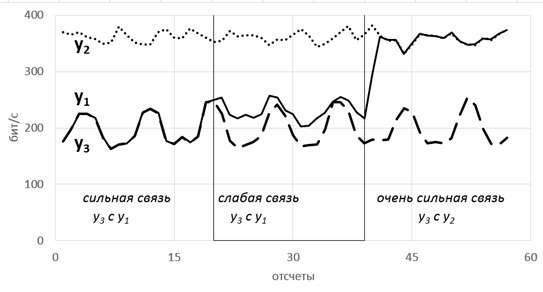

Рассмотрим модель из 5ти скрытых переменных(их энтропия показана на рисунке ниже слева) и 3х наблюдаемых, которые генерируются как линейная сумма скрытых, взятых с временными сдвигами по схеме, показанной ниже справа. Числа-это коэффициенты и временные сдвиги (в отсчетах).

Так вот, фишка в том, что энтропия связных процессов сближается при усилении их связи. Черт побери, как это красиво-то!

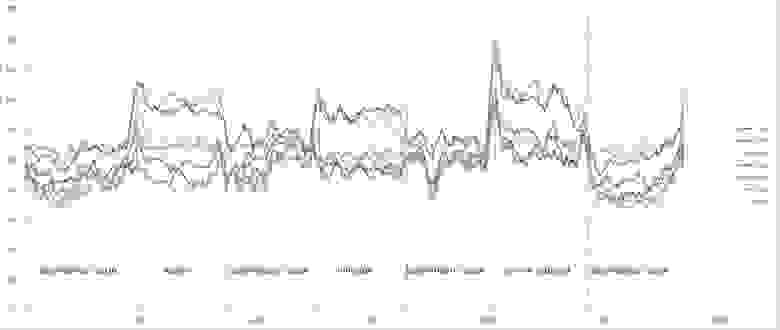

Такие радости позволяют вытащить практически из любых самых странных и хаотичных сигналов (особенно полезно в экономике и аналитике) дополнительные сведения. Мы их вытаскивали из электроэнцефалограммы, считая модную нынче Sample Entropy и вот какие картинки получили.

Можно видеть, что скачки энтропии соответствуют смене этапов эксперимента. На эту тему есть пара статей и уже защищена магистерская, так что если кому будут интересны подробности — с радостью поделюсь. А так по миру по энтропии ЭЭГ ищут уже давно разные вещи — стадии наркоза, сна, болезни Альцгеймера и Паркинсона, эффективность лечения от эпилепсии считают и тд. Но повторюсь-зачастую расчеты ведутся без учета поправочных коэффициентов и это грустно, так как воспроизводимость исследований под большим вопросом (что критично для науки, так то).

Резюмируя, остановлюсь на универсальности энтропийного аппарата и его действительной эффективности, если подходить ко всему с учетом подводных камней. Надеюсь, что после прочтения у вас зародится зерно уважения к великой и могучей силе Энтропии.

Разбираемся, что такое энтропия

Если говорить о широком смысле данного слова, то Энтропия означает меру хаоса в какой-то системе. Если перевести это слово с греческого языка, то оно означает превращение или преобразование. В физике, биологии, информатике и химии данный термин определяет неупорядоченность системы и её неопределенность.

Термин выражает именно степень этой хаотичности. Что же касается такой науки, как философия, то в этом контексте термин определяется как потеря внутренней гибкости системы или предрасположение к этому. Так, система может перейти на низшие степени своего развития, и может подвергнуться распаду.

История термина

На протяжении всей истории человечества, люди пытались как можно больше работы механизировать. Для выполнения этой работы создавались различные машины и приспособления. Еще в XVI веке были первые упоминания о разработке вечного двигателя. И с тех пор было много попыток его создать.

После многих таких попыток, которые были неудачны, ученые начали понимать некоторые природные особенности, которые в последующем и привели к созданию термодинамики.

Чтобы термодинамическая система могла выполнять работу, на неё возложенную, ей необходимо пользоваться ресурсами. Это могут быть как внутренние, так и внешние ресурсы, которые будут поставлять системе необходимую энергию.

Данное явление – это закон сохранения электроэнергии, существующий в термодинамике. Именно этот закон и запрещает разработку вечного двигателя, как и его существование. Это обусловлено тем, что вечный двигатель должен работать без энергетических затрат, а человечеству пока не известны такие тела либо же системы.

Позже был открыт вечный двигатель, так называемый второстепенный механизм. Он не перечил термодинамическому закону, но основывался на том, что тепло от одного тела передается другим телам. Как пример, брали океан, при охлаждении которого можно получить очень большой запас тепла.

Ученый Клаузиус в 1865 году разработал второе начало термодинамики. Суть его заключается в том, что процесс, который повторяется, не может существовать в том случае, если тело передает тепло другому телу и только.

Немного позднее ним было введено понятие энтропии. Энтропией считалась функция, которая изменялась по мере количества переданного тепла к температуре. После этого был открыт еще один закон, который гласил, что энтропия не уменьшается в замкнутой системе.

Просто о сложном

Энтропия – это понятие, которое используется не в одной области человеческой деятельности, поэтому определения её может быть несколько размытым. Данный термин отображает величину, и суть её можно разобрать на простых примерах. Энтропия – это степень беспорядка, степень неопределенности и неупорядоченности.

Энтропию высокой степени можно представить наглядно как улицу с разбросанными клочьями бумаги. Если бумаги сложены аккуратно в стопку, то система упорядочена, и энтропия при этом имеет низкую степень. Показатели энтропии необходимо понижать, и для этого следует затратить немало времени, склеить бумаги по кусочкам и собрать их в стопку.

Если имеет место энтропия закрытой системы, то здесь также все просто. Закрытую систему можно представить себе как закрытый шкаф, если вещи в нем разбросаны, то воздействовать на них извне не получиться, и хаос в шкафу будет присутствовать длительное время.

Со временем вещи разложатся, и это приведет к порядку, но вещам необходимо долго разлагаться, к примеру, для шерстяного носка понадобиться 5 лет, а для кожаной обуви – около 40 лет. В приведенном примере шкаф выступает в качестве изолированной системы, а разложение вещей в нем – это наведение порядка в структурах.

Минимальной является энтропия, которая касается макроскопических объектов, их можно наблюдать невооруженным глазом. Что же касается более высоких показателей, то зачастую их имеет вакуум.

Термодинамическая энтропия

Начнем с фундаментальной асимметрии, которая касается движений, происходящих благодаря движению энергии тепла. Каждый раз тепло передвигается от горячего к холодному, и направление это не изменяется.

Если соединяют, к примеру, вместе два бруска дерева, имеющих различную температуру, то между ними происходит течение энергии. Энергия от горячего бруса перейдет на брусок, который имеет температуру с низким показателем.

Так прослеживается асимметрия распределения тепла, почему так происходит? Для того чтобы объяснить данный факт научные работники разработали концепцию, которая называется энтропией. Показатели её должны иметь положительные результаты, если обмен тепла происходит в природных процессах, в ином случае его просто не может быть.

Если не брать во внимание теоретическое начало энтропии, её использование далее было успешным. Её применили для того, чтобы проанализировать работу двигателей. Тепло используется для того, чтобы генерировать работу. Энтропия регулирует работу такого двигателя.

Рассмотрим строение теплового двигателя. Он состоит их горячего резервуара, холодного резервуара, а также из рабочего тела. Рабочим телом, как правило, является газ или пар. Тепло перемещается из одного резервуара в другой, вследствие этого двигатель и работает, благодаря своей особой конструкции.

Энтропия в экономике

Прежде, чем начать рассматривать энтропию экономического характера, важно очертить границы применения данной концепции. Такие меры помогут понять идею. В процессах, которые предусматривают поток валюты, передвижение денег средств происходит только в одну сторону, к производителям от потребителей.

Поставщики и производители товаров всегда реализуют их по завышенным ценам, больше, чем реальная стоимость услуги. Этот процесс выражает асимметрический поток денежной массы, при котором можно проследить экономическую энтропию. Как же при этом необходимо использовать капитал, чтобы из него можно было извлечь максимальную прибыль.

Приведем такой пример, существует два тела, одно из них имеет повышенную температуру, а второе – низкую. Также есть тело, которое периодически переходит от одного тела к другому. Это тело изменяет энтропию системы в экономике, которая является замкнутой. Чтобы этот процесс имел место, показатели энтропии должны быть при этом положительными.

Но что же произойдет, когда двигатель будет помещен так, что экономическое тепло производило бы определенную работу? Предположим, что двигатель в экономике – это фирма. Тепло от работы двигателя – это доходы этой компании. В свою очередь, поставленное тепло холодному телу – это затраты на услуги, закупаемую продукцию и на само производство.

Предположим, что горячее тело – это потребительский спрос, а холодное тело — это производители. Что касается температуры экономики, то в данном случае она обозначает рыночную цену единицы услуги или товара. В свою очередь, температура экономического характера рынка производителей — это стоимость изготовления единицы товара.

С помощью экономической энтропии можно измерить неэффективность рынка. Её еще используют для того, чтобы определять то, насколько компания неэффективна или потерю капитала вместе с материальными и человеческими ресурсами. Двигатель в экономике, который идеально работает или компания, имеющая равновесие в стоимости, получает прибыль и провоцирует энтропию.

Таким образом, можно увидеть, что понятие энтропии действительно достаточно широкое. Оно может отображать как процессы в термодинамике, так и процессы в экономической деятельности. Это понятие выражает степень хаоса в системе.

Энтропия – что это такое простыми словами

Понятие “Энтропия” (ударение на последнем слоге) впервые появилось в термодинамике. Там оно обозначает степень рассеивания энергии в замкнутой системе. В общем смысле под энтропией понимают степень развития хаоса или разрушения первоначально установленного порядка в замкнутой системе.

Энтропия в закрытой системе, как её понимают физики

Пример из жизни: Возьмём некую замкнутую систему. Допустим, Ребенок + Кожаный мяч в комнате. Ребенок произвольно пользуется мячом – играет, ударяет об пол, подбрасывает к потолку… Через 6 месяцев активного использования мяч заметно сдулся, играть им стало труднее.

Замкнутая система открывается: приходит папа с насосом и накачивает мяч. Функции мяча, подвергнутого энтропии, восстанавливаются.

2 закон термодинамики гласит, что энтропия в замкнутой системе не может уменьшаться, она только увеличивается. Даже если замкнутая система с мячом не предполагает активного разрушающего фактора (играющий ребёнок), энтропия всё равно будет, хоть и с меньшими показателями.

Пример 2. Мяч 6 месяцев пролежал в комнате: сдулся незначительно, но сильно покрылся пылью и немного выцвел со стороны, обращенной к окну. Чтобы энтропия уменьшилась в закрытой системе, надо ее открыть и добавить в неё ресурс из другой системы.

Чтобы мяч восстановить в прежних размерах, нужно внести в замкнутую систему изменения с помощью папиной энергии и нового воздуха, закачанного насосом в мяч. Чтобы мяч, пролежавший в комнате, вернул первоначальные свойства, мама должна вытереть его мокрой тряпкой от пыли, а сестра – покрыть новой краской.

Понятием энтропии пользуются многие сферы человеческих знаний и деятельности:

Энтропия в биосистемах

Все биосистемы (живые системы) являются открытыми, а не закрытыми, поэтому понятие энтропии в биосистеме несколько отличается от энтропии неживых объектов, рассматриваемых физиками.

Биосистемы находятся в состоянии динамического равновесия. Оно существует по другим законам, нежели термодинамическое равновесие.

Системы любого живого организма открыты для взаимодействия друг с другом в рамках самого организма, а сам организм в свою очередь открыт для взаимодействия с окружающей средой местности планеты.

Планета, как живой организм, в свою очередь, подвержена влиянию и взаимодействию с одной стороны – с живыми организмами, её населяющими, а с другой – с космическими объектами и явлениями.

Все это создаёт разветвлённую систему корректировок, чтобы поддерживать между всеми и во всех живых организмах гомеостаз – то есть баланс. Явление энтропии (разрушения и разбалансировки) является самым сложным в больших живых системах. Ведь они используют увеличивающуюся энтропию одних своих частей в качестве пищи и строительного материала для уменьшения энтропии в других своих частях.

Энтропия в теории информации и коммуникаций

Над данной темой в этой сфере работал Клод Шеннон. Он изучал рациональные способы передачи информации через зашумлённый канал. По Шеннону, энтропия – это мера непредсказуемости какого-либо опыта, события, испытания. Это количество информации на 1 сообщение источника, выдающего независимые сообщения.

Он рассматривал информационную энтропию в своей «Математической теории Коммуникации», где ввёл связанное понятие «вероятность». По Шеннону, чем меньше вероятность какого-либо события, тем больше информации оно содержит.

Энтропия в социуме

Это степень отклонения социальной системы, организации (предприятия) и т.д. от принятой нормы (эталона) и установленных целей. На социальную энтропию влияют:

Обобщая до бытового уровня, можно сказать, что “Энтропия” – это мера или степень беспорядка (хаоса) или неопределённости. Существуют 3 понятия, противоположные энтропии:

Но эти термины действуют только для живых систем. Негэнтропия в живой системе – это энтропия, которую живая система экспортирует, чтобы снизить свою собственную энтропию.

Другими словами, синтропия – это свободная или освободившаяся энергия одного организма или группы организмов, отправляемая на упорядочивание и уравновешивание другого организма в системе.

Жизнь потребляет то, что меньше упорядочено (убитый организм, ставший пищей) и превращает это в то, что более упорядочено (живые клетки, ткани, органы, системы, целые организмы). Поэтому считается что жизнь сама по себе имеет свойство отрицательной энтропии.

Энтропия – что это такое простыми словами?

Энтропия – это один из весьма распространённых терминов, который используется для объяснения большого количества физических, химических и даже социальных явлений. Для того чтобы правильно его понимать, необходимо знать все особенности того, в каком контексте это определение может использоваться.

История появления термина

Впервые термин «энтропия» был использован в 1865 году Рудольфом Клаузиусом. Этим значением специалист описывал способность тепловой энергии преобразуется в механическую.

Длительное время понятие энтропии использовалось только лишь в термодинамике. Со временем оно было заимствовано другими областями науки и теориями. Именно поэтому в настоящее время существует большое количество определений данного термина.

Понятие «энтропия» произошло от древнегреческого слова «τροπή», что в переводе на русский означает «поворот» или же «превращение». На сегодняшний момент данный термин преимущественно используется в термодинамике, экономике, физической статистике, теории информации и социологии.

Энтропия в термодинамике

Главный постулат термодинамики гласит о том, что любая изолированная система со временем приходит в состояние равновесия и не может из него выйти без воздействия внешних факторов. Этот процесс отличается беспорядком.

Энтропия в свою очередь – это мера данного беспорядка, которую можно вычислить. Для этого следует всем состояниям приписать число способов того, как их можно реализовать. Чем больше данное значение, тем больше энтропия конкретной системы.

Таким образом, если структура или само вещество является организованным, то его неопределенность, которую часто называют хаотичностью, ниже.

Для определения абсолютного числа энтропии необходимо вычислить количество изменений у конкретной системы во время осуществления ею теплопередачи при заданных температурных показателях.

Для определения абсолютного числа энтропии необходимо разделить уровень теплоотдачи на абсолютную температуру, при которой происходит данный процесс. Чем больше количество теплоты, тем более значительным будет показатель абсолютного числа энтропии.

Энтропия в экономике

В экономической теории часто применяется такой термин, как коэффициент энтропии. Он используется для определения изменчивости концентрации рынка. Чем выше значение коэффициента энтропии, тем значительнее экономическая неопределенность. В таких условиях существенно снижается уровень образования монополии.

Коэффициент энтропии в экономике частично помогает оценить выгоды, которые может получить компания в ходе возможного обретения монопольного положения или же вследствие модификации концентрации рынка.

Энтропия в статистике и теории информации

Под энтропии специалисты, собирающие статистику, подразумевают меру непредсказуемости или же неопределенности определенной системы, которую они исследуют. Такая величина позволяет вычислить степень беспорядочности осуществляемого эксперимента или проходимого события.

Чем больше состояний анализируемой система, тем больше значение неопределенности. Все процессы, направленные на появление структуры, приводят к возникновению информационной предсказуемости. Она отличается такими своими особенностями, как:

Также в статистике применяется такой термин, как абсолютная энтропия языка. Он характеризует наибольшее количество данных, которые можно передать единицей этого языка. Это касается прежде всего символа или буквы, что в данном случае при определении играют роль бита.

Энтропия в социологии

Под энтропией в социологии принято понимать информационную неопределенность. Она является одной из характеристик отклонения социума, что воспринимается, как единая система, от определенного состояния, которое считается эталоном. Такой анализ также проводится по отношению к различным звеньям групп людей.

Проявляется характеристика отклонения в снижении эффективности развития или функционирования анализируемой системы, что в свою очередь ведет к ухудшению ее самоорганизации.

Примером высокой энтропии является чрезмерная загруженность офисных работников, который постоянно необходимо сдавать отчеты о своей деятельности, вследствие чего они не могут выполнять другие свои прямые обязанности по работе.

В данном примере информационная неопределенность является мерой нецелесообразного использования руководством компании своих трудовых ресурсов.

Что такое Энтропия?

Философская Энциклопедия. В 5-х т. — М.: Советская энциклопедия. ЭНТРОПИЯ — (от греч. entropia поворот, превращение), понятие, впервые введённое в термодинамике для определения меры необратимого рассеяния энергии. Э. широко применяется и в др. областях науки: в статистической физике как мера вероятности осуществления к.… … Физическая энциклопедия

Русский язык, как и любой другой, постоянно изменяется под прессом постоянного технологического заимствования и сотрудничества с другими государствами. Благодаря этому, наш язык богат на различные иноязычные заимствования.

Одним из относительно новых слов в русском языке стало слово «энтропия», которое встречалось многим из нас, но далеко не каждый понимает, что же оно на самом деле значит.

Данная статья призвана помочь вам разобраться, что же такое энтропия, откуда она «есть-пошла» и в каких сферах жизни используется.

В нашей жизни Энтропия — величина, которая характеризует степень неупорядоченности, а также тепловое состояние Вселенной. Греки определили это понятие как превращение или переворот. Но в астрономии и физике его значение несколько отличное. Говоря простым языком, энтропия — это мера хаоса.

И физики, и лирики оперируют понятием «энтропия». В переводе с древнегреческого языка на русский слово «энтропия» связывают с поворотом, превращением.

Представители точных наук (математики и физики) ввели данный термин в научный обиход и распространили его на информатику, химию. Р. Клаузиус, и Л. Больцман, Э. Джейнс и К. Шеннон, К. Юнг и М.

Планк определяли и исследовали названное выше явление. Перед тем, как дать определение энтропии, нужно отметить, что это понятие исходит из законов термодинамики. 1-й закон термодинамики: это закон сбережения энергии, то есть общее количество массы-энергии во вселенной постоянно, оно не увеличивается и не уменьшается со временем. Наша вселенная – это закрытая система, в которой действует этот закон, ничто извне не поступает и ничто не убывает.

Энтропия изолированной системы не может уменьшаться. Героиня фильма Вуди Аллена Whatever Works дает такое определение энтропии: это из-за чего тяжело засунуть обратно в тюбик зубную пасту. Она еще интересно объясняет принцип неопределенности Гейзенберга, еще один повод посмотреть фильм.

Энтропия – состояние, но не физическое свойство, подобное давлению, температуре или массе. Никакими датчиками невозможно обнаружить энтропию. Это состояние можно лишь просчитать, используя свойства веществ, поддающиеся измерению. Полученные таким способом значения энтропии могут использоваться в других расчетах.

Например, связанных с производством пара или электроэнергии, добываемых посредством турбин и машин возвратно-поступательного движения.

Энтропия это, в широком смысле, мера хаоса в какой-либо системе. В переводе с греческого «энтропия» означает «преобразование, превращение». Ударение в слове «энтропия» ставится на букву «и».

Изначально термин «энтропия» использовался в термодинамике для измерения количества способов, которыми какая-либо термодинамическая система может быть упорядочена.

Сегодня этот термин употребляется в самом широком спектре контекстов: от музыки до политики. Чем выше энтропия, тем более хаотичной выглядит система.

Энтропия Entropy). Закон термодинамики, согласно которому любая энергетическая система стремится к состоянию равновесия. В теории психоанализа энтропия означает, что всем живым организмам присуще обязательное стремление вернуться в неживое состояние, из которого они изначально произошли.

Если говорить о широком смысле данного слова, то Энтропия означает меру хаоса в какой-то системе. Если перевести это слово с греческого языка, то оно означает превращение или преобразование.

В физике, биологии, информатике и химии данный термин определяет неупорядоченность системы и её неопределенность. Термин выражает именно степень этой хаотичности.

Что же касается такой науки, как философия, то в этом контексте термин определяется как потеря внутренней гибкости системы или предрасположение к этому. Так, система может перейти на низшие степени своего развития, и может подвергнуться распаду.

Важнейшим параметром состояния вещества является энтропия (S). Изменение энтропии в обратимом термодинамическом процессе определяется уравнением, являющимся аналитическим выражением второго закона термодинамики: для 1 кг вещества — d s = d q / Т, где d q — бесконечно малое количество теплоты, подводимой или отводимой в элементарном процессе при температуре Т, кДж / кг.

Что такое энтропия? Этим словом можно охарактеризовать и объяснить почти все процессы в жизни человека (физические и химические процессы, а также социальные явления).

Но не все люди понимают значение этого термина и уж тем более не все могут объяснить, что это слово значит. Теория сложна для восприятия, но если добавить в неё простые и понятные примеры из жизни, то разобраться с определением этого многогранного термина будет легче.

Энтропия: что это такое простыми словами

Русский язык, как и любой другой, постоянно изменяется под прессом постоянного технологического заимствования и сотрудничества с другими государствами. Благодаря этому, наш язык богат на различные иноязычные заимствования.

Одним из относительно новых слов в русском языке стало слово «энтропия», которое встречалось многим из нас, но далеко не каждый понимает, что же оно на самом деле значит.

Данная статья призвана помочь вам разобраться, что же такое энтропия, откуда она «есть-пошла» и в каких сферах жизни используется.

Что такое энтропия простыми словами

Чаще всего слово «энтропия» встречается, конечно же, в классической физике. Это одно из самых сложных понятий данной науки, поэтому даже студенты физических вузов нередко сталкиваются с проблемами при восприятии данного термина.

Это, безусловно, физический показатель, однако важно понять один факт – энтропия не похожа на привычные нам понятия объема, массы или давления, потому что энтропия является именно свойством определенной рассматриваемой нами материи.

Говоря простым языком, энтропия – показатель того, насколько много информации об определенном предмете нам неизвестно. Ну, например, на вопрос, где я живу, я отвечу вам – в Москве.

Это вполне конкретная координата – столица Российской Федерации – однако, Москва город немаленький, поэтому вам всё еще остается неизвестной точная информация о моем местоположении. А вот когда я назову вам свой, например, почтовый индекс, то энтропия обо мне, как предмете, понизится.

Это не совсем точная аналогия, поэтому для уточнения приведем ещё один пример. Допустим, мы с вами возьмем десять игральных шестигранных кубиков. Бросим их все по очереди, а затем я сообщу вам сумму выпавших показателей – тридцать.

Исходя из суммы всех результатов, вы не сможете точно сказать, какая цифра и на каком кубике выпала – вам банально не хватает для этого данных. В нашем случае каждая выпавшая цифра на языке физиков будет называться микросостоянием, а сумма, равная тридцати, на всё том же физическом наречии будет именоваться макросостоянием.

Если мы посчитаем, сколько возможных микросостояний могут нам в сумме дать три десятка, то придем к выводу, что их количество достигает почти трёх миллионов значений. Используя специальную формулу, мы можем посчитать и показатель энтропии в данном вероятностном эксперименте – шесть с половиной.

Откуда взялась половина, возможно, спросите вы? Эта дробная часть появляется из-за того, что при нумерации в седьмом порядке мы можем оперировать лишь тремя числами – 0, 1 и 2.

Современное слово «энтропия» имеет греческие корни, поэтому из-за перевода её нередко называют «мерой хаоса». Допустим, вы решили устроить у себя в квартире застолье по поводу дня рождения маленькой дочери.

Убрали всю квартиру, перемыли полы и окна, вымыли дочиста посуду, а затем красиво и элегантно разложили всю посуду на столе. Изначальный бытовой хаос вашей квартиры значительно уменьшился, следовательно, ваш дом стал системой с маленькой энтропией.

Энтропия во Вселенной

Хаосом пронизан весь космос, вся наша природа, вплоть до атомов и элементарных частиц. Всё находится в постоянном движении и взаимодействии, словно прекрасно сработанный механизм. А управляют всеми этими процессами законы, которые мы, жалкие людишки, можем выразить не менее прекрасным математическим языком.

Но как же при таком уровне энтропии (то есть, хаоса) во Вселенной вообще могло что-либо возникнуть? Ответ на этот вопрос крайне прост. Вся материя передает уровень своей энтропии своему же окружению, всему, до чего могут дотянуться.

Например, для регуляции уровня энтропии на Земле – звезда по имени Солнце постоянно снабжает нас энергией, которую производит за счет непрекращающейся термоядерной реакции на ее поверхности.

Если бы наша планета была замкнутой системой, то, согласно второму закону термодинамики, энтропия внутри неё могла бы лишь увеличиваться, но, как вы уже поняли, Солнце позволяет нам держать уровень энтропии Земли в норме.

Энтропией и хаосом пропитано всё, что нас окружает и даже то, что находится внутри нас. В газах и жидкостях энтропия играет ключевые роли, даже наши сиюминутные желания и порывы на самом деле являются ничем иным, как порождением всеобщего вселенского хаоса.

Не сложно прийти в очередной раз к красивейшему выводу: Вселенная, сколько огромна бы она ни была, представляет собой совокупность бесконечного количества частичек самой разнообразной величины и не менее разнообразных свойств.

Всё в ней от элементарного бозона до Альфа Центавры и целых галактик связано незаметными нитями. Подобные открытия физиков поражают не только своей сложностью, но и красотой.

Казалось бы, обычные математические и физические формулы на досках небритых задумчивых мужчин в очках являются ключевыми факторами для нашего познания самих и себя и нашего места в огромной Вселенной.

Надеемся, что данная статья помогла вам прояснить, чем же на самом деле является энтропия, в каких случаях данное слово используется, а также к чему открытие данного показателя привело ученых и философов.

Кто знает, быть может прочтение этой статьи вдохновит вас на целенаправленное изучение этой прекрасной науки – физики. Так или иначе, интересоваться наукой современному человеку просто жизненно необходимо, хотя бы для собственного развития.