что такое видео парсер

Простой парсер для youtube в гугл таблицах

Предыстория

Появилась задача собрать данные по 2000+ youtube видео, из которых необходимо было извлечь название видео, канала и язык.

Функция IMPORTXML, с помощью которой можно выполнять парсинг с сайтов, — не помогла, поскольку, как оказалось в дальнейшем, youtube хранит данные в JSON файлах. Перебирать руками такое количество видео не хотелось и я начал искать способы как автоматизировать или хотя бы упростить эту задачу.

Нашел старую статью 15 года на Хабре, в которой описано как получить количество просмотров видео, но с момента ее публикации youtube обновил API и мне необходимо было получить немного другие данные.

В процессе решения задачи с помощью youtube API и гугл таблиц получилось не только извлечь данные по заранее подготовленному списку видео URL, но также парсить выдачу youtube по ключевому слову.

Находясь в дичайшем восторге от результата, я решил поделиться своим опытом и описать процесс немного подробнее.

Сам метод конечно же не идеален. Его можно охарактеризовать как простое решение на очень скорую руку. Но пока не начал изучать Python (надеюсь этот день рано или поздно настанет) приходится все делать по старинке в таблицах.

Подготовка

Для работы парсера, как и в оригинальной статье, нам понадобится скрипт ImportJSON и youtube API.

ImportJSON

Скачиваем скрипт с github и устанавливаем в таблицу через инструменты >> редактор скриптов.

Youtube API

Получаем свой API — ключ Youtube Data API V3 в библиотеке и создаем под него учетные данные. Предварительно, конечно же, делаем учетную запись, если еще не зарегистрированы в google cloud.

Информация о видео хранится в JSON файле, который доступен по ссылке:

где

Video_ID — идентификатор видео

API_Key — ключ API который вы получите в консоли

Part_Parametr — часть файла в которой хранится информация

Части файла могут быть нескольких видов:

snippet — содержится практически вся базовая информация о видео:

1. дата публикации

2. название видео

3. название канала

4. идентификатор канала

5. описание под видео (Description)

6. категория видео (номер)

7. теги

contentDetails — содержит продолжительность и разрешение видео.

topicDetails — содержит категорию видео в виде ссылки на википедию с названием категории, однако этот раздел не всегда бывает заполнен.

statistics

1. просмотры

2. количество комментариев

3. лайки

4. дизлайки

В целом это основные части, которые могут вам понадобиться, но полный список, если что, есть в справке.

Получение данных по списку URL

Рассмотрим работу парсера на примере обзора badcomedian. Для того чтобы получить информацию о видео нам нужен только его идентификатор (Video_ID), в данном случае это EOWa0fmSGs8.

Получаем и структурируем информацию при помощи формулы ImportJSON и языка запросов XPath.

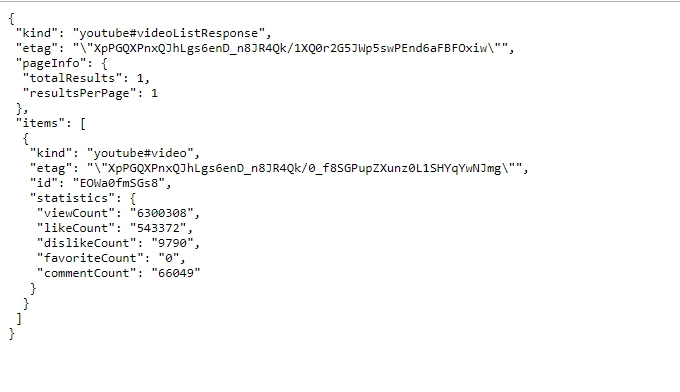

Так выглядит JSON файл на сервере:

Формула для получения количества просмотров в таблицах:

=ImportJSON(»https://www.googleapis.com/youtube/v3/videos?id=EOWa0fmSGs8&key=

&part=statistics»; «/items/statistics/viewCount»; »noHeaders»)

В принципе, XPath можно и не использовать в запросе, но тогда вы получите все содержимое JSON файла, без сегментации по параметрам. Создав необходимое количество формул с XPath параметрами вы получите только нужные данные, которые будет легче обрабатывать.

Получение списка видео по ключевому запросу

Принцип парсинга выдачи такой же, как и в примере выше, но немного меняется структура запроса.

В данном случае JSON файл с результатами выдачи по видео находится по ссылке

где параметр type указывает на то, что именно мы получим на выходе:

type=video — список видео релевантных запросу

type=channel — список каналов

type=playlist — список плейлистов

Также дополнительно в запросе можно указывать:

1. дату публикации или диапазон дат

2. регион и язык поиска

3. продолжительность видео

4. количество результатов (по умолчанию 5, максимальное 50) и т.д.

Чтобы получить список ID по запросу badcomedian используем формулу:

ImportJSON отлично работает совместно с функцией СЦЕПИТЬ, которая и позволяет нам изменяя различные параметры совершать массовый анализ или парсинг видео.

Как парсить YouTube: скрапинг видео, комментариев и других данных

Ищете подходящий YouTube-скрапер? В этой статье вы найдёте лучшие веб-скраперы, которые можно использовать для извлечения данных из YouTube, а также узнаете об особенностях создания собственного скрапера.

YouTube — это второй по популярности после Google поисковой движок. Но тут важнее не популярность YouTube как поисковика, а огромное количество видео на этом ресурсе, а также сопутствующих данных, комментариев. Возможно, вы сейчас гадаете: в чём же польза от скрапинга YouTube?

На самом деле, данным с YouTube найдётся масса применений, таких как мониторинг рейтингов, анализ настроений комментариев пользователей, создание базы описаний видео и многое другое. Для маркетологов YouTube и независимых исследователей такие данные представляют большую ценность.

YouTube предоставляет очень ограниченные возможности для доступа к общедоступным данным с некоторыми ограничениями. Если вам нужно обойти эти ограничения правильно, обычно приходится договариваться и платить. Далеко не все могут пойти этим путём, поэтому самый распространённый способ сбора общедоступных данных – использование веб-скраперов – программ, написанных специально для автоматизации добычи данных с YouTube.

В этой статье мы расскажем вам о лучших веб-скраперах для YouTube. Также вы узнаете, как распарсить его самостоятельно с помощью Python, Requests и Beautiful Soup. Но сперва мы рассмотрим основные особенности скрапинга YouTube.

Обзор скрапинга YouTube

Данные, которые мы можем вытянуть из YouTube, – это видео, комментарии, рекомендации видео, рейтинги, реклама внутри видео. Интересовались ли вы когда-нибудь, что YouTube думает об использовании веб-скраперов на его страницах? Он не разрешает собирать данные с их помощью: выгоднее, чтобы вы пользовались именно платным API.

В общем, YouTube не любит, чтобы его скрапили. Но делает ли это такой способ добычи данных незаконным? Однозначно, нет. Судебный процесс против HiQ со стороны LinkedIn и последующие иски и решения прояснили кое-что насчёт веб-скрапинга: на общих основаниях он полностью законен, и вы можете прибегать к нему, не спрашивая разрешения.

Но на пути у вас всё ещё стоят anti-scraping и anti-bot системы YouTube. Этот ресурс обладает умной anti-scraping системой, предназначенной для обнаружения и предотвращения работы ботов. Если вам всё-таки нужно вытянуть оттуда данные, вам понадобится скрапер, который сможет пройти все проверки anti-scraping и anti-bot систем. К счастью, существует много таких программ для разных платформ.

Интересно, что при наличии навыков программирования вы сможете написать свой скрапер самостоятельно. Если не получится, всегда можно вернуться к этому списку и воспользоваться одним из готовых решений.

Как скрапить YouTube с помощью Python, Requests, и Beautiful Soup

Будучи программистом, вы можете разработать собственный веб-скрапер, но это не так просто, как может показаться.

Во-первых, вы должны понимать, что скрапер, написанный для пары страниц, отличается от того, что потребуется для обработки сотен или тысяч.

Простой скрапер разбирает 20 страниц (а может, и больше), не встречая никаких преград. Но если вы будете скрапить намного больше страниц, вам придётся иметь дело с блокировщиками IP и капчами. Anti-scraping технологий много, но обход капчей и блокировщиков решает большую часть проблем.

Реализовать такой скрапер проще всего на Python, так как этот язык предоставляет библиотеки и фреймворки, которые упростят разработку.

То, какие библиотеки вам понадобятся, в большинстве случаев зависит от типа данных, которые нужно собрать. Если выполнение скриптов и JavaScript-рендеринг не нужны, подойдут Requests и Beautiful Soup, Scrapy тоже будет хорошим выбором. Но если требуется выполнить js-скрипты, чтобы вытянуть данные, лучшим решением будет Selenium.

Разрабатывая веб-скрапер для YouTube, нужно обеспечить избегание блокировки IP и прохождение капчей. Скрыть IP и избежать блокировки вам помогут прокси, а расправиться с капчами при их срабатывании — решатели капчей.

Если вы собираетесь обработать большое количество страниц, а процесс требуется ускорить, стоит задуматься о применении многопоточности. Ниже представлен простой скрапер YouTube, который принимает URL видео и возвращает количество его просмотров.

Лучшие скраперы YouTube

Если же вы не программист, вы можете найти готовые скраперы для YouTube (вам не придется написать ни строчки кода). Впрочем, не все из них «non-code» – некоторые потребуют от вас определённых навыков. Ниже представлены лучшие программы, которые можно использовать для скрапинга YouTube.

Octoparse

Если вам надоели блокировки, представляем вам Octoparse — скрапер, который поможет справиться с проверками безопасности даже на самых продвинутых сайтах. Пожалуй, это один из лучших веб-скраперов на рынке. Вы можете использовать его для добычи общедоступных текстовых данных с YouTube.

Octoparse облегчает процесс скрапинга, ведь в нём уже есть готовые шаблоны для работы с популярными сайтами, что избавляет вас от необходимости с нуля прописывать все правила для определённых сайтов.

ScrapeStorm

ScrapeStorm – один из наиболее универсальных скраперов, так как его можно использовать для скрапинга почти всех сайтов (и YouTube в том числе). Поддерживается он всеми наиболее популярными операционными системами. Также доступна версия на базе облачных технологий.

Этот инструмент использует искусственный интеллект, который в большинстве случаев автоматически распознаёт данные и парсит их без вмешательства человека.

Data Miner

Data Miner – расширение для браузера с поддержкой Chrome и Microsoft Edge. Data Miner также может использоваться для скрапинга YouTube. С таким скрапером можно не бояться обнаружения, потому что он умеет скрывать подозрительное поведение.

Data Miner не выдаст ваши данные, а ещё он поддерживает более 15000 сайтов. Здесь есть бесплатный тариф, который, возможно, идеально вам подойдёт, если вы не планируете скрапить в крупных масштабах.

Что вам точно понравится в Data Miner, – это более 50000 предварительно созданных запросов, которые помогут вам выполнить работу одним щелчком мыши. Data Miner заполняет формы, упрощает автоматический парсинг и обеспечивает поддержку пользовательского парсинга.

ParseHub

ParseHub это ещё одно устанавливаемое программное обеспечение, которое можно использовать для скрапинга. ParseHub не является специализированным инструментом для парсинга YouTube, как и другие в этом списке. Тем не менее, он предоставляет средства для добычи общедоступных данных на YouTube, и на данный момент является одним из лучших инструментов на этом рынке.

Десктопная версия ParseHub бесплатна (с некоторыми ограничениями). А вот за облачную версию придётся платить, но она предлагает большое количество дополнительных функций.

Helium Scraper

Ещё один отличный инструмент, который можно применить для скрапинга видео, комментариев, рейтингов и других общедоступных данных на YouTube. Чтобы использовать Helium Scraper, его нужно установить на компьютер.

Большое преимущество этого скрапера – широкий спектр функций, которые позволяют парсить в крупных масштабах. К числу этих функций относятся:

Заключение

Ни один из перечисленных выше скраперов, как вы можете заметить, не предназначен исключительно для YouTube (хотя на рынке есть и такие). Универсальные скраперы позволят вам работать с куда бо́льшим количеством сайтов, если возникнет такая необходимость.

Парсинг бесплатно: 30 программ, сервисов и фреймворков

В этой статье расскажу про программы, сервисы и фреймворки для парсинга, которые позволяют собирать данные бесплатно. В подборке представлены как полностью бесплатные инструменты, так и инструменты, предоставляющие ограниченный бесплатный период либо ограниченную функциональность, но в любом случае дают возможности, которых может хватить для решения тех или иных задач.

Парсинг – это автоматизированный процесс сбора данных с сайтов, применяется для сбора контента: цен конкурентов, описаний товаров, контактов для лидов, отзывов и рейтингов, файлов и для любых других задач, когда нужно собрать большой объем информации.

Условно инструменты для парсинга разделяются на две части. Одна из них – это разработка парсинга под задачу, этим занимаются программисты, которые часто используют разные языки программирования, например, Python или JavaScript, чтобы тщательно продумать логику будущего скрипта до деталей, что требует времени и вычислительных ресурсов, но в конечном итоге дает наилучшие результаты. Задачи при таком подходе решаются точно, как нужно, можно собирать данные с необходимыми условиями, скоростью и объемами.

Программы стоит выбирать, если вам нужно простое решение с быстрым стартом, не требующее знаний языков программирования. Конечно, использование программ не позволит решить любой кейс и возможности самих программ различны, но тем не менее это отличное решение для простых задач.

Screaming Frog SEO Spider – популярная программа, специализирующаяся на работе с SEO данными, имеет широчайший функционал для аудита сайтов, полное перечисление возможностей программы займет не одну страницу. При первом знакомстве интерфейс программы может показаться громоздким из-за множества вкладок и окон, но поработав некоторое время становится понятно, что он удобен, вкладки позволяют получить быстрый доступ к отчетам, окна удобно структурируют результаты парсинга.

В бесплатной версии программа предоставляет следующие возможности:

Бесплатная версия ограничена возможностью парсить до 500 URL адресов на сайте и если ваши потребности вписываются в ограничения программы, то внимательно присмотритесь к данному продукту. Screaming Frog быстр в работе, в силу популярности на эту программу написано множество обзоров и разобраться в базовом функционале не составит труда.

Полная версия программы предоставляет возможность парсить не только SEO данные, но и любую другую информацию с сайтов используя XPath (XML Path Language) — язык запросов к элементам XML-документа.

Некоторые сайты используют методы динамической загрузки данных на стороне клиента для создания асинхронных запросов. Такие данные проблема для простых парсеров, поскольку веб-контент не встроен в исходный HTML код. Easy Web Extract заявляет о возможности сбора таких данных, при тестировании программа справилась не со всеми сайтами, вам нужно проверить эту фичу на нужных вам сайтах.

Ограничения бесплатной версии:

Остальной функционал парсера доступен в бесплатной версии, программу можно использовать для сбора небольших объемов.

FMiner – инструмент для парсинга сайтов, работа которого построена на записи ваших действий и последующем воспроизведении записанных сценариев. Созданные таким образом последовательности действий (макросы), можно редактировать в визуальном формате, что позволяет использовать инструмент без знания языков программирования.

Программа работает с динамически подгружаемыми данными (AJAX), поддерживает работу с несколькими потоками, позволяет работать с результатами поиска и несколько выходных форматов. Программа имеет видеоуроки для быстрого старта, но страницы с мануалами не работают и последние обновления на сайте датированы 2015 годом, что говорит о том, что разработчик не следит за продуктом, но установочные файлы доступны и можно загрузить билд для бесплатного использования полнофункциональной версии программы в течении двух недель.

На сайте есть раздел с документацией, рассказывающий в краткой форме возможности и основы работы с программой.

Ограничения бесплатной версии:

Helium scraper – еще одна программа для парсинга данных с сайтов. Принцип работы с программой похож на работу с FMiner, только вместо визуального представления планируемых действий программа выводит код. В целом интерфейс при первом знакомстве не такой понятный как у предыдущих программ, но программа предлагает видеоуроки и базу знаний, которые помогут быстро разобраться с основами рабочего процесса.

По функциональности программа похожа на рассмотренные выше, но имеет ряд особенностей. Одно из ключевых заявленных отличий, это возможность работать с базами данных, до 140 Терабайт, конечно это не означает, что другие программы не осилят работу с большими базами данных, но, если планируете собирать много данных, стоит присмотреться к Helium scraper. Еще одна особенность — это возможность работы с API, вы сможете интегрировать запросы в свой проект.

Ограничения бесплатной версии:

Ограничения бесплатной версии:

В силу ограничения сбора, программа подойдет вам, если нужные данные находятся (или можно вывести) не дальше второй страницы.

Программа доступна только для Windows.

Screen-Scraper – программный комплекс для парсинга данных. Программа автоматизирует копирование текста с веб-страниц, переход по ссылкам, ввод данных в формы и их отправку, итерации по страницам результатов поиска, скачивание файлов (PDF, Word, изображения и т. д.). Программа может обрабатывать практически любой сайт, включая сайты, использующие динамически подгружаемые данные AJAX.

Ограничения бесплатной версии:

Программу сложно назвать интуитивно понятной, но на сайте разработчика имеются уроки, которые позволят понять принципы работы и быстро стартовать проект.

Облачные сервисы, как и программы для парсинга предоставляют доступ к функционалу бесплатно на определенных условиях, и вы можете воспользоваться услугами сервисов для решения своей задачи. Главное отличие от программ – парсинг выполняется на удаленном сервере и не тратит ресурсы вашего компьютера.

Octoparse – облачный сервис для парсинга данных с визуальным программированием парсера. Сильные стороны сервиса – множество статей объясняющих как пользоваться сервисом и хорошие лимиты бесплатной версии.

Ограничения бесплатной версии:

Mozenda – популярный облачный сервис для парсинга сайтов. Сервис предлагает визуальный метод захвата данных, для более сложных сайтов вы сможете использовать запросы XPath, если вы разработчик, то сможете создать сценарий парсинга точно отвечающий вашей задаче. Сервис предлагает месячный демо доступ, для настройки парсинга нужно установить приложение на компьютер, дальнейшая обработка происходит в облаке.

Ограничения бесплатной версии:

Diffbot – облачный сервис для парсинга работающий на алгоритмах машинного обучения и компьютерного зрения. Сервис автоматически определяет тип страницы URL-адресов и возвращает найденные данные для поддерживаемых типов страниц (статьи, карточки товара, изображения, обсуждения или видео).

Ограничения бесплатной версии:

Scraper api – сервис для парсинга требующий программирования. Особенность сервиса Scraper API меняет IP-адреса с каждым запросом из пула включающего миллионы прокси через десятки интернет-провайдеров и автоматически повторяет неудачные запросы, тем самым гарантирует сбор нужных данных. Scraper API также обрабатывает CAPTCHA. Парсинг осуществляется через безголовый браузер.

Ограничения бесплатной версии:

Сервис подойдет в случае, если вы умеете программировать на одном из языков, NodeJS, Python, Ruby или PHP и вам нужно получить данные с сайта с высокой степенью защиты.

Scrapy Cloud — это проверенная в боях облачная платформа для запуска парсеров, требующая знания языков программирования и предоставляющая гибкие инструменты для создания проектов со сложной логикой. Сервис предлагает интересный бесплатный тариф с безлимитным количеством данных, ограниченно только время работы – 1час.

Ограничения бесплатной версии:

Сервис подойдет в случае, если вы умеете программировать и ваш проект содержит сложную логику для извлечения данных.

ScrapingBee – сервис для парсинга сайтов использующий безголовый браузер и ротацию прокси. Сервис может рендерить Javascript, это позволяет парсить любой веб-сайт, даже одностраничники использующие React, Angulars, Vue.js или любые другие библиотеки. Большой пул прокси серверов поможет снизить вероятность блокировки и увеличить скорость сбора данных благодаря одновременному использованию нескольких браузеров.

Ограничения бесплатной версии:

Сервис требует программирования скриптов (CURL, Python, NodeJS, Java, Ruby, Php, Go), подойдет в случае сложной, кастомизируемой логики для извлечения данных и необходимости рендеринга JavaScript.

Apify – сервис для парсинга данных построенный по принципу магазина готовых решений. По сути, это шаблоны, настроенные на самые популярные кейсы: сбор данных с Amazon, Instagram, Booking и т.д. Работа происходит через обращение к API сервиса, все представленные шаблоны сопровождаются документацией, и вы можете поменять запрос, чтобы он в точности соответствовал вашей задаче.

Ограничения бесплатной версии:

Сервис требует умения вызова API, подойдет для парсинга популярных сайтов, имеет хорошие лимиты для бесплатного использования.

Web Scraper – сервис для парсинга который максимально упрощает извлечение данных с сайтов. Настройка парсера, происходит в визуальном редакторе посредством указания того, какие элементы нужно собирать, программирование не требуется. Web Scraper позволяет создавать карты сайта из различных типов селекторов. Эта система позволяет в последующем адаптировать извлечение данных к разным структурам сайта.

Ограничения бесплатной версии:

CrawlMonster – инструмент для парсинга SEO показателей сайта, вы можете сканировать, хранить и получать доступ к SEO-данным вашего веб-сайта, таким как контент сайта, исходный код, статусы страниц, распространенные ошибки, проблемы безопасности и многие другие.

Ограничения бесплатной версии:

eScraper – сервис позволяющий парсить любые сайты, ориентирован на электронную коммерцию и имеет простые интеграции с магазинами построенными на Magento, PrestaShop, WooCommerce или Shopify. Работает с динамически загружаемым контентом, например, раскрывающиеся списки, разделы “показать больше”, “следующая страница”, чекбоксы.

Ограничения бесплатной версии:

80legs – сервис для парсинга построенный на основе шаблонов. Приложения для сканирования 80legs используют методы Javascript, которые вы можете изменить в соответствии с любыми вашими требованиями к парсингу. Вы можете настроить, какие данные будут обрабатываться и по каким ссылкам переходить с каждого просканированного URL. Вы также можете использовать приложения для сканирования 80legs по умолчанию для сбора любых данных HTML, таких как ссылки, ключевые слова, метатеги и многое другое.

Ограничения бесплатной версии:

Phantom Buster – облачный сервис для сбора данных, предлагающий готовые решения для основных социальных сетей и других сайтов, например, Facebook, Twitter, Instagram, LinkedIn и т.д. Парсинг при помощи сервиса не требует умения программировать и позволяет легко выполнять стандартные для социальных сетей кейсы в автоматической режиме, такие как автоматическое отслеживание профилей, авто-лайки постов, отправка индивидуальных сообщений, прием заявок.

Ограничения бесплатной версии:

Ограничения бесплатной версии:

Сервис подойдет, если вам нужно получать данные из новостных источников и есть необходимость в исторических данных.

Parsers – сервис парсинга, извлекает данные из HTML страниц и импортирует их в excel, xls, xlsx, csv, json, xml файл. Сервис настраивается через расширение для браузера. Особенность сервиса – нужно выбрать необходимый тип данных только на одной, самой детальной странице сайта, далее технология сервиса найдет похожие страницы на сайте и извлечет необходимые данные. Парсинг работает автоматически на основе машинного обучения, нет необходимости указывать все страницы, каталоги и другие настройки.

Ограничения бесплатной версии:

Сервис подойдет, если вам нужно получать данные из новостных источников и есть необходимость в исторических данных.

Agenty – сервис работающий через расширение для браузера Chrome. Очень простое в использовании расширение для парсинга данных с помощью CSS-селекторов с функцией «укажи и щелкни» с предварительным просмотром извлеченных данных в реальном времени и быстрого экспорта данных в JSON / CSV / TSV.

Ограничения бесплатной версии:

Grepsr – расширение для браузера Chrome позволяющее простыми методами визуального программирования собирать данные с сайтов. Сервис предлагает интуитивно понятный интерфейс, API для автоматизации действий и интеграции с популярными системами управления документами, такими как Dropbox, Google Drive, Amazon S3, Box, также доступна выгрузка на FTP.

Ограничения бесплатной версии:

Web Robots – сервис работающий как расширение для браузера Chrome. Сервис прост в использовании, имеет интерфейс для визуального захвата данных, разобраться с ним не составит особого труда, главное преимущество – сервис автоматизирует действия. Функциональность сервиса так же проста, парсер подойдет для самых простых задач.

Ограничения бесплатной версии:

Data miner – сервис парсинга данных работающий через расширения для браузеров Google Chrome и Microsoft Edge, помогает собирать данные с различных сайтов с помощью визуального интерфейса. В Data Miner есть более 40 000 общедоступных шаблонов для множества самых популярных сайтов. Используя эти шаблоны, вы можете получить нужные данные в несколько щелчков мыши. Еще одна особенность – сервис позволяет работать со списком адресов, вы можете загрузить нужные страницы и быстро получить результат.

Ограничения бесплатной версии:

Scraper.AI – сервис парсинга данных работающий как расширения для браузеров Chrome, Firefox и Edge. Ключевая особенность Scraper.AI — это визуальное программирование парсера, не требующее работы с кодом. Так же сервис предлагает готовые шаблоны, которые настроены на сбор данных в Facebook, Instagram и Twitter.

Ограничения бесплатной версии:

Для использования фреймворков необходимо обладать знаниями языков программирования и в некоторых случаях нужны обособленные вычислительные мощности, использование библиотек для парсинга поможет реализовать задачу любой сложности и точно настроить проект под задачу.

Scrapy – это фреймворк для парсинга с открытым исходным кодом. Фреймворк написан на языке программирования Python и это одно из самых часто применяемых решений для сбора данных. Одно из основных преимуществ Scrapy – асинхронная обработка запросов. Это означает, что Scrapy не нужно ждать, пока запрос будет завершен и обработан, он может отправлять другие запросы или выполнять другие действия в этот же момент времени. Это также означает, что запросы могут выполняться, даже если при обработке какого-либо запроса возникает ошибка.

Это позволяет выполнять очень быстрый обход (одновременную отправку нескольких запросов отказоустойчивым способом), Scrapy также дает контроль над другими параметрами парсинга. Вы можете делать такие вещи как установка задержки загрузки между каждым запросом, ограничение количества одновременных запросов для каждого домена или IP-адреса и даже использовать расширение с автоматическим определением времени парсинга.

Scrapy имеет подробную документацию и большое комьюнити.

BeautifulSoup – еще один фреймворк на языке Python для парсинга данных из HTML и XML документов, имеет подробную документацию, требует дополнительных библиотек для открытия ссылок и сохранения результатов сбора данных. Он более прост по сравнению со Scrapy, BeautifulSoup стоит использовать, если задача не подразумевает распределение данных, не требуется реализация сложной логики, не нужно использовать прокси. Так же отличительная черта BeautifulSoup низкий порог входа, библиотека подойдет программистам даже с начальными знаниями, множество мануалов способствует быстрому освоению.

Selenium — это набор инструментов для автоматизации веб-браузеров с открытым исходным кодом, объединяет набор инструментов для управления, развертывания, записи и воспроизведения действия.

Сценарии могут быть написаны на различных языках Python, Java, C#, JavaScript, Ruby. Selenium настоящий комбайн для парсинга, позволяющий объединять не только браузеры, но и вычислительные мощности для решения задач. Этот инструмент стоит использовать, если перед вами стоят большие задачи и есть ресурсы для их реализации.

Grab — фреймворк на языке Python для написания веб-парсеров. Grab помогает создавать парсеры различной сложности, от простых 5-строчных скриптов, до сложных и асинхронных поисковых роботов, способных обрабатывать миллионы страниц. Фреймворк предлагает API для выполнения сетевых запросов и последующей обработки контента, например, для взаимодействия с деревом DOM HTML- документа.

Библиотека Grab состоит из двух основных частей:

В заключении расскажу о сервисе парсинга развитием которого я занимаюсь – iDatica. Компания занимаемся разработкой парсинга под задачи клиента. Мы очищаем и визуализируем данные, сопоставляем (матчим) товары, делаем это качественно, под ключ.

У нас нет бесплатного тарифа, почему нужны наши услуги, если есть готовые и даже бесплатные сервисы? Если коротко – сервисы требуют людей, которые будут с ними работать, требуют время на изучение функционала и не во всех случаях способны справиться с требования заказчика. Мы решаем все эти задачи.