что такое серверное помещение

Как избежать ошибок при создании серверной?

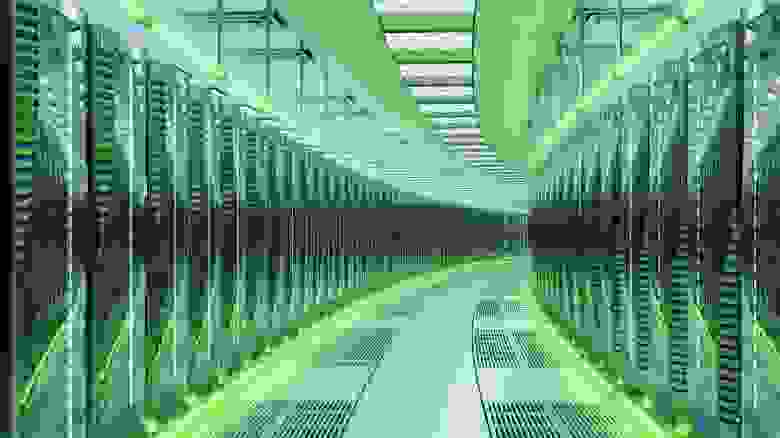

Источник: getty image

Несмотря на массовую миграцию бизнеса в облака остаются компании, руководство которых следует стратегии «всё своё ношу с собой», по различным причинам не доверяя свои вычислительные мощности сторонним дата-центрам. Однако оборудование собственного серверного помещения — не настолько простая задача, как считают многие лица, принимающие решения. В этом посте мы расскажем об ошибках, которые допускаются при самостоятельном проектировании и реализации серверного помещения.

Как ни парадоксально, ошибки при проектировании серверных допускают не только небольшие компании, но и крупные организации. Причина до смешного проста: стремление сэкономить ИТ-бюджет, особенно когда речь идёт об оснащении региональных подразделений. В результате вместо серверной получаются весьма оригинальные сооружения, даже отдалённо не похожие на место, в котором можно без опаски разместить дорогостоящее оборудование, обеспечивающее работу всех сотрудников.

Три главных составляющих надёжной серверной — это правильное помещение, качественная система управления климатом и надёжное электроснабжение. Рассмотрим, какие ошибки встречаются в процессе проектирования и реализации этих компонентов, к каким последствиям они приводят и как их избежать.

Ошибки при выборе помещения

1. Близкое соседство с водой и другими жидкостями

Если в здании организации имеется подвал, то с большой вероятностью именно его предложат использовать для оборудования серверной. Это кажется оптимальным решением по всем показателям:

Серверная в филиале крупного федерального банка располагалась в подвале, в который вёл обычный лестничный пролёт. Когда в одном из кабинетов на первом этаже прорвало блок подогрева воды в системе центрального кондиционирования, хлынула масса воды, которая залила весь первый этаж, а затем стекла в подвал. Слой воды в подвале достигал 50 см. Пострадали два сервера, размещённые на нижних «этажах» забитой до отказа стойки. Чтобы откачать воду, пришлось срочно купить два насоса, а затем просушивать помещение.

Благодаря тому, что авария произошла после обеда в пятницу, за выходные удалось проветрить помещение и уже в понедельник вернуться к почти нормальной работе.

Отсюда рекомендация № 1: выбирайте для серверных только сухие помещения, в которые не может проникнуть вода и/или другие жидкости.

2. Игнорирование нагрузки на перекрытия

В зависимости размещаемого оборудования масса полностью загруженной стойки или шкафа 42U может доходить до 1000 кг. Если таких шкафов несколько, нагрузка на перекрытия может превысить максимально допустимую. Особенно этот параметр критичен для старых зданий, прочность перекрытий в которых может оказаться значительно ниже, чем требуется для безопасного размещения оборудования.

Рекомендация № 2: прежде чем утверждать помещение для серверной, уточните массу имеющегося оборудования и прочность перекрытий.

3. Выбор помещения «оригинальной» формы

Выбирая помещение для серверных, следует учитывать следующие факторы

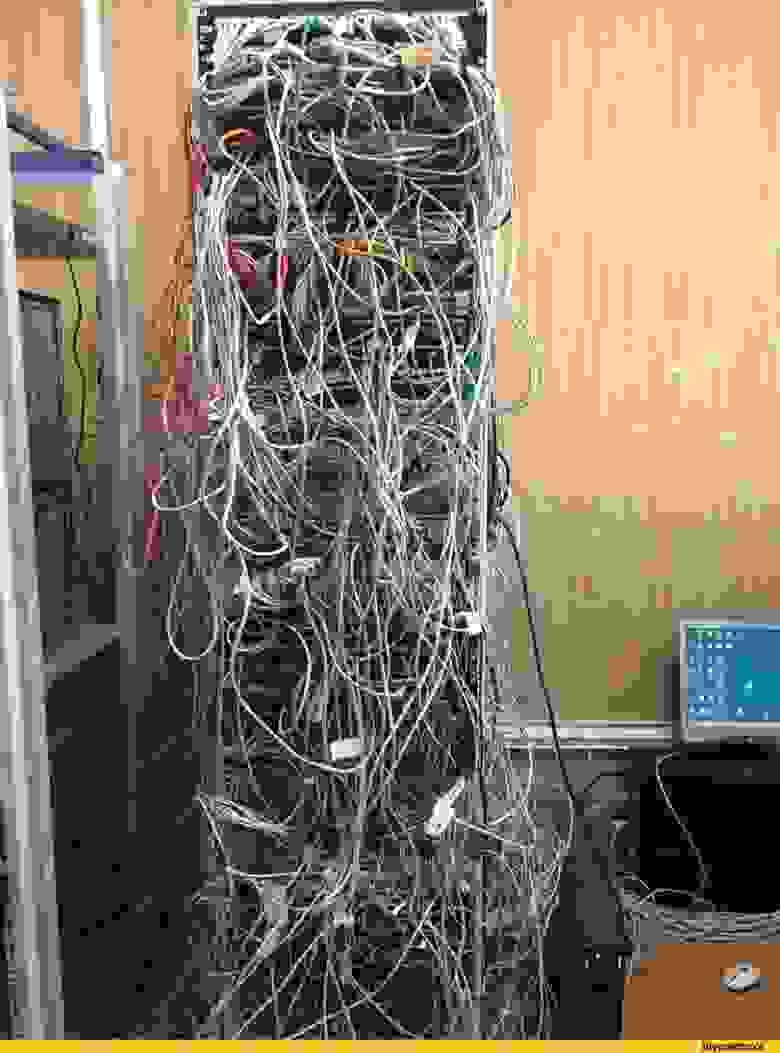

Управляющий филиала федерального банка увлекался фэн-шуем, поэтому настоял, чтобы серверная, расположенная напротив его кабинета, не имела обращённых в сторону его стола углов. В результате одна стена серверной была сделана полукруглой. Площадь помещения соответствовала техническому заданию, однако разместить в нём всё имеющееся оборудования удалось с трудом. А когда потребовалось организовать работу ещё 50 человек, принятых в результате расширения бизнеса, в серверной наступил апокалипсис:

Серверная банка выглядела даже не так, а ещё хуже, хотя кажется, что хуже — некуда. Источник фото: AliaDen / reactor.cc

Ещё один похожий случай произошёл в другом филиале этого же банка. У ИТ-отдела запросили площадь, которую занимает серверная стойка, и количество этих стоек. В итоге вместо нормальной серверной получилась «кишка» шириной в глубину стойки плюс 90 см для того, чтобы мог пройти человек. В таком виде серверная просуществовала около двух лет, пока в филиал не приехал внутренний аудит и не выписал грозное предписание.

И тут рекомендация № 3: определяя площадь серверной, разместите на плане стойки и другое оборудование с учётом будущего расширения и не соглашайтесь на компромиссы с руководством, особенно если речь идёт об «оригинальных» дизайнерских решениях.

Ошибки в системе кондиционирования и вентиляции

1. Использование бытовых кондиционеров

Многие руководители искренне считают, что для охлаждения серверной вполне уместно будет поставить в неё бытовой кондиционер — главное, выбрать модель известного производителя, а для надёжности поставить не одну «голову», а две, чтобы включать их по очереди, давай им «отдыхать».

Однако бытовые сплит-системы не рассчитаны на работу в режиме 24×7×365, поэтому через относительно небольшое время могут выйти из строя. Кроме того, они не могут направить поток холодного воздуха в «горячую» область, что значительно снижает эффективность охлаждения.

Ещё одна проблема с бытовыми кондиционерами — невозможность подключить их к системе мониторинга температуры. Это исключает возможность управления микроклиматом в серверной в соответствии с заданными параметрами.

В полукруглой серверной, о которой мы писали выше, поставили два бытовых кондиционера. Каждое утро сотрудник хозяйственного отдела заходил в серверную, выключал один из них на «отдых» и включал другой. Такая бережливость не помогла: кондиционеры проработали около года, после чего один за другим «умерли». Вместо них в конце концов был установлен прецизионный промышленный кондиционер с вменяемой системой управления.

Рекомендация № 4: никогда не пытайтесь сэкономить на серверной, используя бытовые кондиционеры. Даже если руководство настаивает, приложите максимум усилий, чтобы не допустить такого решения.

2. Использование централизованной системы вентиляции для охлаждения серверной

Ещё одно «гениальное» решение — это попытка использовать для охлаждения серверной централизованную систему кондиционирования. Такое решение имеет ещё меньше права на существование, поскольку охлаждение в ней работает лишь при ограниченном диапазоне температур, а на ночь систему охлаждения отключают для экономии электричества, поэтому охладить воздух в серверной в это время не удастся.

И снова тот же филиал банка, та же полукруглая серверная. И чилер системы централизованного кондиционирования, нависший над серверной стойкой. Его повесили, чтобы «подстраховаться» от отказа бытовых сплитов. В один совсем не прекрасный день из чилера стала капать вода. Прямо на стойку с коммутаторами. К счастью, это началось, когда в серверной работали сотрудники ИТ, поэтому они успели накрыть стойку плёнкой, так что оборудование не пострадало.

Рекомендация № 5 будет примерно такой же, как и относительно бытовых сплит-систем: централизованная система кондиционирования офиса ни при каких условиях не подойдёт для охлаждения серверной.

Ошибки организации бесперебойного электропитания

1. Использование простых ИБП на всех участках инфраструктуры

Стремление сэкономить приводит к тому, что некоторые компании закупают большую партию недорогих ИБП мощностью 500-1000 В·А и использует их не только на рабочих местах, но и для серверных стоек. Управлять такой армией бесперебойников крайне сложно, особенно при большом количестве рабочих мест. Обеспечить надежную работу таких ИБП также невозможно, особенно когда скачки напряжения — частое явление.

Уже полюбившийся вам экономный филиал банка и тут отличился: на рабочие места приобрели недорогие неуправляемые ИБП на 500 В·А, а для серверной «расщедрились» аж на устройства в 1000 В·А. Поскольку из экономии покупали не рэковые модели источников, силами сотрудников хозяйственного отдела пришлось соорудить стеллаж, на который расставили ИБП в «бытовом» исполнении. Установили его пришлось между двумя стойками, чтобы хватало длины проводов. Работало это, мягко говоря, ненадёжно, поскольку никто не озаботился тем, чтобы рассчитать максимальную нагрузку на каждый ИБП. Мощности просто не хватало, поэтому через несколько секунд после отключения электричества сервера в стойках вырубались.

Рекомендация № 6: в серверных нельзя использовать дешёвые резервные ИБП — отказы серверов, простои и потеря данных обойдутся значительно дороже такой «экономии»

2. Недостаточная номинальная мощность ИБП

При перегрузке ИБП переключается на цепь внутреннего статического байпаса (обходной линии), поэтому нагрузка становится незащищенной как от низкого качества входного электропитания, так и от пропадания этого самого входного электропитания – что создает дополнительные риски потери данных или выхода из строя компонентов инфтраструктуры.

Рекомендация № 7: чтобы ИБП обеспечивал работу подключённого оборудования, максимальная нагрузка на него не должна превышать 80% от номинала. Это значит, что ИБП номинальной мощностью 50 кВ·А рекомендуется нагружать не более, чем на 40 кВ·А.

В стойки можно ставить однофазные линейно-интерактивные устройства, но для централизованной системы придётся выбирать между трёхфазными решениями с двойным преобразованием электроэнергии. Этот вариант надёжнее, но дороже.

3. Неправильный выбор схемы организации бесперебойного электропитания

На этапе проектирования серверной следует определиться с тем, каким образом будет организовано бесперебойное электроснабжение. Если не решить этот вопрос заранее, исправление ошибок может привести к значительным затратам и простоям.

Рекомендация № 8 будет несколько объёмнее предыдущих. Чаще всего встречаются три варианта организации бесперебойного питания:

Более высокие начальные затраты на модульность целесообразны только в конфигурациях с резервированием. Здесь все зависит от индивидуальных потребностей.

В линейке продукции Eaton имеются специализированные ИБП, которые эффективно решают задачу организации бесперебойного питания серверного оборудования для среднего и малого бизнеса: модель Eaton 5PX — линейно-интерактивный ИБП на 2200 В·А с КПД до 99%, предназначенный для защиты серверов и сетевого оборудования, систем хранения данных и VoIP. Фото: Eaton

Превращаем уникальность в унификацию

Каждая серверная имеет свою уникальную историю, несмотря на стремление интеграторов и проектировщиков реализовать унифицированные проекты. Мы разобрали типичные ошибки проектирования серверных и привели рекомендации, которые позволят избежать неприятных последствий.

Для тех, кому интересно, расскажем под конец, чем закончилась история с филиалом банка. Филиал переехал в другое здание и разместился на трёх этажах. Просторная серверная с автоматической системой управления климатом разместилась на втором этаже. По соседству с серверной было выделено отдельное помещение для централизованного модульного ИБП, а в подвале смонтировали дизель-генераторную установку с автоматическим запуском в случае отключения питания. Не сказать, что всё сделано идеально, но пять лет мучений с неправильно спроектированной серверной многому научили и руководство, и сотрудников. Старое помещение филиала занял другой банк. Как он распорядился полукруглым помещением, нам выяснить не удалось.

Серверная моей мечты

Если говорить о мечтах, они не всегда рациональны. Иногда хочется удовлетворить свою “хотелку” любыми путями, так как избавиться от этой идеи невозможно. Прямо как в фильме Начало: “Идея похожа на вирус, она живуча и крайне заразна. Мельчайшее зёрнышко идеи способно прорасти и либо стать частью тебя, либо уничтожить тебя”.

Кому-то хочется купить Ламборгини, когда он живёт в городе без хороших дорог и скоростных трасс. Кто-то мечтает жить в огромном трехэтажном особняке с сотней комнат, пятью гаражами и комнатой для грязи. Один.

А мне захотелось помечтать об идеальной серверной, где каждый элемент будет работать безупречно, пускай даже некоторые решения будут очень дорогими, а вся идея – это всего лишь полёт фантазии.

Серверная – храм сисадмина

Многие из вас уже были в серверной, заглядывали туда краем глаза или в крайнем случае видели в фильмах. В кино зачастую серверная выглядит, как кабина пилота космического челнока, но в жизни всё намного прозаичней – под IT-инфраструктуру переоборудуют старую кладовку, ставят туда пару стоек и кондиционер. Но по уму надо проектировать комнату или строить отдельное здание.

Серверное оборудование встаёт в копеечку – сотни тысяч или миллионы рублей. Может показаться, что это много, но по опыту нашего системного архитектора оборудование составляет ≈10% от общих затрат на серверную. Это определяется требованиями бизнеса. Также оно обеспечивает работу бизнес-процессов, а потому к серверным выдвигаются определенные требования и рекомендации.

Например:

Повышенное давление, чтобы пыль не попадала внутрь;

Резервные источники электропитания: ИБП, дизель-генераторы и т.п.;

Уровень пола выше, чем в других помещениях. Используется в серверных, где СКС под фальшполом;

Дополнительное кондиционирование воздуха, чтобы поддерживать влажность 40-50% и температуру в пределах 20-25º С.

За всем этим добром надо следить, обновлять, в общем – обслуживать. Для этого компании нанимают сисадминов (одного или нескольких), которые настраивают и проверяют резервирование, обновляют софт, устраняют неполадки, например, бэды на жёстких дисках, следят за безопасностью и многим другим.

Созданием и планированием нашей идеальной серверной комнаты как раз займётся гипотетический сисадмин с неограниченным бюджетом и полномочиями. В общем, он попал в некий сисадминский рай. Ну или ад, тут уж зависит от точки зрения 😀

В своих мечтах он, разумеется, не будет планировать, в каких местах штробить стену, чтобы сделать розетки, а сделает упор на свои мечты и концептуальное виденье:

В каком помещении расположиться;

Как сделать постоянный микроклимат внутри;

Как организовать отказоустойчивость всех инженерных систем;

Как обеспечить пожарную безопасность, сделать СКУД и многое другое.

Дата-центр — старший брат серверной комнаты

Любой центр обработки данных является по своей сути серверной комнатой на стероидах. Задачи, которые решают ЦОД и серверная, могут пересекаться. Разница в основном в масштабах, бюджете, сертификации и надежности.

При его создании используются комплексные инженерные и IT-решения, а также определенные отраслевые стандарты. Например, американские стандарты TIA-942, TIA/EIA-568-B или европейский EN 50173−5. Почему? Когда мы говорим о ЦОДах, в последнюю очередь хочется получить непредсказуемый результат.

Ну и конечно же размышлений на этот счёт может быть +∞, поэтому дополняйте своими идеями. Уверен, что всем будет интересно.

Классификация

Поскольку спектр решаемых задач огромен, то классификация ЦОДов имеет множество параметров:

По целям использования:

Корпоративный (наш вариант) – решает задачи владельца или заказчика;

Смешанный – решает задачи владельца и арендаторов;

Хостинговый – сдаётся в аренду.

По размеру и количеству серверов – очень условное разделение (это самостоятельные объекты, а потому помимо серверов есть и всё сопутствующее необходимое оборудование):

Микро – де-факто это серверная, чаще всего создаётся в пределах основного помещения компании, вмещает ≈ до 5 серверов;

Малые – серверная побольше, может быть в пределах основного помещения или на стороне, вмещает ≈ от 5 до 24 серверов;

Средние – ЦОД, чаще всего отдельное здание или помещение, вмещает ≈ от 25 до 100 серверов;

Крупные – ЦОД, отдельное здание, вмещает ≈ от 100 и более серверов.

По назначению (оба варианта наши):

Основной – вся нагрузка на нём;

Резервный – берёт на себя нагрузку, когда случается форс-мажор, или нужно обслуживание оборудования основного ЦОДа.

По типу построения:

Контейнерные – зачастую мобильные ЦОДы, которые размещают в адаптированных грузовых контейнерах;

Мобильные – это может быть любой ЦОД, приспособленный для перемещения машинами, поездами, кораблями, самолётами и т.д;

Стационарные – ЦОДы, размещённые в здании (или в его части):

Здание, возведённое специально под ЦОД;

Переоборудованное модернизированное здание;

Трэш – самый дешевый вид, размещается в неприспособленных зданиях и помещениях (склад, ангар);

По типу размещения на местности:

Надземный – всё понятно, классической ЦОД над землёй;

Подземный – шахты, бывшие бункеры, тоннели, подземные хранилища;

Плавучий – на каком-либо водоёме, охлаждается также водой.

По отказоустойчивости:

Система классификации Uptime Institute (UI) выделяет 4 прогрессивных уровня отказоустойчивости ЦОДов (каждый последующий наследует все предыдущие уровни). UI сертификацию проходят такие компании, как Compass Datacenters, Huawei, DXN и многие другие.

Tier I – 99,671% или 1729 минут простоя за год

ЦОД уровня Tier I — это базовый уровень пропускной способности инфраструктуры для поддержки информационных технологий в офисе и за его пределами. Требования для объекта уровня Tier I включают:

Источник бесперебойного питания (ИБП) для случаев проседания напряжения, отключений и скачков напряжения;

Область для IT-систем;

Специализированное охлаждающее оборудование, которое работает не только в рабочее время;

Двигатели-генераторы на случай отключения электроэнергии.

Уровень Tier I защищает от ошибок, вызванных человеческим фактором, но не от непредвиденных отказов или перебоев. Дополнительное оборудование включает в себя чиллеры, насосы, модули ИБП и двигатели-генераторы. Объект подлежит полному отключению для профилактического обслуживания и ремонта, при этом невыполнение этого требования увеличивает риск незапланированных перебоев и серьезных последствий из-за сбоя системы.

Назначение: Server’s location.

Применение: размещение некритичных по доступности серверов, таких как системы хранения архивов, резервного копирования, почтовых серверов, системы складского учета, бухгалтерские базы данных, развертывание вспомогательных web-сервисов.

Tier II – 99,741% или 1361 минут

Объекты уровня Tier II охватывают компоненты избыточной мощности, обеспечивающие питание и охлаждение, которые гарантируют более высокое качество обслуживания и безопасность при сбоях. К этим компонентам относятся:

Оборудование для отведения тепла;

Путь к уровню Tier II обеспечивает критическую среду, а компоненты можно удалять без отключения системы. Как и объект уровня Tier I, непредвиденное отключение ЦОД уровня Tier II повлияет на систему.

Назначение: Web и Back Office.

Применение: размещение базовых web-сервисов и сайтов, развертывание служебных бизнес-систем, баз данных и некритических бизнес-приложений, хостинг (включая визуализацию и облачные решения начального уровня); хостинг небольших игровых серверов.

Tier III – 99,982% или 95 минут

ЦОД уровня Tier III с возможностью обслуживания без отключения полезной нагрузки (Concurrently Maintainable) оснащается резервными компонентами и несколькими независимыми каналами распределения, обслуживающими IT-нагрузку. В отличие от уровней Tier I и Tier II, эти объекты не требуют остановки в случае технического обслуживания или замены оборудования. Компоненты уровня Tier III добавляются к компонентам Tier II, чтобы любую деталь можно было выключить без воздействия на IT-операции.

Назначение: Business Critical.

Применение: Критические бизнес-приложения и базы данных с требованием высокой доступности, коммерческие SaaS и PaaS сервисы, облачные вычисления и виртуализация среднего уровня; сервисы, обслуживающие торговлю на бирже.

Tier IV – 99,995% или 26 минут (выбор нашего гипотетического админа)

ЦОД уровня Tier IV имеет несколько независимых и физически изолированных систем, которые действуют как компоненты избыточной мощности и каналы распределения. Разделение необходимо для предотвращения повреждения обеих систем. Среда не пострадает в связи с проведением запланированных и незапланированных мероприятий. Однако если компоненты избыточной мощности или каналы распределения отключены для технического обслуживания, среда может столкнуться с повышенным риском нарушения в случае сбоя.

Объекты уровня Tier IV добавляют отказоустойчивость (Fault Tolerance) к топологии Tier III. При сбое части оборудования или сбое в канале распределения IT-операции не пострадают. Всё IT-оборудование должно обладать отказоустойчивостью (Fault Tolerant) в части энергоснабжения. ЦОД уровня Tier IV также требуют непрерывного охлаждения (Continuous Cooling) для обеспечения стабильности окружающей среды.

Назначение: Business Continuity.

Применение: Глобальные бизнес-приложения высокой доступности, инфраструктурные решения, глобальные облачные вычисления и облачная виртуализация; инфраструктура банков.

Как вы уже догадались, наш сисадмин в раю будет создавать серверную комнату с оглядкой на стандарты ЦОДов.

Идеальная серверная

Создание серверной мечты начинается с выбора помещения. Здесь есть два пути: сделать серверную в уже имеющемся помещении или создать новое с учётом всех нюансов и “хотелок”. Поскольку наш гипотетический сисадмин ничем не ограничен, он выбирает второй путь. Итак:

Выбор места.

Серверная будет подальше от вентиляционных шахт, лифтов, подвалов, труб с водой, дренажных систем и любителей потыкать мигающие кнопки. Главный распределительный пункт (ГРП) будет внутри. От окон откажемся, чтобы солнечные лучи не попадали на оборудование, не заползали жучки, проще было поддерживать внутренний микроклимат и не отвлекаться на тополиный пух, жару, июнь на улице. Эх.

Учтём нагрузку на перекрытия, чтобы серверы не упали.

Шкаф 42U, загруженный серверами и другим оборудованием, может весить больше тонны. Ширина шкафа – 600 мм, а глубина 800 мм. Получается, что площадь, которую он занимает на полу – 0,48 м². А шкафов может быть несколько. Поэтому наш пол будет выдерживать от 2000 кг/м², чтобы с запасом и наверняка.

Сделаем высокие потолки, чтобы вместить фальшпол + стойки высотой в 42U.

Фальшпол возьмем 500 мм + 2000 мм шкаф и запас в 500 мм. Итого нам нужны потолки высотой в 3 метра.

Чистая комната.

Мы отдадим предпочтение белым стенам, полам, потолкам и оборудованию. Плюс яркое освещение. Любая грязь в такой серверной будет видна сразу. Чтобы не допустить попадания пыли внутрь, мы повысим давление. Приточный воздух будет фильтроваться и поступать в большем объеме, чем убывать.

Сделаем комнату с гидро и шумоизоляцией

Серверная – это шумное техническое помещение, не рассчитанное на долгое нахождение людей внутри. С шумоизоляцией всё понятно – это толстые стены и дверь с уплотнителями. Потолок же гидроизолируем, чтобы не допустить протечку воды. Сделали один раз и забыли.

Подключим 3 интернет-провайдера с SLA.

Для надежности надо минимум 3 магистральных провайдера, так как на практике бывают случаи одновременного отключения сразу нескольких. А для автопереключения нам понадобится собственный диапазон IP, иначе бессмысленно. Ну и SLA, чтобы получать быструю поддержку.

Кондиционирование с прецизионным охлаждением и контролем влажности.

Для охлаждения будем использовать межрядные блоки, которые осуществляют теплообмен с серверами. Принцип работы такой: фреоновый контур связан с выносным воздушным охлаждением. Шкаф при этом может быть как закрытым, так и открытым. Подобное охлаждение при небольших габаритах позволяет очень точно задать температуру, относительную влажность, а также вести удобный мониторинг и обслуживание.

Нужные нам параметры возьмём из TIA-942 и будем их придерживаться:

Температура по сухому термометру психрометра: от 20-25º С

Относительная влажность: от 40% до 50%;

Точка росы: не более 21º С ;

Скорость изменения: не более 5º С в час.

Разумеется, данные параметры должны поддерживаться во время работы серверов, поэтому и задавать их будем только после включения всего оборудования и штатной нагрузки. При дальнейшей модернизации нужно также не забывать регулировать кондиционирование.

Помимо межрядных блоков организуем расположение шкафов и стоек по перемежающейся схеме, чтобы передняя сторона в каждом ряду была обращена к передней же стороне другого ряда, создавая «горячие» и «холодные» коридоры.

Сделаем фальшпол и спрячем под ним СКС

СКС – это структурированная кабельная сеть. Хуже всего в серверной – это хаос и беспорядок. Поэтому проблему решим кардинально, спрятав всё под антистатический фальшпол. Обычный пол может накапливать статический заряд, а если случится разряд, то это может повредить оборудование.

При этом фальшпол даст нам ещё несколько преимуществ:

Заземление с медной сеткой;

Лёгкий доступ ко всем коммуникациям через люки;

Возможность установить дополнительное охлаждение (если потребуется);

Защита от затопления.

Настройка СКС – это скорее инженерное искусство, в котором есть миллионы нюансов. Наш сисадмин реализует несколько моментов, которые точно хотел бы видеть в своей серверной, но спектр работ этим не ограничится:

Ориентирование на стандарты EN 50173, ISO/IEC 11801;

Оптическая подсистема на оборудовании класса ОМ4 (высокоскоростное многомодовое оптическое волокно типа 50/125);

Медная подсистема восьмой категории CAT 8 (полоса пропускания – от 1 МГц до 2000 МГц);

Все патч-корды в медной подсистеме с защитой;

Печатная и долговечная маркировка патч-кордов и патч-панелей, чтобы прочитать информацию мог кто угодно;

Нумерация розеток и серверной части разводки;

Вся маркировка будет проходить по заранее составленной схеме с учётом плана здания;

Розетки только качественные и дорогие: чтобы сердечник не болтался, была крышка с защитой от пыли, а обжим витой пары с помощью ударника.

Все вышеописанные меры позволят с комфортом обслуживать серверную, и даже внешний сисадмин быстро разберётся, где, что и как;

Пожарная безопасность.

Чтобы серверная нашей мечты не сгорела, нужно сделать грамотную систему пожарной безопасности. Помимо стандартных требований по ГОСТу мы обеспечим дополнительные. Обычные спринклерные системы нам точно не подойдут, так как влага мгновенно уничтожит весь наш труд. Что будем использовать мы?

Сделаем мультиканальную аспирационную систему пожарных извещателей (АДПИ) с высокой чувствительностью класса А. Эта система постоянно анализирует воздух в помещении, что позволяет мгновенно реагировать на дым. Можно провести под фальшпол и в каждую стойку или шкаф отдельно;

Добавим четырехканальные комбинированные датчики дыма, тепла, пламени и газа. Плюс они будут адресными, благодаря этому мы сможем понять, в каком конкретно месте начались проблемы или требуется обслуживание оборудования. Такие датчики фиксируют несколько состояний: “нормальная работа”, “пожар”, “неисправность”, “загрязнение датчика” и другие;

Датчики, обнаружив нестандартную ситуацию, будут отправлять на наши смартфоны или почту сигналы тревоги;

Дверь, потолочные перекрытия, стены и перегородки будут из несгораемых материалов и обеспечивать огнестойкость не менее 45 минут;

Добавим светозвуковые оповещатели для безопасности людей;

Организуем систему автоматического газового пожаротушения.

Выберем инерген, так как он безопасен для людей и не мешает работе электроники.

Динамический источник бесперебойного питания.

Мы будем использовать не только несколько городских электросетей, но и установим собственную дизель-генераторную установку (ДГУ) с блекджеком и электромагнитным накопителем кинетической энергии для бесперебойного питания. Свойства такого ДГУ обеспечивают отклик на уровне сотых долей секунды, позволяя не прерывать электропитание.

Резервирование всех инженерных систем по схеме 2(N+1)

Для повышения надежности серверной необходимо резервирование компонентов системы. Схемы резервирования обозначают буквой “N” (need), где N – это количество элементов в звене системы. 2(N+1) мы будем использовать везде, в том числе в электропитании, кондиционировании, пожаротушении и т.д. Зачем? Потому что мечтать не вредно 😀

Рассмотрим резервирование на примере электропитания:

N – это система самого элементарного резервирования, например, ИБП. Для ремонта придётся выключать систему и объяснять бухгалтерии, почему 1С не работает. Вам оно надо?

N+1 даёт нам запасной ИБП. Хорошо, но всё еще есть чему выходить из строя. Нам не подходит;

2N более дорогой вариант резервирования, так как требуется больше оборудования, но и надёжность увеличивается. Однако слабое звено всё ещё остаётся, поэтому нам не подходит.

Но если мы зарезервируем электросеть дизельным генератором и сделаем бесшовное переключение на него, то система получается действительно надёжной

Но мы ведь говорим о серверной мечты, так? Поэтому на вооружение возьмём систему 2(N+1). Дополнительно подключимся к еще одной электросети, и продублируем ИБП. Вот теперь можно спать спокойно. Этому серверу больше не нужен герой.

СКУД и видеонаблюдение. Руки прочь от моей прелести.

Было бы чертовски обидно учесть столько нюансов и прогореть на человеческом факторе. Кто-то захочет полюбоваться нашей идеальной серверной, зайдёт внутрь, ну а дальше вы и сами знаете. Поэтому нам необходима продвинутая СКУД со следующими параметрами:

Доступ в серверную только у избранных;

Ограниченное время прохода, чтобы не допустить проход нескольких людей по одному пропуску;

Журнал событий: кто открыл, когда, что делал внутри;

Контроль состояния двери с оповещением о взломе или незакрытии;

Проверка температуры у сотрудников перед проходом. Нечего чихать на дорогое оборудование;

Для разблокировки поставим ультразвуковые биометрические сканеры отпечатков пальцев или сканирование сетчатки глаза. Или всё вместе.

Запрет на повторный вход, если не был выполнен выход;

Контроллер управления замком будет находиться в отдельном узле, а не интегрирован в считыватель. Сам узел разместим внутри серверной. Попробуйте теперь поковыряться в наших проводах снаружи.

Плюс наша система должна поддерживать дополнительные конфиги, например:

Ночью доступ только у главного сисадмина;

Доступ возможен только при считывании данных нескольких сотрудников: сисадмина и его котика;

Разблокировка альтернативным способом (например, другим пальцем или другим глазом), что будет сигналом опасности и разблокировки под принуждением. Оповещение полиции в комплекте.

Мечты сбываются?

Если говорить об отказоустойчивости, удобстве пользования, защищённости и т.д., то наша гипотетическая серверная идеально подойдет для большинства компаний. Остаётся только подобрать конфигурацию серверов под конкретные задачи, установить их, настроить и наслаждаться.

Да, многое из вышеописанного не потребуется малому и даже среднему бизнесу, так как требует больших финансовых вложений и дорогого обслуживания, а также может не соответствовать специфическим требованиям. Но если убрать из уравнения стоимость, то такую серверную захотели бы многие. На самом деле в конечном итоге ты приходишь к ЦОДу, так как все лучшие решения уже давно придуманы инженерами и системными архитекторами. Но при проектировании серверной администратор не так сильно ограничен стандартизацией, регламентами и прочими жесткими требованиями.

Если же спуститься на землю, то чаще всего развернуться на полную банально не даёт бюджет. Где-то можно сэкономить, где-то сделать альтернативу своими руками. Да, зачастую получается не то, что хотелось. У каждого сисадмина есть привычки, знания и параметры, по которым он настраивает работу серверной. Многие имеют за плечами техническое инженерное образование и эволюционировали из эникейщика в системного администратора, а потому прошли огонь, воду и медные проволоки.

Каждый смотрит с высоты своей стойки, поэтому было бы интересно узнать, какие идеи для “серверной мечты” есть у вас с учётом безграничного бюджета и вечнозелёного светофора на все идеи.