что такое кросс энтропия

Энтропия и кросс-энтропия

Энтропия

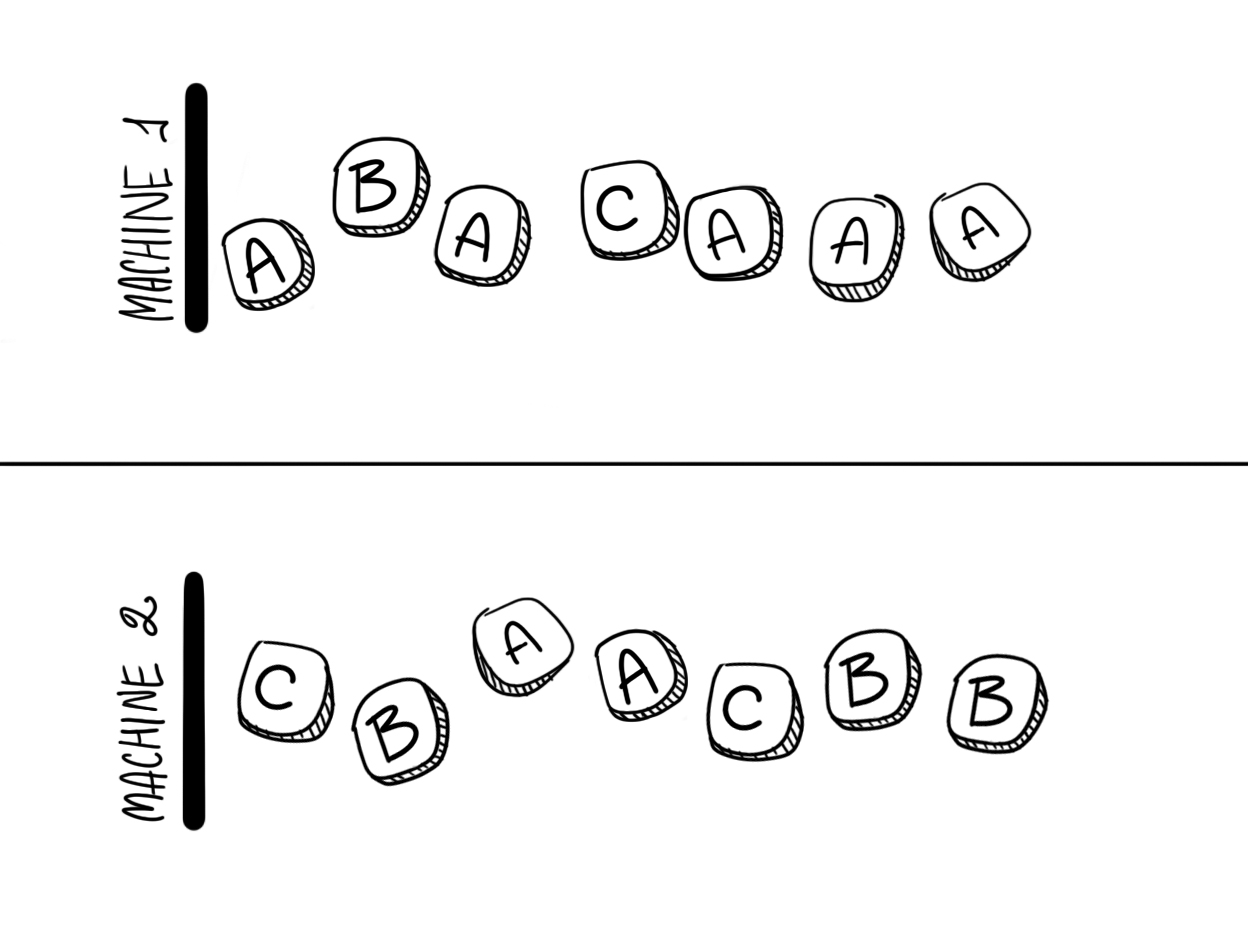

Допустим у нас есть две механических машины, которые печатают сообщения из алфавита

Символы, печатаемые второй машиной, имеют иное распределение:

Вопрос «Какая из двух машин предоставляет нам больше информации?» или мы можем переформулировать вопрос: «Если вам необходимо предсказать следующий символ, то сколько вопросов, на которые можно ответить да или нет, потребуется задать?».

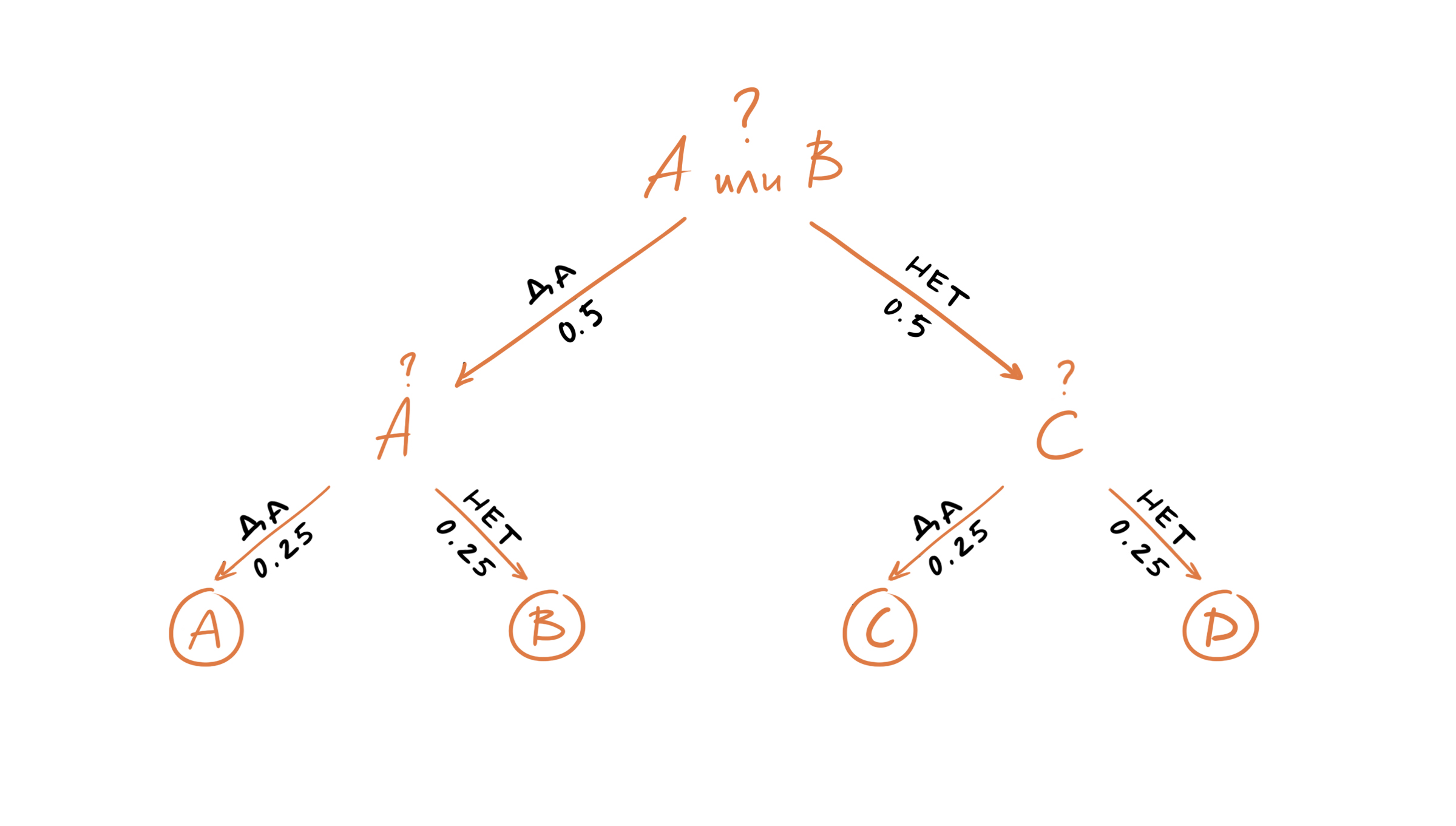

Давайте рассмотрим первую машину. Нашим первым вопросом может быть «Это символ A или B?». Так все символы появляются равновероятно, то с вероятностью 0.5 это будет «A или B» и с вероятностью 0.5 это будет «C или D». После того как мы получим ответ, нам останется задать еще один вопрос, например, «Это A?». И после того как мы получим ответ на наш последний вопрос, мы будем знать какой именно символ был следующим в последовательности, выдаваемой машиной один. Таким образом, нам достаточно двух вопросов, чтобы предсказать какой символ был сгенерирован машиной номер один.

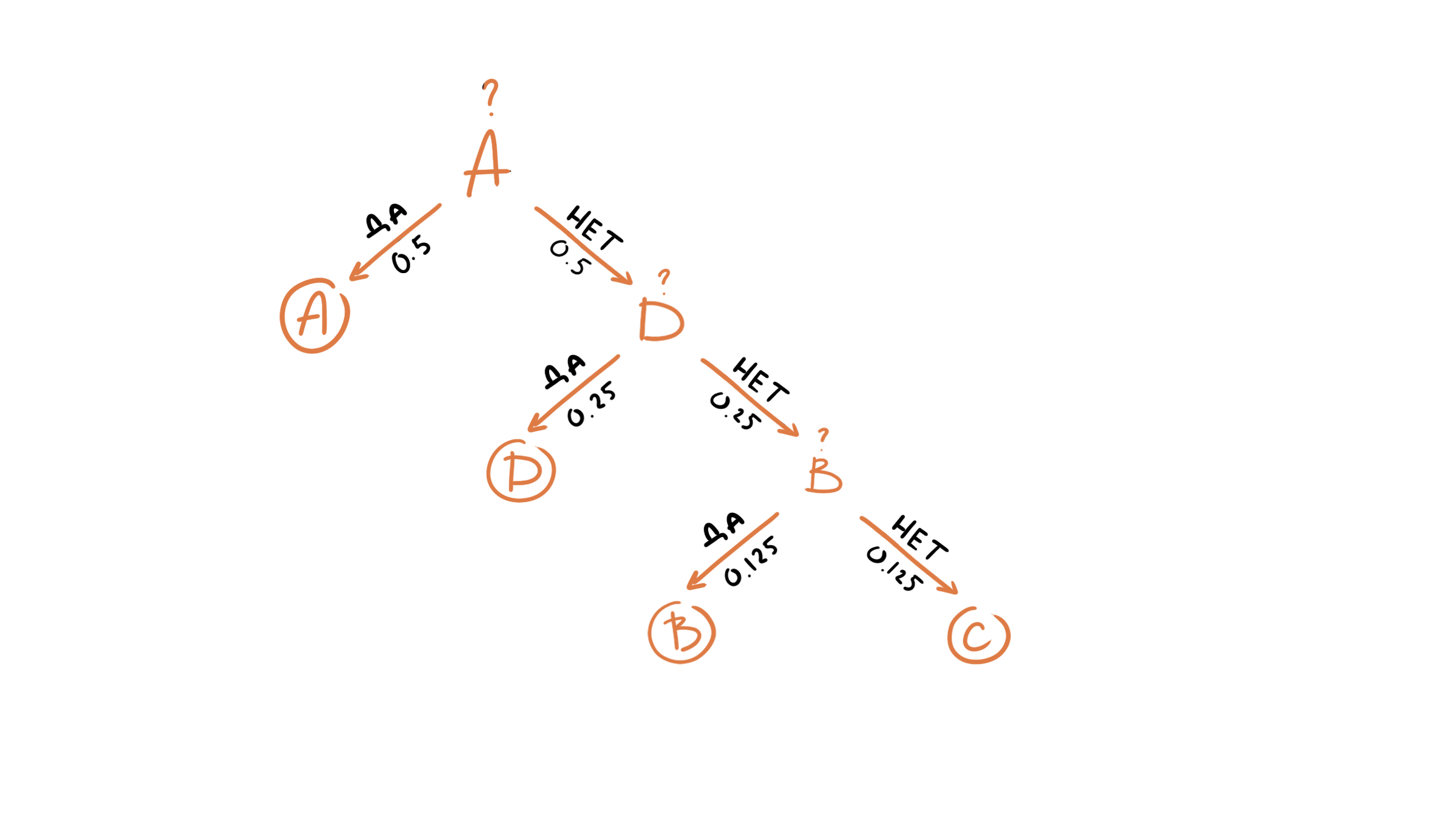

Сколько в среднем вопросов нам нужно задать, чтобы определить символ в последовательности генерируемой второй машиной?

Для этого мы можем воспользоваться формулой для вычисления математического ожидания дискретной случайной величины:

Аналогично посчитаем среднее число вопросов для первой машины:

Что такое кросс-энтропия?

Я знаю, что есть много объяснений того, что cross-entropy есть, но я все еще в замешательстве.

это только метод для описания функции потерь? Затем, мы можем использовать, например, алгоритм градиентного спуска для поиска минимума. Или это весь процесс, который также включает в себя поиск минимального алгоритма?

1 ответов

Кросс-энтропия обычно используется для количественной оценки разницы между двумя распределениями вероятностей. Обычно «истинное» распределение (то, которое пытается сопоставить ваш алгоритм машинного обучения) выражается в терминах одного горячего распределения.

например, предположим, что для конкретного учебного экземпляра метка B (из возможных меток A, B и C). Таким образом, однократное распределение для этого учебного экземпляра:

вы можете интерпретировать выше» истинного » распределения означает, что обучающий экземпляр имеет 0% вероятность быть классом A, 100% вероятность быть классом B и 0% вероятность быть классом C.

теперь предположим, что ваш алгоритм машинного обучения предсказывает следующее распределение вероятности:

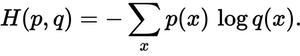

насколько близко предсказанное распределение к истинному распределению? Именно это определяет потеря кросс-энтропии. Использовать это формула:

так вот как «неправильно» или «далеко» ваше предсказание от истинного распределения.

Итак, чтобы ответить на ваши оригинальные вопросы напрямую:

это только способ чтобы описать функцию потерь?

правильно, кросс-энтропия описывает потерю между двумя вероятностными распределениями. Это одна из многих возможных функций потерь.

затем мы можем использовать, например, алгоритм градиентного спуска, чтобы найти минимальный.

да, функция потери кросс-энтропии может использоваться как часть градиентного спуска.

дальнейшее чтение: один из моих другие ответы связанные с TensorFlow.

Понимание двоичной кросс-энтропии / потери логарифма: визуальное объяснение

Дата публикации Nov 21, 2018

Введение

Если вы тренируетесьдвоичный классификаторСкорее всего, вы используетедвоичная кросс-энтропия/потеря журналакак ваша функция потери.

Вы когда-нибудь думали очто именно это значитиспользовать эту функцию потерь? Дело в том, что, учитывая простоту использования современных библиотек и сред, этоочень легко пропустить истинное значение функции потерьиспользуемый.

мотивация

Я искал сообщение в блоге, которое объясняет концепциидвоичная кросс-энтропия/потеря журналавнаглядно и лаконичночтобы я мог показать это своим ученикам вData Science Retreat, Так как я не мог найти то, что соответствовало бы моим целям, я взял на себя задачу написать это сам 🙂

Простая классификационная задача

Начнем с 10 случайных точек:

Это наш единственныйхарактерная черта:Икс,

Теперь давайте назначим некоторыецветак нашим точкам:красныйа такжезеленый, Это нашиэтикетки,

Таким образом, наша проблема классификации довольно проста: учитывая нашихарактерная чертаИкснам нужно предсказать егоэтикетка:красныйилизеленый,

Так как этобинарная классификацияМы можем также представить эту проблему как: «точка зеленаяИли, что еще лучше,какова вероятность того, что точка зеленого цвета«? Идеально,зеленые точкибудет иметь вероятность1,0(быть зеленым), в то время каккрасные точкибудет иметь вероятность0.0(быть зеленым).

В этой настройкезеленые точкипринадлежатположительный класс(ДАони зеленые), а покакрасные точкипринадлежатотрицательный класс(НЕТони не зеленые).

Если мысоответствовать моделичтобы выполнить эту классификацию, он будетпредсказать вероятность того, чтобы быть зеленымк каждому из наших пунктов. Учитывая, что мы знаем о цвете точек, как мы можемоцениватьНасколько хороши (или плохи) предсказанные вероятности? Это вся цельфункция потерь! Должно вернутьсявысокие значениядляплохие прогнозыа такженизкие значениядляхорошие прогнозы,

Длябинарная классификациякак наш пример,типичная функция потерьэтодвоичная кросс-энтропия/потеря журнала,

Функция потери: двоичная кросс-энтропия / потеря журнала

Если вы посмотрите этофункция потерьвверх, это то, что вы найдете:

гдеYэтоэтикетка(1длязеленыйочки и0длякрасныйбаллы) ир (у)является предсказаннымвероятность того, что точка зеленаядля всехNточки.

Читая эту формулу, она говорит вам, что для каждогозеленыйточка (у = 1), добавляетлог (р (у))к потере, то естьлогарифмическая вероятность того, что это зеленый, И наоборот, это добавляетЖурнал (1-р (у)), этологарифмическая вероятность того, что это красный, для каждогокрасныйточка (у = 0). Не обязательно сложно, конечно, но не настолько интуитивно понятно…

Кроме того, что делаетэнтропиясвязано со всем этим? Почему мы беремжурнал вероятностейв первую очередь? Это правильные вопросы, и я надеюсь ответить на них наПокажите мне математикуРаздел ниже.

Во-первых, давайтеТрещинаочки в соответствии с их классами,положительныйилиотрицательный, как на рисунке ниже:

Теперь давайте обучимЛогистическая регрессияклассифицировать наши очки. Подходящая регрессия представляет собойсигмовидная криваяпредставляявероятность того, что точка зеленого цвета для любого данногоИкс, Это выглядит так:

Тогда для всех точек, принадлежащихположительный класс(зеленый), каковы предсказанныевероятностидано нашим классификатором? Этизеленые полосыподсигмовидная криваянаИкскоординаты, соответствующие точкам.

Хорошо, пока, так хорошо! Как насчет точек вотрицательный класс? Помните, чтозеленые полосы подсигмовидная криваяпредставляют вероятность того, что данная точка являетсязеленый Итак, какова вероятность того, что данная точкакрасный?красные полосы вышесигмовидная кривая, конечно 🙂

Собрав все это вместе, мы получим что-то вроде этого:

Столбцы представляютпрогнозируемые вероятностисвязано с соответствующимнастоящий класскаждой точки!

Ну, топодвесные решеткибольше не имеет смысла, так что давайтепереставить их:

Так как мы пытаемся вычислитьпотерянам нужно наказывать за плохие прогнозы, верно? Есливероятностьсвязано снастоящий классявляется1,0нам нужно егопотерябытьнуль, И наоборот, если этовероятностьнизкий, сказать,0,01нам нужно егопотерябытьОГРОМНЫЙ!

Оказывается, принимая(отрицательный) лог вероятностиподходит нам достаточно хорошо для этого (Поскольку лог значений от 0,0 до 1,0 является отрицательным, мы берем отрицательный лог, чтобы получить положительное значение для потери).

На самом деле, причина, по которой мы используемжурналибо это происходит от определениякросс-энтропиипожалуйста, проверьте «Покажите мне математикуРаздел ниже для более подробной информации.

Справедливо! Давайтевзять (отрицательный) лог вероятностей— это соответствующиепотерикаждой точки.

Наконец, мы вычисляемсреднее из всех этих потерь,

Вуаля!Мы успешно вычислилидвоичная кросс-энтропия/потеря журналаэтого игрушечного примера.Это 0.3329!

Покажи мне код

Если хочешьперепроверьте значениемы нашли, простозапустить кодниже и убедитесь сами 🙂

распределение

Давайте начнем с распределения наших очков. посколькуYпредставляетклассыиз наших точек (у нас есть3 красных очкаа также7 зеленых точек), это то, что его распространение, давайте назовем этод (у), выглядит как:

Энтропия

Энтропияэтомера неопределенностисвязано с данным распределениемд (у),

Что, есливсе наши очкимызеленый? Что будетнеопределенностьизчтораспределение?НУЛЬ, правильно? В конце концов, было бынет сомнений по поводу цветао точке: этовсегдазеленый! Так,энтропия равна нулю!

Длякаждый другой случай междумы можем вычислитьэнтропия распределениякак нашд (у), используя формулу ниже, гдеСэто количество классов:

Но что если мыне надо? Можем ли мы попытатьсяприблизительное истинное распределениес некоторымидругое распределение, сказать,р (у)? Мы можем точно! 🙂

Кросс-энтропия

Давайте предположим, что нашточкиследоватьэтоДругиераспределениер (у), Но мы знаем, что онина самом деле идетотправда(неизвестный) распределениед (у), правильно?

Если мы вычислимэнтропиятаким образом, мы на самом деле вычисляемкросс-энтропиимежду обоими распределениями:

Если мы, несколько чудесным образом,совпадениер (у)вд (у)в совершенствевычисленные значения для обоихкросс-энтропииа такжеэнтропиябудет соответствоватьтакже

Так как это, вероятно, никогда не происходит,кросс-энтропия будет иметь большее значение, чем энтропиярассчитано на истинное распределение.

Расхождение Кульбака-Лейблера

Расхождение Кульбака-Лейблера,или «Дивергенция КЛДля краткости, является меройнесходствомежду двумя распределениями:

Это означает, чтоближе p (y) добирается до q (y),нижедивергенцияи, следовательно,кросс-энтропии, будет.

Функция потери

Во время обученияклассификаториспользует каждый изN балловв его учебном наборе для вычислениякросс-энтропиипотеря, эффективноподгонка распределения р (у)! Поскольку вероятность каждой точки равна 1 / N, кросс-энтропия определяется как:

Помните рисунки с 6 по 10 выше? Нам нужно вычислитькросс-энтропиина верхней частивероятности, связанные с истинным классомкаждой точки. Это означает использованиезеленые полосыдля точек вположительный класс(у = 1) икрасныйвиситбрусьядля точек вотрицательныйучебный класс(у = 0) или, математически говоря:

Наконец, с небольшой манипуляцией, мы можем взять любую точку,либо из положительных или отрицательных классовпо той же формуле:

Вуаля! Мы вернулись коригинальная формуладлядвоичная кросс-энтропия / логарифм🙂

Последние мысли

Я действительно надеюсь, что этот пост смогпролить новый светна концепции, которая довольно часто принимается как должное,двоичная кросс-энтропиякакфункция потерь, Кроме того, я также надеюсь, что это показало вам, какМашинное обучениеа такжеТеория информациисвязаны друг с другом.

Если у вас есть какие-либо мысли, комментарии или вопросы, пожалуйста, оставьте комментарий ниже или свяжитесь со мной пощебет,

Функции оценки, потерь, оптимизации – основы алгоритма Машинного Обучения

Адаптированный перевод прекрасной статьи энтузиаста технологий машинного обучения Javaid Nabi.

Чтобы понимать как алгоритм машинного обучения учится предсказывать результаты на основе данных, важно разобраться в основных концепциях и понятиях, используемых при обучении алгоритма.

Функции оценки

В контексте технологии машинного обучения, оценка – это статистический термин для нахождения некоторого приближения неизвестного параметра на основе некоторых данных. Точечная оценка – это попытка найти единственное лучшее приближение некоторого количества интересующих нас параметров. Или на более формальном языке математической статистики — точечная оценка это число, оцениваемое на основе наблюдений, предположительно близкое к оцениваемому параметру.

Под количеством интересующих параметров обычно подразумевается:

• Один параметр

• Вектор параметров – например, веса в линейной регрессии

• Целая функция

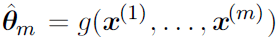

Точечная оценка

Такое определение точечной оценки является очень общим и предоставляет разработчику большую свободу действий. Почти любая функция, таким образом, может рассматриваться как оценщик, но хороший оценщик – это функция, значения которой близки к истинному базовому значению θ, которое сгенерированно обучающими данными.

Точечная оценка также может относиться к оценке взаимосвязи между входными и целевыми переменными, в этом случае чаще называемой функцией оценки.

Функция оценки

Задача, решаемая машинным обучением, заключается в попытке предсказать переменную y по заданному входному вектору x. Мы предполагаем, что существует функция f(x), которая описывает приблизительную связь между y и x. Например, можно предположить, что y = f(x) + ε, где ε обозначает часть y, которая явно не предсказывается входным вектором x. При оценке функций нас интересует приближение f с помощью модели или оценки fˆ. Функция оценки в действительности это тоже самое, что оценка параметра θ; функция оценки f это просто точечная оценка в функциональном пространстве. Пример: в полиномиальной регрессии мы либо оцениваем параметр w, либо оцениваем функцию отображения из x в y.

Смещение и дисперсия

Смещение и дисперсия измеряют два разных источника ошибки функции оценки. Смещение измеряет ожидаемое отклонение от истинного значения функции или параметра. Дисперсия, с другой стороны, показывает меру отклонения от ожидаемого значения оценки, которую может вызвать любая конкретная выборка данных.

Смещение

Смещение определяется следующим образом:

где ожидаемое значение E(θˆm) для данных (рассматриваемых как выборки из случайной величины) и θ является истинным базовым значением, используемым для определения распределения, генерирующего данные.

Оценщик θˆm называется несмещенным, если bias(θˆm)=0, что подразумевает что E(θˆm) = θ.

Дисперсия и Стандартная ошибка

Дисперсия оценки обозначается как Var(θˆ), где случайная величина является обучающим множеством. Альтернативно, квадратный корень дисперсии называется стандартной ошибкой, обозначаемой как SE(θˆ). Дисперсия или стандартная ошибка оценщика показывает меру ожидания того, как оценка, которую мы вычисляем, будет изменяться по мере того, как мы меняем выборки из базового набора данных, генерирующих процесс.

Точно так же, как мы хотели бы, чтобы функция оценки имела малое смещение, мы также стремимся, чтобы у нее была относительно низкая дисперсия.

Давайте теперь рассмотрим некоторые обычно используемые функции оценки.

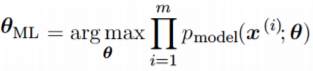

Оценка Максимального Правдоподобия (MLE)

Оценка максимального правдоподобия может быть определена как метод оценки параметров (таких как среднее значение или дисперсия) из выборки данных, так что вероятность получения наблюдаемых данных максимальна.

Оценка максимального правдоподобия для θ определяется как:

Поскольку мы предположили, что примеры являются независимыми выборками, приведенное выше уравнение можно записать в виде:

Эта произведение многих вероятностей может быть неудобным по ряду причин. В частности, оно склонно к числовой недооценке. Кроме того, чтобы найти максимумы/минимумы этой функции, мы должны взять производную этой функции от θ и приравнять ее к 0. Поскольку это произведение членов, нам нужно применить правило цепочки, которое довольно громоздко. Чтобы получить более удобную, но эквивалентную задачу оптимизации, можно использовать логарифм вероятности, который не меняет его argmax, но удобно превращает произведение в сумму, и поскольку логарифм – строго возрастающая функция (функция натурального логарифма – монотонное преобразование), это не повлияет на итоговое значение θ.

Два важных свойства: сходимость и эффективность

Сходимость. По мере того, как число обучающих выборок приближается к бесконечности, оценка максимального правдоподобия сходится к истинному значению параметра.

Эффективность. Способ измерения того, насколько мы близки к истинному параметру, – это ожидаемая средняя квадратичная ошибка, вычисление квадратичной разницы между оценочными и истинными значениями параметров, где математическое ожидание вычисляется над m обучающими выборками из данных, генерирующих распределение. Эта параметрическая среднеквадратичная ошибка уменьшается с увеличением m, и для больших m нижняя граница неравенства Крамера-Рао показывает, что ни у одной сходящейся функции оценки нет среднеквадратичной ошибки меньше, чем у оценки максимального правдоподобия.

Именно по причине сходимости и эффективности, оценка максимального правдоподобия часто считается предпочтительным оценщиком для машинного обучения.

Когда количество примеров достаточно мало, чтобы привести к переобучению, стратегии регуляризации, такие как понижающие веса, могут использоваться для получения смещенной версии оценки максимального правдоподобия, которая имеет меньшую дисперсию, когда данные обучения ограничены.

Максимальная апостериорная (MAP) оценка

Согласно байесовскому подходу, можно учесть влияние предварительных данных на выбор точечной оценки. MAP может использоваться для получения точечной оценки ненаблюдаемой величины на основе эмпирических данных. Оценка MAP выбирает точку максимальной апостериорной вероятности (или максимальной плотности вероятности в более распространенном случае непрерывного θ):

где с правой стороны, log(p(x|θ)) – стандартный член логарифмической вероятности и log(p(θ)) соответствует изначальному распределению.

Как и при полном байесовском методе, байесовский MAP имеет преимущество

использования изначальной информации, которой нет в обучающих данных. Эта дополнительная информация помогает уменьшить дисперсию для точечной оценки MAP (по сравнению с оценкой MLE). Однако, это происходит ценой повышенного смещения.

Функции потерь

В большинстве обучающих сетей ошибка рассчитывается как разница между фактическим выходным значением y и прогнозируемым выходным значением ŷ. Функция, используемая для вычисления этой ошибки, известна как функция потерь, также часто называемая функцией ошибки или затрат.

До сих пор наше основное внимание уделялось оценке параметров с помощью MLE или MAP. Причина, по которой мы обсуждали это раньше, заключается в том, что и MLE, и MAP предоставляют механизм для получения функции потерь.

Давайте рассмотрим некоторые часто используемые функции потерь.

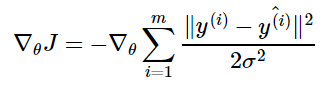

Средняя квадратичная ошибка (MSE): средняя квадратичная ошибка является наиболее распространенной функцией потерь. Функция потерь MSE широко используется в линейной регрессии в качестве показателя эффективности. Чтобы рассчитать MSE, надо взять разницу между предсказанными значениями и истинными, возвести ее в квадрат и усреднить по всему набору данных.

где y (i) – фактический ожидаемый результат, а ŷ (i) – прогноз модели.

Многие функции потерь (затрат), используемые в машинном обучении, включая MSE, могут быть получены из метода максимального правдоподобия.

Чтобы увидеть, как мы можем вывести функции потерь из MLE или MAP, требуется некоторая математика. Вы можете пропустить ее и перейти к следующему разделу.

Получение MSE из MLE

Можно смоделировать модель линейной регрессии следующим образом:

мы предполагаем, что у имеет нормальное распределение с ŷ в качестве среднего значения распределения и некоторой постоянной σ² в качестве дисперсии, выбранной пользователем. Нормальное распределения являются разумным выбором во многих случаях. В отсутствие предварительных данных о том, какое распределение в действительности соответствует рассматриваемым данным, нормальное распределение является хорошим выбором по умолчанию.

Вернемся к логарифмической вероятности, определенной ранее:

где ŷ(i) – результат линейной регрессии на i-м входе, а m – количество обучающих примеров. Мы видим, что две первые величины являются постоянными, поэтому максимизация логарифмической вероятности сводится к минимизации MSE:

Таким образом, максимизация логарифмического правдоподобия относительно θ дает такую же оценку параметров θ, что и минимизация среднеквадратичной ошибки. Два критерия имеют разные значения, но одинаковое расположение оптимума. Это оправдывает использование MSE в качестве функции оценки максимального правдоподобия.

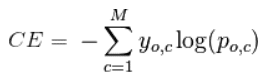

Кросс-энтропия (или логарифмическая функция потерь – log loss): Кросс-энтропия измеряет расхождение между двумя вероятностными распределениями. Если кросс-энтропия велика, это означает, что разница между двумя распределениями велика, а если кросс-энтропия мала, то распределения похожи друг на друга.

Кросс-энтропия определяется как:

где P – распределение истинных ответов, а Q – распределение вероятностей прогнозов модели. Можно показать, что функция кросс-энтропии также получается из MLE, но я не буду утомлять вас большим количеством математики.

Давайте еще упростим это для нашей модели с:

• N – количество наблюдений

• M – количество возможных меток класса (собака, кошка, рыба)

• y – двоичный индикатор (0 или 1) того, является ли метка класса C правильной классификацией для наблюдения O

• p – прогнозируемая вероятность модели

Бинарная классификация

В случае бинарной классификации (M=2), формула имеет вид:

При двоичной классификации каждая предсказанная вероятность сравнивается с фактическим значением класса (0 или 1), и вычисляется оценка, которая штрафует вероятность на основе расстояния от ожидаемого значения.

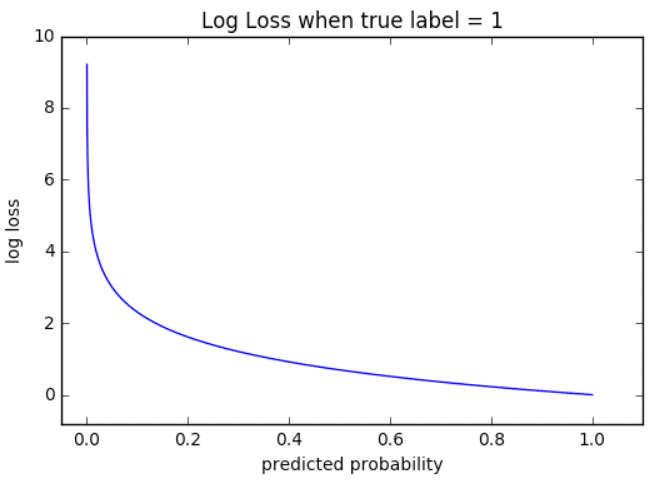

Визуализация

На приведенном ниже графике показан диапазон возможных значений логистической функции потерь с учетом истинного наблюдения (y = 1). Когда прогнозируемая вероятность приближается к 1, логистическая функция потерь медленно уменьшается. Однако при уменьшении прогнозируемой вероятности она быстро возрастает.

Логистическая функция потерь наказывает оба типа ошибок, но особенно те прогнозы, которые являются достоверными и ошибочными!

Мульти-классовая классификация

В случае мульти-классовой классификации (M>2) мы берем сумму значений логарифмических функций потерь для каждого прогноза наблюдаемых классов.

Кросс-энтропия для бинарной или двух-классовой задачи прогнозирования фактически рассчитывается как средняя кросс-энтропия среди всех примеров. Log loss использует отрицательные значения логарифма, чтобы обеспечить удобную метрику для сравнения. Этот подход основан на том, что логарифм чисел

Задача бинарной классификации

Задача состоит в том, чтобы классифицировать пример как принадлежащий одному из двух классов. Или более точно, задача сформулирована как предсказание вероятности того, что пример принадлежит первому классу, например, классу, которому вы присваиваете целочисленное значение 1, тогда как другому классу присваивается значение 0.

• Конфигурация выходного уровня: один узел с сигмовидной активационной функцией.

• Функция потерь: кросс-энтропия, также называемая логарифмической функцией потерь.

Задача мульти-классовой классификации

Эта задача состоит в том, чтобы классифицировать пример как принадлежащий одному из нескольких классов. Задача сформулирована как предсказание вероятности того, что пример принадлежит каждому классу.

• Конфигурация выходного уровня: один узел для каждого класса, использующий функцию активации softmax.

• Функция потерь: кросс-энтропия, также называемая логарифмической функцией потерь.

Рассмотрев оценку и различные функции потерь, давайте перейдем к роли оптимизаторов в алгоритмах ML.

Оптимизаторы

Чтобы свести к минимуму ошибку или потерю в прогнозировании, модель, используя примеры из обучающей выборки, обновляет параметры модели W. Расчеты ошибок строятся в зависимости от W и также описываются графиком функции затрат J(w), поскольку она определяет затраты/наказание модели. Таким образом, минимизация ошибки также часто называется минимизацией функции затрат.

Но как именно это делается? Используя оптимизаторы.

Оптимизаторы используются для обновления весов и смещений, то есть внутренних параметров модели, чтобы уменьшить ошибку.

Самым важным методом и основой того, как мы обучаем и оптимизируем нашу модель, является метод Градиентного Спуска.

Градиентный Спуск

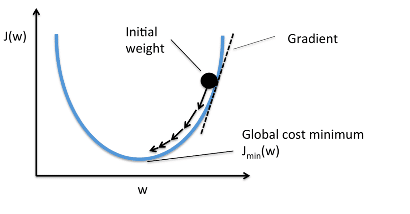

Когда мы строим функцию затрат J(w), это можно представить следующим образом:

Как видно из кривой, существует значение параметров W, которое имеет минимальное значение Jmin. Нам нужно найти способ достичь этого минимального значения.

В алгоритме градиентного спуска мы начинаем со случайных параметров модели и вычисляем ошибку для каждой итерации обучения, продолжая обновлять параметры, чтобы приблизиться к минимальным значениям.

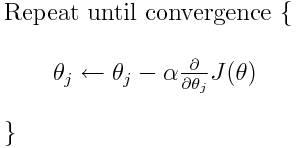

Повторяем до достижения минимума:

В приведенном выше уравнении мы обновляем параметры модели после каждой итерации. Второй член уравнения вычисляет наклон или градиент кривой на каждой итерации.

Градиент функции затрат вычисляется как частная производная функции затрат J по каждому параметру модели Wj, где j принимает значение числа признаков [1, n]. α – альфа, это скорость обучения, определяющий как быстро мы хотим двигаться к минимуму. Если α слишком велико, мы можем проскочить минимум. Если α слишком мало, это приведет к небольшим этапам обучения, поэтому общее время, затрачиваемое моделью для достижения минимума, будет больше.

Есть три способа сделать градиентный спуск:

Пакетный градиентный спуск: использует все обучающие данные для обновления параметров модели в каждой итерации.

Мини-пакетный градиентный спуск: вместо использования всех данных, мини-пакетный градиентный спуск делит тренировочный набор на меньший размер, называемый партией, и обозначаемый буквой «b». Таким образом, мини-пакет «b» используется для обновления параметров модели на каждой итерации.

Вот некоторые другие часто используемые Оптимизаторы:

Стохастический Градиентный Спуск (SGD): обновляет параметры, используя только один обучающий параметр на каждой итерации. Такой параметр обычно выбирается случайным образом. Стохастический градиентный спуск часто предпочтителен для оптимизации функций затрат, когда есть сотни тысяч обучающих или более параметров, поскольку он будет сходиться быстрее, чем пакетный градиентный спуск.

Адаград

Адаград адаптирует скорость обучения конкретно к индивидуальным особенностям: это означает, что некоторые веса в вашем наборе данных будут отличаться от других. Это работает очень хорошо для разреженных наборов данных, где пропущено много входных значений. Однако, у Адаграда есть одна серьезная проблема: адаптивная скорость обучения со временем становится очень маленькой.

Некоторые другие оптимизаторы, описанные ниже, пытаются справиться с этой проблемой.

RMSprop

RMSprop – это специальная версия Adagrad, разработанная профессором Джеффри Хинтоном в его классе нейронных сетей. Вместо того, чтобы вычислять все градиенты, он вычисляет градиенты только в фиксированном окне. RMSprop похож на Adaprop, это еще один оптимизатор, который пытается решить некоторые проблемы, которые Адаград оставляет открытыми.

Адам означает адаптивную оценку момента и является еще одним способом использования предыдущих градиентов для вычисления текущих градиентов. Адам также использует концепцию импульса, добавляя доли предыдущих градиентов к текущему. Этот оптимизатор получил довольно широкое распространение и практически принят для использования в обучающих нейронных сетях.

Вы только что ознакомились с кратким обзором оптимизаторов. Более подробно об этом можно прочитать здесь.

Я надеюсь, что после прочтения этой статьи, вы будете лучше понимать что происходит, когда Вы пишите следующий код:

Спасибо за проявленный интерес!