что такое индексация сайта веб индексация

Индексация сайта в 2021: Все что важно знать

Как поисковые системы индексируют сайты в 2021?

Как изменяются подходы к оптимизации индекса сайта?

Разберем важные нюансы об индексации сайтов поисковой системой, про которые мало кто знает.

Влияние индексации сайта на позиции в поисковой выдаче

Оптимизация индекса является отправной точкой в начале работ по продвижению любого сайта.

Удалить большое количество страниц из индекса крайне сложно.

Запрет в файле robots.txt решит проблему только для Яндекс. Для Google потребуется дополнительный переобход страниц, которые следует исключить из поисковой системы.

Нет инструментов по массовому удалению страниц из индекса Google. Официальный инструмент лишь скрывают страницы из поисковой выдачи.

Как индекс влияет на ранжирование? Влияние происходит так:

Как происходит индексация сайтов?

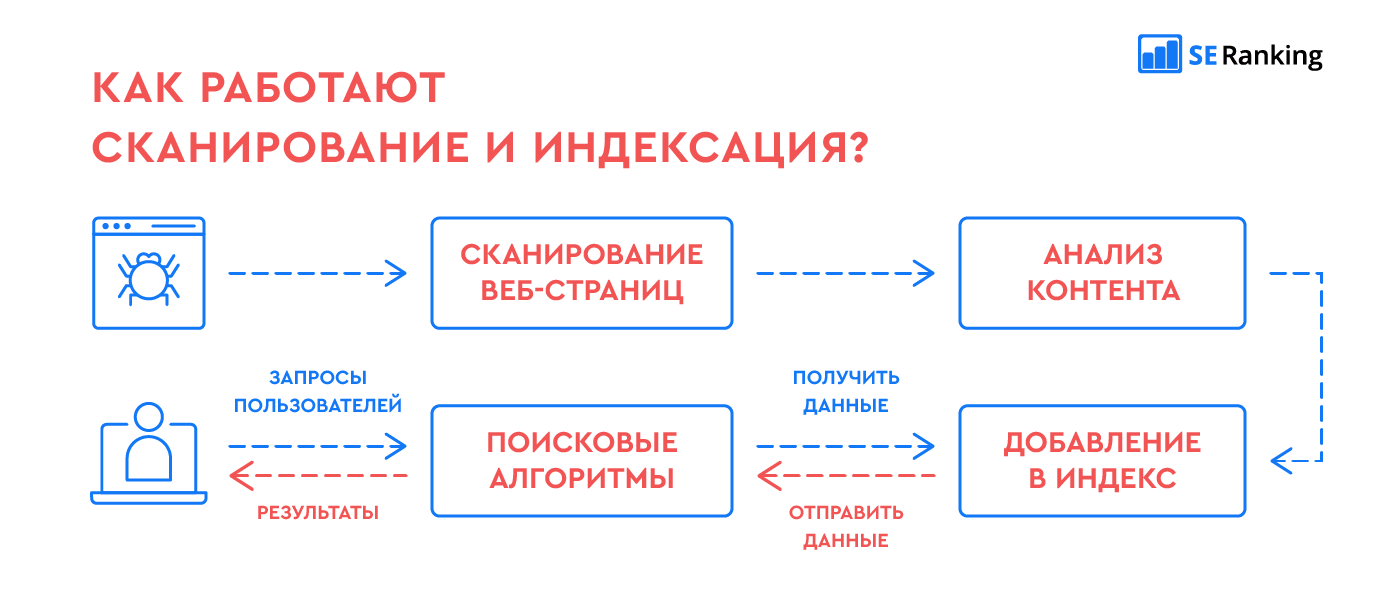

Сначала разберемся с термином. Что такое индексация сайта? Индексация сайта — сканирование, сохранение страниц в базу поисковой системы и дальнейшая обработка алгоритмами.

Процесс индексации сайта в упрощенном виде:

На практике схема индексации намного сложнее. Разберем как проходит процесс индексации на примере Google.

В процессе индексации участвует три отдельных системы: планировщик, робот для сканирования сайтов и система обработки.

Google Scheduler создает план на индексацию с учетом краулингового бюджета на сайт.

Googlebot сканирует сайты и сохраняет данные в бинарном виде.

Google Caffeine — система обработки проиндексированных страниц. Задача системы заключается в приеме, обработке и распределении страниц сайтов по индексам.

Каждую секунду Caffeine обрабатывает сотни тысяч страниц параллельно. Процесс индексации происходит постоянно. Индекс обновляется частями.

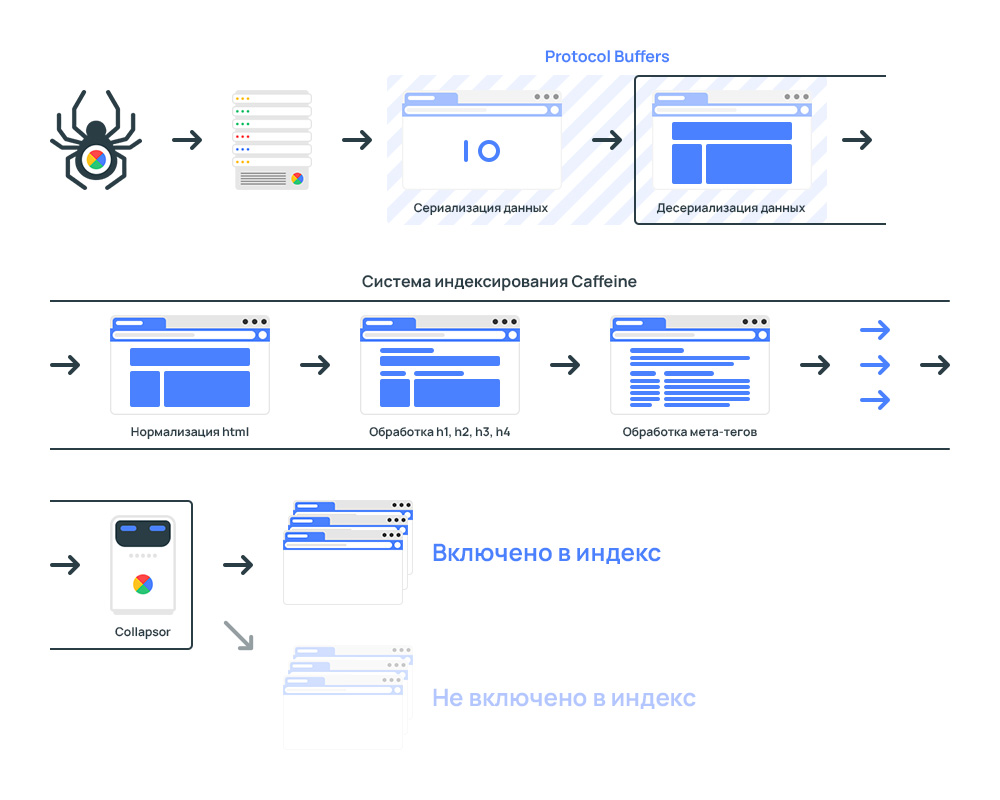

Что происходит внутри Caffeine?

Как работает Google Caffeine

Весь процесс системы индексирования:

Сначала происходит выгрузка данных, которые собрал поисковый краулер Googlebot.

Для скорости обработки данные передаются в бинарном виде, то бишь применяется процесс перевода структуры данных в последовательность байтов.

Для обработки данных применяется Protocol Buffers.

Protocol Buffers — протокол сериализации (передачи) структурированных данных, предложенный Google как эффективная бинарная альтернатива текстовому формату XML

После получение данных система индексации конвертирует данные в специальный формат, который способны анализировать роботы.

Страница передается в лексер. Предназначение лексера в поиске и исправлении ошибок в коде страницы.

Часто на сайтах встречаются ошибки в коде. Провести анализ контента со страниц с ошибками нет возможности технически.

С целью устранения ошибок код анализируются через HTML-лексер и автоматически исправляются.

Ошибки в верстке страницы напрямую никак не влияют на ранжирование.

Далее происходит нормализация данных. Страницы разбиваются на фрагменты. Например:

Google Collapsor в системе индексации сайтов

Collapsor является подсистемой в системе индексации.

Collapsor определяет куда переместить страницу. Варианты:

Именно Коллапсер присваивает страницам статус soft 404.

Коллапсер фильтрует индекс от бесполезных страниц: товар отсутствует, дубли, технические страницы и прочее.

Как обнаруживаются страницы дубли? Через анализ контрольной суммы checksum для каждой страницы, который основан на словах на странице. В результате, если есть две страницы с одинаковой контрольной суммой, то анализатор расценивает как дубли.

Индексация сайта гарантирует только обработку страниц. Попадание страниц в поисковую выдачу зависит от оценки страниц Google Коллапсером.

На основе Serving Index формируются результаты поисковой выдачи.

Google Serving Index — Индекс обслуживания

Индекс обслуживания или Serving Index — основной индекс поисковой системы состоящий из страниц, которые участвуют в ранжировании.

Находится в отдельных дата-центрах, откуда пользователи получают результаты поиска.

Документ попадает в Serving Index если:

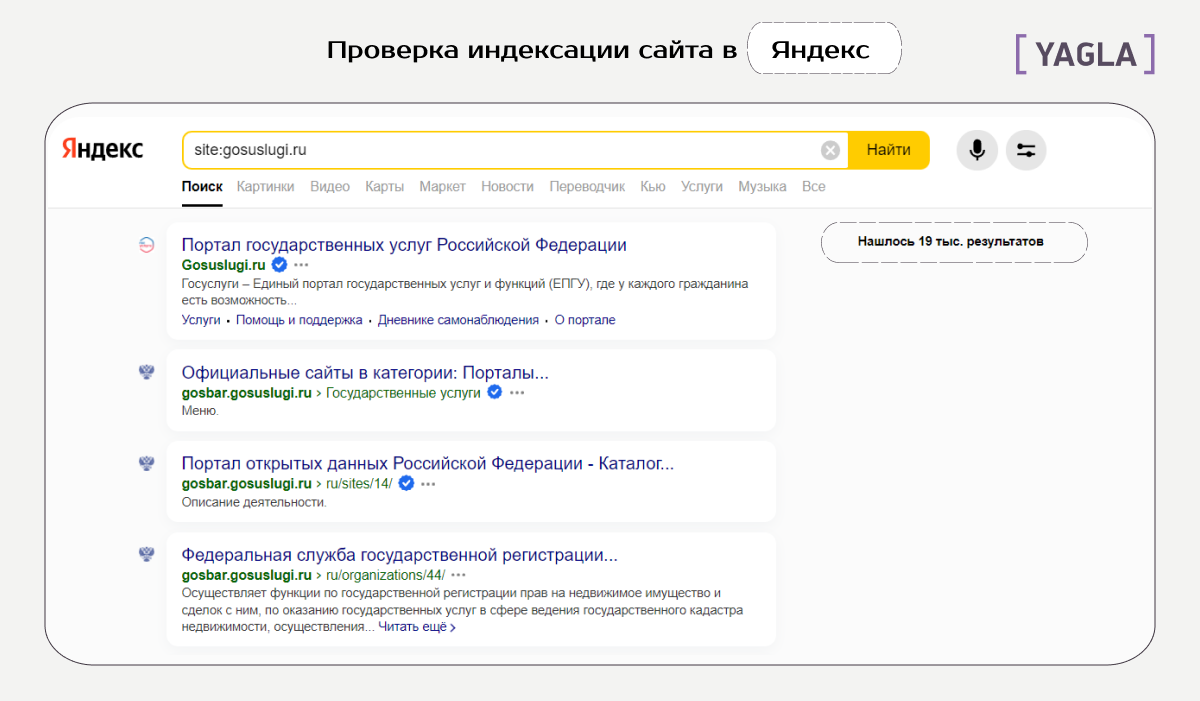

Проверка индексации сайта в Яндекс с учетом всех поддоменов сайта:

Проверка индексации в Яндекс по разделу:

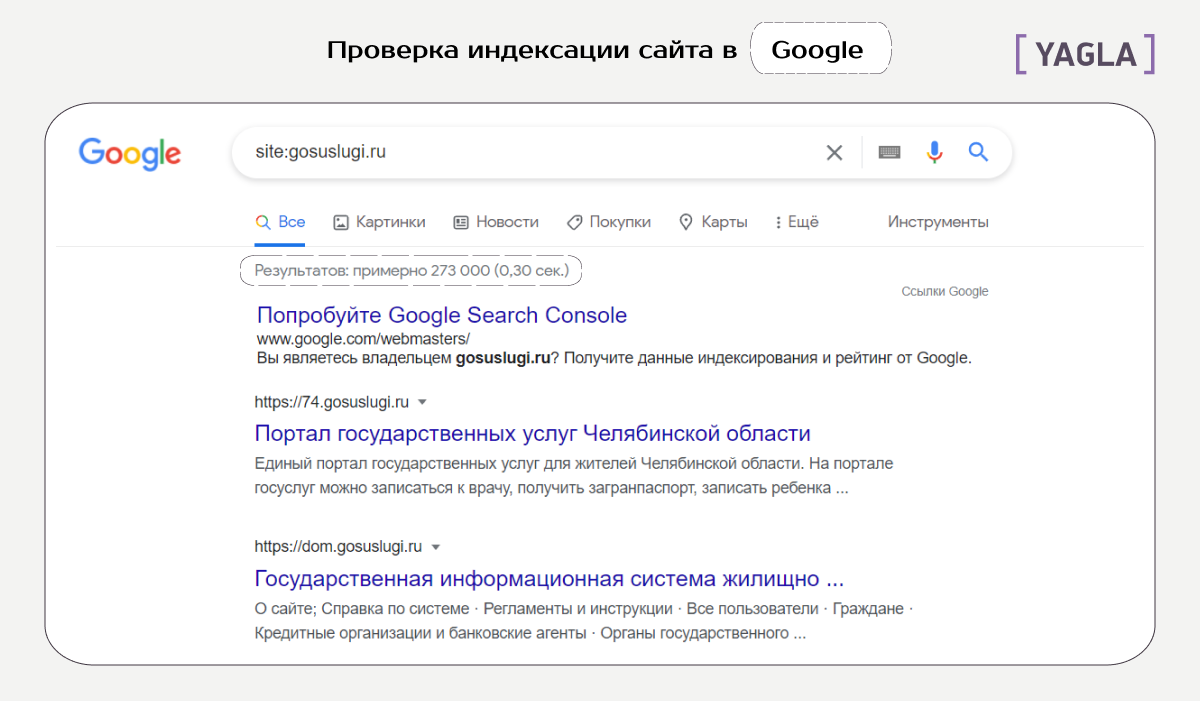

Проверка индексации сайта в системе Google с учетом всех поддоменов сайта:

Проверка индексации по разделу:

С учетом вхождений в заголовки:

Проверка индексации по разделу:

Если страницы перестали открываться, то такие страницы подлежат удалению из индекса.

Если сайт отдает код ошибки, то страницы удаляются из индекса.

Уязвимость могут эксплуатировать конкуренты по выдаче.

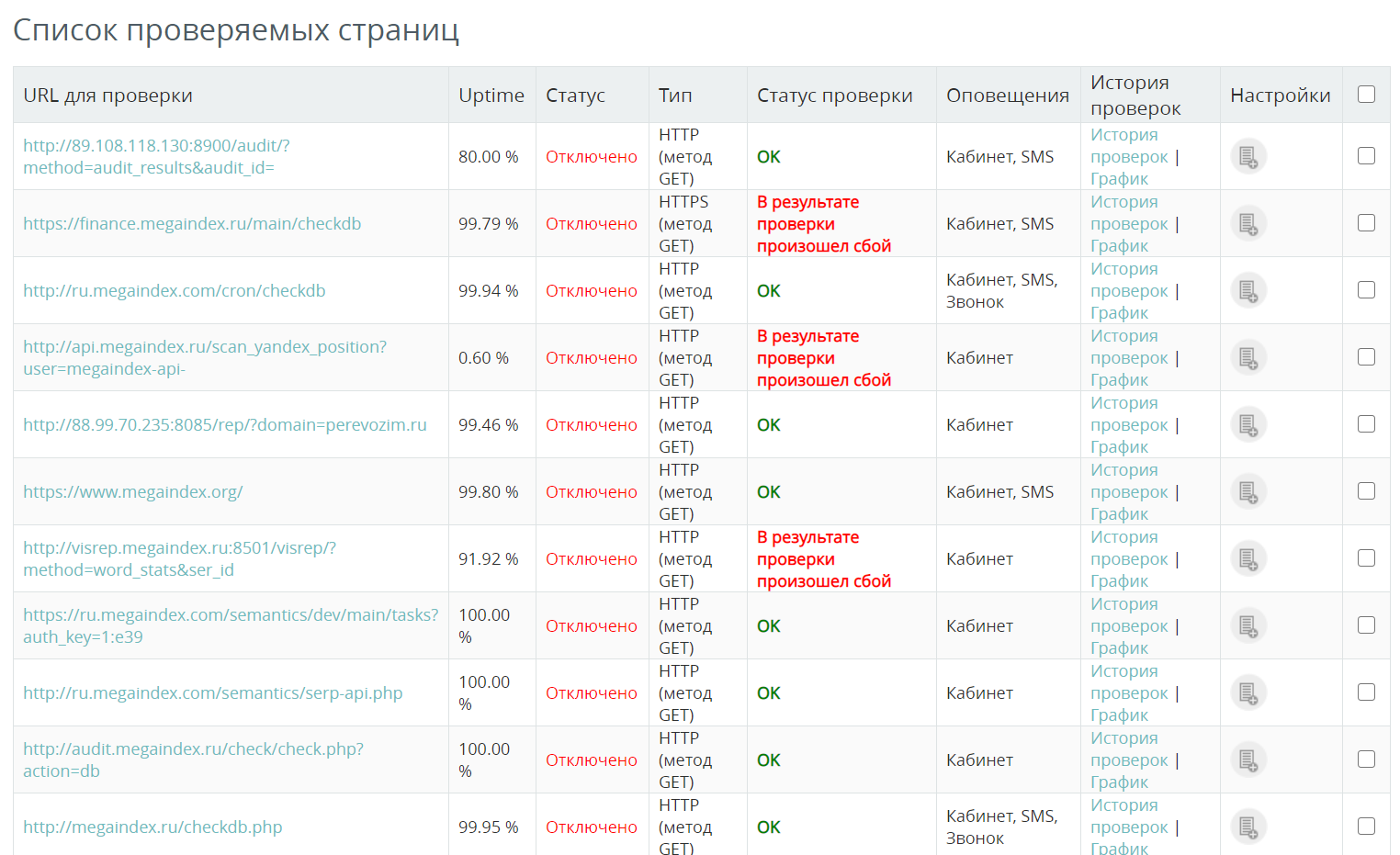

Как проверить доступность сайта? К примеру, можно использовать сервис от MegaIndex. Стоимость 1 проверки составляет 0.01 рублей. Если сервер сайта перестанет работать, система уведомит об инциденте удобным способом.

Вопросы и ответы

От чего зависит количество страниц подлежащих индексации?

Максимальное количество страниц, подлежащих индексации при очередном обходе сайта роботом определяет метрика под названием краулинговый бюджет.

Значение рассчитывает планировщик сканирования.

Как изменяются в подходы по оптимизации индекса?

Подходы к оптимизации индекса сайта действительно изменяются. К примеру, если раньше наличие большого объема страниц в поисковой выдаче сказывалось положительно на продвижении, то теперь ситуация обстоит иначе.

Большое количество страниц в индексе позволяло создавать на сайте значимый ссылочный статический вес. Сигнал передавался через ссылки на важные внутренние страницы. В результате ранжирование важных страниц улучшалось.

Но алгоритмы поисковых систем были улучшены. Тактика перестала быть эффективной. Большое количество страниц на сайте имеет смысл только в случае, если страницы способны приносить трафик.

Выводы

Задача по улучшению индексация сайта требует внимания, поскольку влияет на позиции сайта в поисковой выдаче.

Через сигналы Web Vitals на ранжирование могут влиять даже страницы, которые закрыты в robots.txt.

Открытыми к индексации должны быть такие страницы:

Приведенная информация является достоверной и подтвержденной из официальных источников.

В других поисковых системах процесс индексации схожий.

Если интересно узнать как найти на сайте бесполезные страницы и удалить страницы из индекса поисковой системы, напишите в комментариях.

Если остались вопросы по теме, напишите в комментариях.

Принципы индексации сайта в поисковиках

Когда-нибудь задумывались, как сайты попадают в выдачу поисковых систем? И как поисковикам удается выдавать нам тонны информации за считанные секунды?

Секрет такой молниеносной работы — в поисковом индексе. Его можно сравнить с огромным и идеально упорядоченным каталогом-архивом всех веб-страниц. Попадание в индекс означает, что поисковик вашу страницу увидел, оценил и запомнил. А, значит, он может показывать ее в результатах поиска.

Предлагаю разобраться в процессе индексации с нуля, чтобы понимать, как сайты попадают в выдачу Яндекс и Google, можно ли управлять этим процессом и что нужно знать про индексирование ресурсов с различными технологиями.

Что такое сканирование и индексация?

Сканирование страниц сайта — это процесс, когда поисковая система отправляет свои специальные программы (мы знаем их как поисковых роботов, краулеров, спайдеров, пауков) для сбора данных с новых и измененных страниц сайтов.

Индексация страниц сайта — это сканирование, считывание данных и добавление их в индекс (каталог) поисковыми роботами. Поисковик использует полученную информацию, чтобы узнать, о чем же ваш сайт и что находится на его страницах. После этого он может определить ключевые слова для каждой просканированной страницы и сохранить их копии в поисковом индексе. Для каждой страницы он хранит URL и информацию о контенте.

В результате, когда пользователи вводят поисковый запрос в интернете, поисковик быстро просматривает свой список просканированных сайтов и показывает только релевантные страницы в выдаче. Как библиотекарь, который ищет нужные вам книги в каталоге — по алфавиту, тематике и точному названию.

Индексация сайтов в разных поисковых системах отличается парой важных нюансов. Давайте разбираться, в чем же разница.

Чем отличается индексация в Google и Яндекс?

Индексация сайта в Google

Когда мы гуглим что-то, поиск данных ведется не по сайтам в режиме реального времени, а по индексу Google, в котором хранятся сотни миллиардов страниц. Во время поиска учитываются разные факторы ― ваше местоположение, язык, тип устройства и т. д.

В 2019 году Google изменил свой основной принцип индексирования сайта — вы наверняка слышали о запуске Mobile-first. Основное отличие нового способа в том, что теперь поисковик хранит в индексе мобильную версию страниц. Раньше в первую очередь учитывалась десктопная версия, а теперь первым на ваш сайт приходит робот Googlebot для смартфонов — особенно, если сайт новый. Все остальные сайты постепенно переходят на новый способ индексирования, о чем владельцы узнают в Google Search Console.

Еще несколько основных отличий индексации в Google:

В индекс попадают все просканированные страницы, а вот в выдачу по запросу — только самые качественные. Прежде чем показать пользователю какую-то веб-страницу по запросу, поисковик проверяет ее релевантность по более чем 200 критериям (факторам ранжирования) и отбирает самые подходящие.

Индексация сайта в Яндекс

В Яндексе процесс индексирования в целом такой же. Поисковые роботы заходят на сайт, загружают и обрабатывают данные, после чего добавляют их в индекс для дальнейшего использования в выдаче.

Что еще важно знать про индексацию в Яндекс:

В выдачу Яндекса попадают те страницы, которые максимально отвечают на поисковый запрос, содержат понятную и полезную информацию и удобны в использовании.

Что поисковые роботы делают на вашем сайте, мы разобрались, а вот как они попадают туда? Существует несколько вариантов.

Как поисковые роботы узнают о вашем сайте

Если это новый ресурс, который до этого не индексировался, нужно «представить» его поисковикам. Получив приглашение от вашего ресурса, поисковые системы отправят на сайт своих краулеров для сбора данных.

Вы можете пригласить поисковых ботов на сайт, если разместите на него ссылку на стороннем интернет-ресурсе. Но учтите: чтобы поисковики обнаружили ваш сайт, они должны просканировать страницу, на которой размещена эта ссылка. Этот способ работает для обоих поисковиков.

Также можно воспользоваться одним из перечисленных ниже вариантов отдельно для каждой поисковой системы:

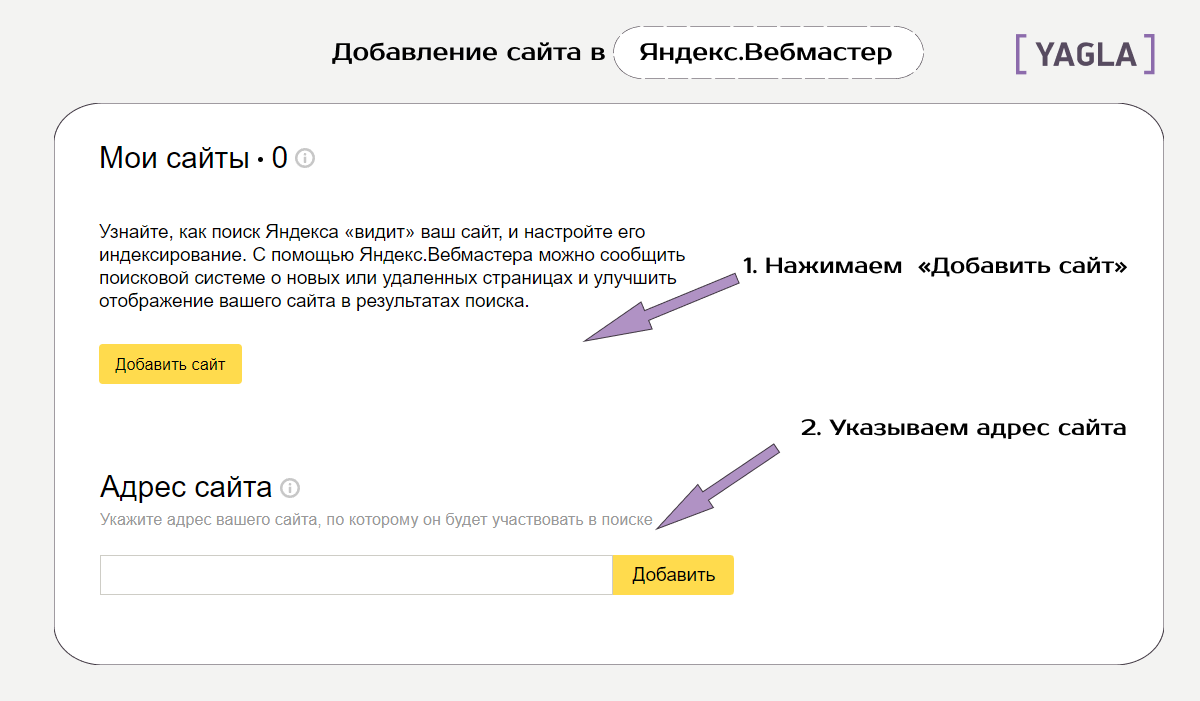

Для Яндекс

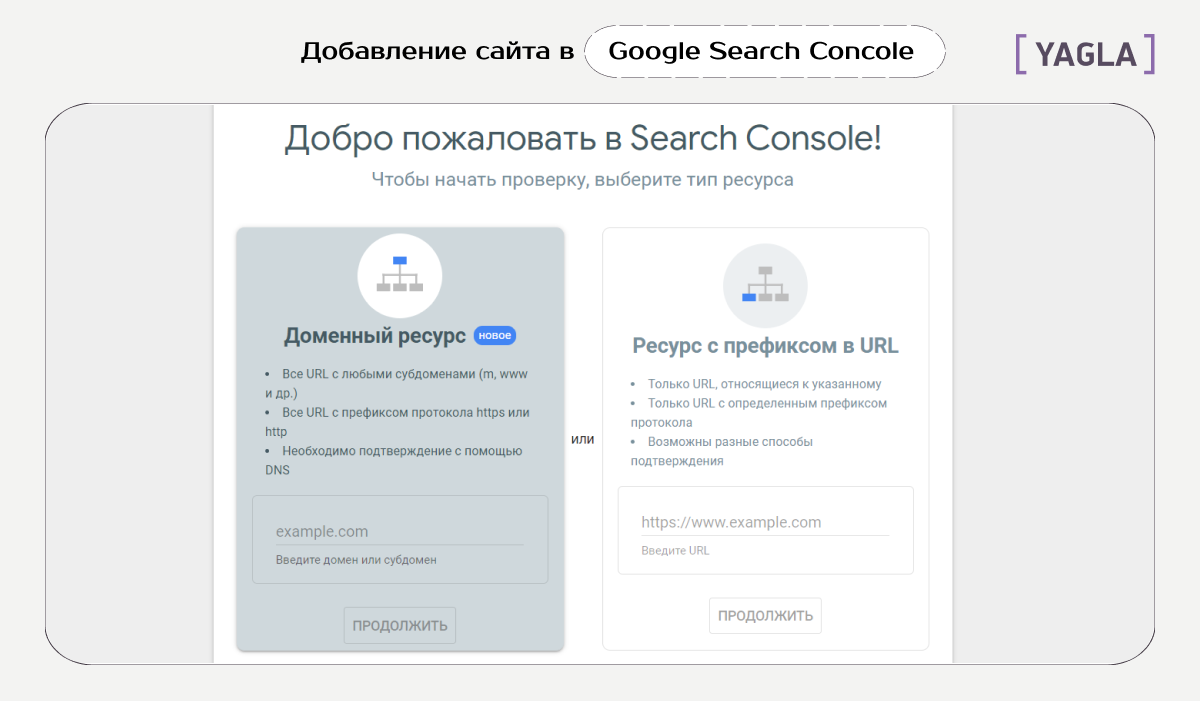

Для Google

Каждый сеошник мечтает, чтобы его сайт быстрее проиндексировали, охватив как можно больше страниц. Но повлиять на это не в силах никто, даже лучший друг, который работает в Google.

Скорость сканирования и индексации зависит от многих факторов, включая количество страниц на сайте, скорость работы самого сайта, настройки в веб-мастере и краулинговый бюджет. Если кратко, краулинговый бюджет — это количество URL вашего сайта, которые поисковый робот хочет и может просканировать.

На что же мы все-таки можем повлиять в процессе индексации? На план обхода поисковыми роботами нашего сайта.

Как управлять поисковым роботом

Поисковая система скачивает информацию с сайта, учитывая robots.txt и sitemap. И именно там вы можете порекомендовать поисковику, что и как скачивать или не скачивать на вашем сайте.

Файл robots.txt

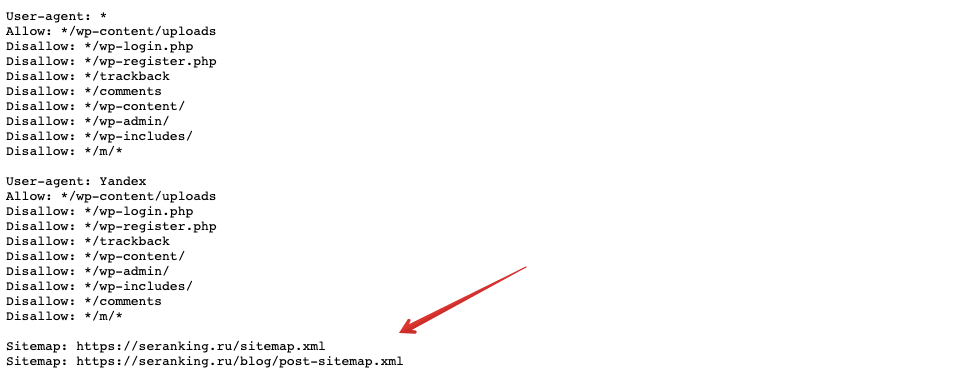

Это обычный текстовый файл, в котором указаны основные сведения — например, к каким поисковым роботам мы обращаемся (User-agent) и что запрещаем сканировать (Disallow).

Указания в robots.txt помогают поисковым роботам сориентироваться и не тратить свои ресурсы на сканирование маловажных страниц (например, системных файлов, страниц авторизации, содержимого корзины и т. д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

Также в robots.txt стоит обязательно указать адрес карты сайта, чтобы указать поисковым роботам ее местоположение.

Чтобы проверить корректность robots.txt, загрузите его в специальную форму на странице Яндекс.Вебмастер или воспользуйтесь отдельным инструментом в Google Search Console.

Файл Sitemap

Еще один файл, который поможет вам оптимизировать процесс сканирования сайта поисковыми роботами ― это карта сайта (Sitemap). В ней указывают, как организован контент на сайте, какие страницы подлежат индексации и как часто информация на них обновляется.

Если на вашем сайте несколько страниц, поисковик наверняка обнаружит их сам. Но когда у сайта миллионы страниц, ему приходится выбирать, какие из них сканировать и как часто. И тогда карта сайта помогает в их приоритезации среди прочих других факторов.

Также сайты, для которых очень важен мультимедийный или новостной контент, могут улучшить процесс индексации благодаря созданию отдельных карт сайта для каждого типа контента. Отдельные карты для видео также могут сообщить поисковикам о продолжительности видеоряда, типе файла и условиях лицензирования. Карты для изображений ― что изображено, какой тип файла и т. д. Для новостей ― дату публикации. название статьи и издания.

Чтобы ни одна важная страница вашего сайта не осталась без внимания поискового робота, в игру вступают навигация в меню, «хлебные крошки», внутренняя перелинковка. Но если у вас есть страница, на которую не ведут ни внешние, ни внутренние ссылки, то обнаружить ее поможет именно карта сайта.

Карта сайта также здорово помогает разобраться, почему возникают сложности при индексации вашего сайта. Например, если сайт очень большой, то там создается много карт сайта с разбивкой по категориям или типам страниц. И тогда в консоли легче понять, какие именно страницы не индексируются и дальше разбираться уже с ними.

Проверить правильность файла Sitemap можно на странице Яндекс.Вебмастер, а также в Google Search Console вашего сайта в разделе «Файлы Sitemap».

Итак, ваш сайт отправлен на индексацию, robots.txt и sitemap проверены, пора узнать, как прошло индексирование сайта и что поисковая система нашла на ресурсе.

Как проверить индексацию сайта

Проверка индексации сайта осуществляется несколькими способами:

1. Через оператор site: в Google и Яндекс. Этот оператор не дает исчерпывающий список страниц, но даст общее понимание о том, какие страницы в индексе. Выдает результаты по основному домену и поддоменам.

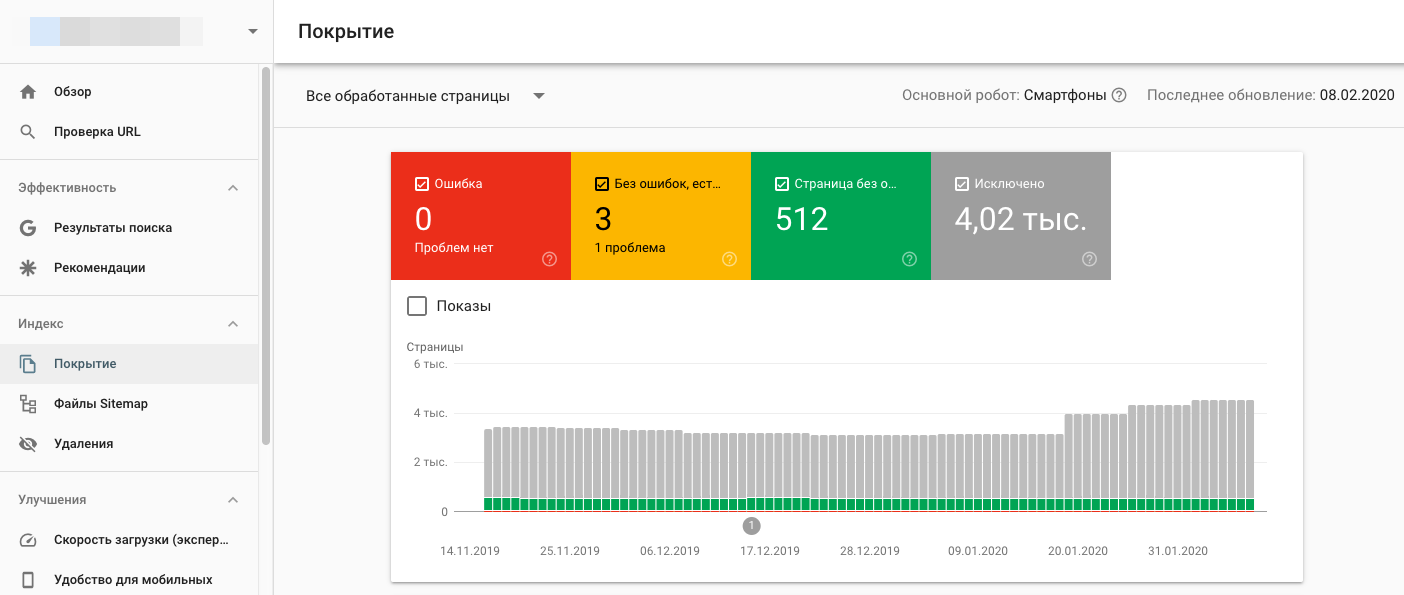

2. Через Google Search Console и Яндекс.Вебмастер. В консоли вашего сайта есть детальная информация по всем страницам ― какие из них проиндексированы, какие нет и почему.

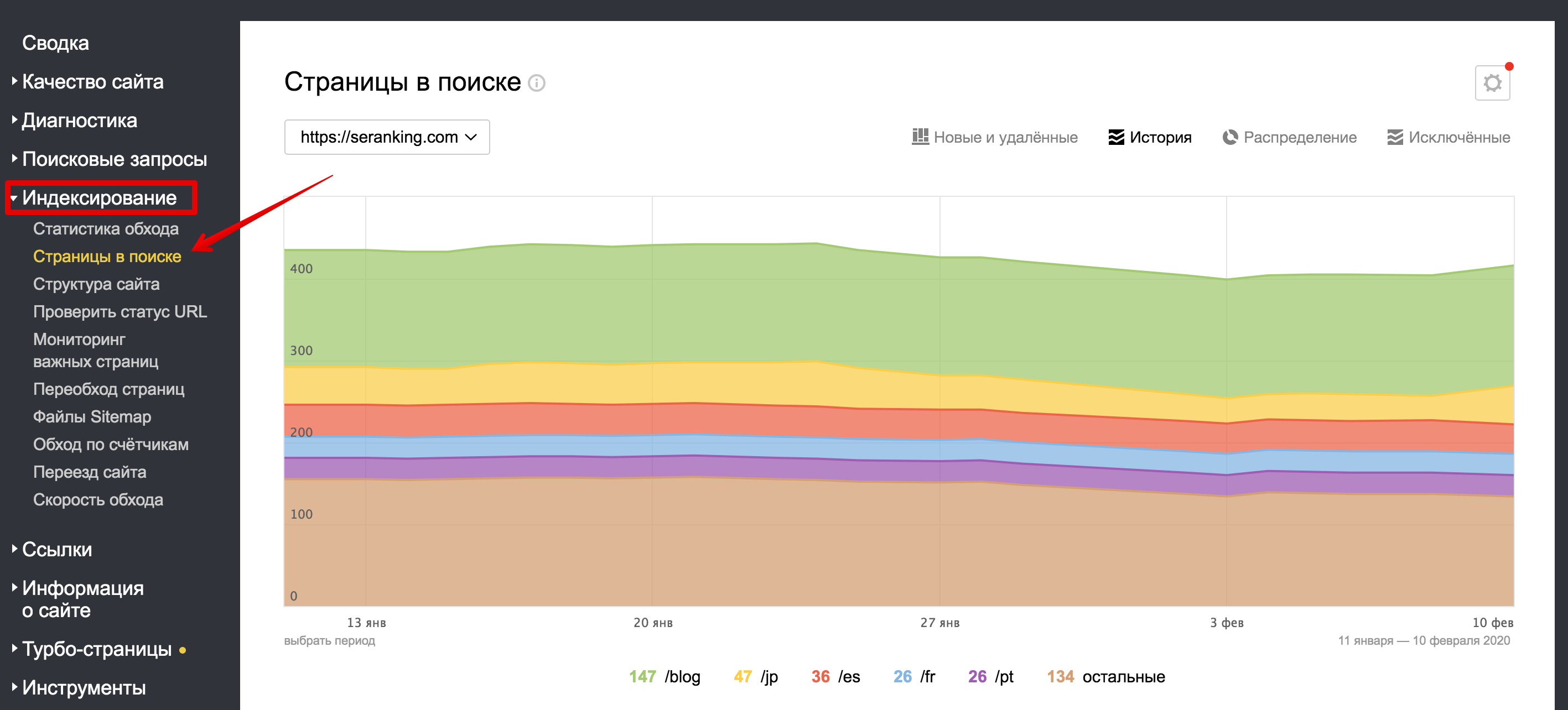

У Яндекса в Вебмастере тоже есть информация по добавленным страницам в индекс и исключенным и по каким причинам — в разделе «Индексирование ⇒ Страницы в поиске».

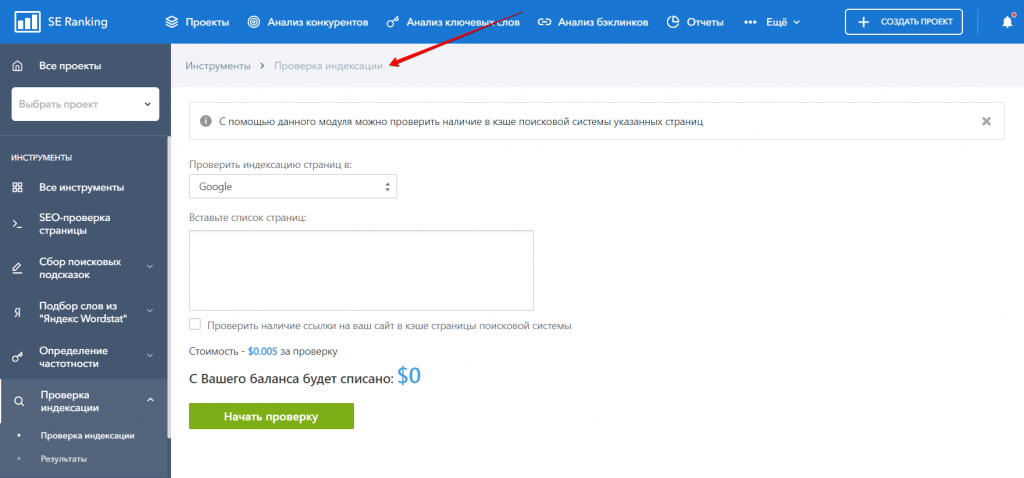

3. Воспользоваться плагинами для браузера типа RDS Bar или специальными инструментами для проверки индексации. Например, узнать, какие страницы вашего сайта попали в индекс поисковика можно в инструменте «Проверка индексации» SE Ranking.

Для этого достаточно ввести нужную вам поисковую систему (Google, Яндекс, Yahoo, Bing), добавить список урлов сайта и начать проверку. Чтобы протестировать работу инструмента «Проверка индексации», зарегистрируйтесь на платформе SE Ranking и откройте тул в разделе «Инструменты».

В этом месте вы можете поднять руку и спросить «А что, если у меня сайт на AJAX? Он попадет в индекс?». Отвечаем 🙂

Особенности индексирования сайтов с разными технологиями

Ajax

Сегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru/. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации и Google, и Яндекс есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам. Для этого в robots.txt нужно добавить такие команды:

Поисковые роботы Яндекса тоже могут индексировать сайты на AJAX, но при одном условии ― если у каждой страницы сайта есть HTML-версия. В справочнике Яндекса можно узнать подробнее, как сообщить роботу об HTML-версии страницы.

Флеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи. Поисковые роботы Яндекса индексируют только тот текст во Flash-документах, который размещен в таких блоках: DefineText; DefineText2; DefineEditText; Metadata.

Поэтому не удивительно, что поисковики предлагают не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash, пользователям мобильных устройств (они не отображают flash-контент), так и поисковым роботам Яндекса.

Фреймы

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Что в итоге

Поисковые системы готовы проиндексировать столько страниц вашего сайта, сколько нужно. Только подумайте, объем индекса Google значительно превышает 100 млн гигабайт ― это сотни миллиардов проиндексированных страниц, количество которых растет с каждым днем.

Но зачастую именно от вас зависит успех этого мероприятия. Понимая принципы индексации поисковых систем, вы не навредите своему сайту неправильными настройками. Если вы все правильно указали в robots.txt и карте сайта, учли технические требования поисковиков и позаботились о наличии качественного и полезного контента, поисковики не оставят ваш сайт без внимания.

Помните, что индексирование ― это не о том, попадет ваш сайт в выдачу или нет. Намного важнее ― сколько и каких страниц окажутся в индексе, какой контент на них будет просканирован и как он будет ранжироваться в поиске. И здесь ход за вами!

Индексация сайта в Google и Яндекс: почему сайт не индексируется

Чтобы пользователи узнали о вашем сайте и, к примеру, совершили покупку или прочитали статью — он должен отображаться в поисковых системах, вроде Google и Яндекс. Для этого каждый ресурс проходит индексацию. Этот процесс отличается от ранжирования тем, что при индексации сайт просто попадает в базу данных поисковиков, а при ранжировании — встает на конкретное место.

Мы спросили мнение у экспертов в области веб-оптимизации и рассказали в статье о том, как происходит индексация сайтов и что делать, если ваши страницы не индексируются поисковиками.

Что значит индексация сайта и почему она важна

«Индексирование сайта — это процесс, в ходе которого поисковые системы получают информацию о страницах ресурса. Полученные данные хранятся в базе, которую называют поисковым индексом. Так Яндекс, Google и другие поисковики узнают, что ваш сайт существует и наполнен полезным контентом. Индексация нужна для того, чтобы юзеры могли найти ваши страницы при поиске» — так определяет индексацию Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group.

Эксперт Роман Огрин добавляет, что индексация — важный этап запуска любого проекта, на котором планируется активное SEO-продвижение или есть планы по развитию органического трафика. Исключения составляют рекламные форматы, вроде контекстной рекламы, — для них процесс индексации не является ключевым.

Для индексирования поисковик, например Яндекс или Google, отправляет на сайт роботов, они считывают код и регулярно посещают страницы ресурса. Периодичность зависит от того, как часто меняется контент, от количества страниц и объема трафика.

Как происходит индексация сайта

Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс, сравнивает индексацию с добавлением книги в библиотеку: когда определен жанр, автор и название книги, она занимает свое место в библиотеке, и читатель может ее найти. Поэтому индексацию сайта вернее рассматривать как двухэтапный процесс: сначала идет сканирование страниц, затем — их обработка.

Сканирование страниц

Сканирование страниц — это основная задача поискового робота. Когда он попадает на новую страницу, то получает два набора данных:

Затем робот передает данные в обработку, а после — сохраняет в базе. Самый простой способ индексации страниц в рамках домена — создание карты сайта sitemap.xml.

Чтобы Google и Яндекс увидели ваш сайт, нужно cначала добавить его в сервисы, а затем прикрепить ссылку на файл Sitemap в Google Search Console и Яндекс.Вебмастере. Это специальные сервисы для веб-мастеров, которые помогают работать с индексацией.

Чтобы добавить файл Sitemap в Google Search Console, зайдите в сервис, добавьте свой сайт и перейдите в раздел «Сканирование». В пункте «Файлы Sitemap» выберите «Добавить файл Sitemap» и вставьте ссылку на файл Sitemap.

В Яндекс.Вебмастере путь похож: зайдите в ваш аккаунт, выберите нужный сайт. Затем в левом меню нажмите на раздел «Индексирование» и выберите вкладку «Файлы Sitemap». В строку «Добавить файл Sitemap» вставьте ссылку файла и нажмите «Добавить». Кстати, если вы внесли изменения в карту сайта, то просто отправьте карту на перепроверку, нажав на стрелочки рядом с файлом Sitemap.

Обработка страниц

После сбора роботами информация проходит обработку и потом попадает в базу данных. Это необходимо для ускорения дальнейшего поиска.

В начале программа формирует страницу со всем содержимым: скрипты, эффекты, стили. Важно, чтобы робот имел полный доступ ко всем файлам, потому что без них индексатор не сможет понять структуру.

Вы можете посмотреть, одинаково ли видят страницу пользователи и поисковой робот. Для этого зайдите в Google Search Console, выберите отчет «Посмотреть как Googlebot» в разделе «Сканирование».

Затем робот анализирует текст страницы: упрощает слова и определяет частоту упоминания ключевого слова, проверяет уникальность. Так, если ваш контент уже индексировали в интернете, то у страниц будет низкая уникальность. Значит, робот может не добавить их в поисковый индекс. Поэтому важно наполнять свой сайт уникальным и полезным контентом.

Как проверить индексацию

Эксперты выделяют три способа, чтобы проверить, отображается ли сайт в поисковиках: запрос в поисковой системе, использование бесплатных сервисов для автоматической проверки и использование сервисов для веб-мастеров.

Поисковая строка

Роман Огрин, руководитель группы оптимизации в Kokoc Group, называет специальные операторы самым быстрым и простым способом проверки индексации. Яндекс и Google поддерживают оператор site, который помогает отображать проиндексированные страницы. Базовый синтаксис использования: site:sitename.com

Но поисковые системы могут ограничить работу этих операторов для снижения нагрузки. Поэтому рекомендуют использовать дополнительные способы для проверки индексации.

Бесплатные плагины

«Можно использовать специальные бесплатные сервисы, например, be1.ru и pr-cy.ru. Для проверки введите адрес сайта в специальную строку и нажмите «Проверить». Обычно такие сервисы, помимо количества страниц в индексе популярных поисковиков, предоставляют еще много интересных данных» — Николай Полушкин, директор веб-студии DIUS.

Веб-сервисы Яндекс.Вебмастер и Google Search Console

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, считает веб-сервисы поисковых систем самым достоверным источником информации о наличии страницы в индексе. В этих инструментах можно получить данные о количестве, динамике индексации, причинах удаления или включения страницы в базу данных, а также многое другое. Минус в том, что доступы к этой информации могут получить только владельцы сайта или те, у кого есть права владельцев.

Эксперт Роман Огрин рассказывает, как именно посмотреть индексацию в Яндекс.Вебмастере и Google Search Console. Оба сервиса сначала надо «привязать» к исследуемому домену и только потом смотреть точную статистику.

В Яндекс.Вебмастере есть раздел «Индексирование» с подразделом «Страницы в поиске». По клику на вкладку «Все страницы» сервис выдает список проиндексированных на данный момент документов. В Search Console аналогичный инструмент — отчет «Покрытие».

Помимо простого анализа страниц в индексе, оба сервиса предоставляют много полезной статистики. Эта информация поможет сделать правильные выводы при проблемах с индексацией.

Например, посмотрите, совпадает ли количество проиндексированных страниц с количеством страниц вашего сайта. Если у вас 240 страниц, а в индексе только 100, это означает, что есть проблемы с индексацией, ведь поисковая система не знает о большей части контента.

Управление индексацией сайта

Вы можете сами задать параметры индексирования для роботов поисковых систем. Например, настройка канонического адреса необходима, если есть страницы с одинаковым содержанием. Она позволяет указать, какая из них приоритетна для индексации.

Текстовый файл robots.txt также позволяет управлять поисковыми роботами с помощью директив.

Что делать, если сайт не индексируется

Есть множество причин, почему сайт не индексируется. Эксперт Сергей Шабуров условно разделяет причины на технические и контентные. Ниже рассмотрим основные из них с примерами из опыта специалистов.

Технические причины

Сайт может быть случайно закрыт от сканирования роботами или из-за ошибки разработчиков. Это можно определить, если проверить:

Николай Полушкин, директор веб-студии DIUS, делится недавним случаем из практики. «Пришел сайт на бесплатный аудит. Клиент жаловался на резкую просадку трафика. SEO-специалист сразу открыл файл robots.txt и нашел строчку Disallow. Мы сообщили об этом клиенту и объяснили, что сайт закрыт от индексации, и страницы постепенно удаляются из поиска. Заказчик был удивлен и попросил выяснить, кто и когда это сделал. Недавно компания делала редизайн и наш специалист предположил, что страницы на время работ закрыли от индексации, а потом забыли убрать запрещающую директиву».

Контентные причины

Важно помнить, что индексация занимает некоторое время. Поэтому, если страницы нет в индексе, иногда это может значить, что роботы поисковых систем не успели до нее дойти. Либо есть ошибки в контентном наполнении страниц:

«У нас была такая ситуация с кулинарной онлайн-школой. В Google сайт показал хорошие результаты уже в первый месяц работы и вышел в ТОП-3 по прямым запросам. Но в Яндексе страницы вообще отсутствовали.

Чтобы узнать причину, мы зарегистрировали сайт в Яндекс.Вебмастере и отправили на проверку. Результаты показали критическую ошибку. Дело было в том, что на ресурсе дублировались страницы. Владельцы школы публиковали для разных таргетологов страницы с одинаковым контентом, но разными ссылками. Яндекс видел в этом неуникальный контент и не индексировал страницы.

Мы удалили дублирующиеся страницы, перейдя на utm-метки, и отправили сайт на переиндексацию. Через несколько дней проблема решилась, сайт стал отображаться в Яндексе» — Дарья Каблаш, основатель маркетингового агентства Dvizh.

Иные причины

Более редкие случаи неиндексации могут быть связаны, например, с фильтром «для взрослых».

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, приводит свежий пример из практики. «Сайт одного из российских операторов мобильной связи перестал ранжироваться по навигационному запросу: » тарифы» в Яндексе. В выдаче присутствовали побочные сайты, а ресурс оператора отсутствовал. Это неслыханная вещь, при учете, что целевая страница и все остальные были в индексе по данным Яндекс.Вебмастера. По данному запросу сайт должен был занимать как минимум несколько строчек поисковой выдачи. Проблема выявилась при переключении настроек поиска с умеренного фильтра на фильтр без ограничений.

Это значит, что страница перешла из основного индекса в специальный “Фильтр для взрослых” или «Adult-фильтр». После обращения в службу поддержки Яндекса обнаружилось, что это ошибка на стороне поисковой системы, так как на странице не было какой-либо специфичной информации».

Также возможен редкий случай неиндексации — «плохая история» домена. В этом случае был куплен домен, на котором ранее был поисковый спам или adult-ресурс, поэтому сайт сразу может быть под фильтром.

«В нашей практике был пример сайта на домене, на котором ранее был размещен белый каталог сайтов. Ресурс индексировался нормально и потом резко пропадал из индекса поисковых систем. Помогли письма в техподдержку Яндекса и отправка страниц на принудительную переиндексацию. Но даже после этого периодически сайт продолжал полностью вылетать из индекса, за этим приходилось отдельно следить. Чтобы таких моментов не было, перед покупкой домена лучше всего проверять его историю» — Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс.

Заключение

Без индексации пользователи не увидят ваш сайт даже при прямом поисковом запросе. Поэтому индексация — обязательный процесс для ресурсов, которым важен органический трафик.

Во время индексации роботы сканируют и обрабатывают информацию на страницах, заносят ее в специальную базу данных — поисковый индекс. Можно легко проверить, есть ли ваши страницы в поисковой выдаче, например, в Google. Самый надежный способ — использование сервисов для веб-мастеров: Яндекс.Вебмастер и Google Search Console.

Часто сайты, которые должны быть проиндексированы, все равно не попадают в поиск. В таком случае нужно проанализировать возможные технические и контентные причины. В редких случаях работы могут убрать ресурс из выдачи из-за ошибки на стороне поисковой системы или плохой истории домена.