что такое биннинг пикселей

Бинаризация изображений: алгоритм Брэдли

Этот пост я хочу посвятить приятному трофею, добытому в англоязычном интернете. Речь пойдет об одном из методов адаптивной бинаризации изображений, методе Брэдли (или Брэдли-Рота, поскольку авторов двое).

Немного теории

Процесс бинаризации – это перевод цветного (или в градациях серого) изображения в двухцветное черно-белое. Главным параметром такого преобразования является порог t – значение, с которым сравнивается яркость каждого пикселя. По результатам сравнения, пикселю присваивается значение 0 или 1. Существуют различные методы бинаризации, которые можно условно разделить на две группы – глобальные и локальные. В первом случае величина порога остается неизменной в течение всего процесса бинаризации. Во втором изображение разбивается на области, в каждой из которых вычисляется локальный порог.

Главная цель бинаризации, это радикальное уменьшение количества информации, с которой приходится работать. Просто говоря, удачная бинаризация сильно упрощает последующую работу с изображением. С другой стороны, неудачи в процессе бинаризации могут привети к искажениям, таким, как разрывы в линиях, потеря значащих деталей, нарушение целостности объектов, появление шума и непредсказуемое искажение символов из-за неоднородностей фона. Различные методы бинаризации имеют свои слабые места: так, например, метод Оцу может приводить к утрате мелких деталей и „слипанию“ близлежащих символов, а метод Ниблэка грешит появлением ложных объектов в случае неоднородностей фона с низкой контрастностью. Отсюда следует, что каждый метод должен быть применен в своей области.

Объект тестирования

На данный момент я занимаюсь распознаванием показаний бытовых приборов в рамках популярной идеи „умного дома“. Вот пример изображения, с которыми работает наша группа:

Фотография была сделана темной-темной ночью в темной-темной комнате; светодиодная подсветка сбоку создает сильно неоднородный фон, а между камерой и табло прибора находится силикатное стекло, которое порождает дополнительный шум и ложные образования в области фона. Наша задача – подготовка изображения к распознаванию текста.

Здесь логично использовать локальные методы, они же адаптивные. Наиболее быстрым из классических локальных алгоритмов считается метод Ниблэка, но он плохо работает с низкоконтрастными неровностями фона, которые в нашем случае заполняют изображение чуть меньше, чем полностью. Чтобы исправить этот недостаток, умные люди разработали несколько модификаций метода Ниблэка, называемых „ниблэковскими“. В моем случае один из них, метод Кристиана, показывал хорошие результаты на большинстве образцов, и чуть не был принят в качестве рабочего варианта. Однако на других образцах после применения этого алгоритма появлялись искажения.

а) метод Ниблэка б) метод Кристиана

Суть метода Брэдли

Само по себе сравнение двух величин – порога и яркости пикселя, — является элементарной задачей. Не в этом соль. Трудность заключается в нахождении порогового значения, которое должно максимально надежно отделять символы не только от фона, но и от шума, теней, бликов и прочего информационного мусора. Часто для этого прибегают к методам математической статистики. В методе Брэдли мы заходим с другой стороны – со стороны интегральных изображений.

Интегральные изображения

Интегральные изображения – это не только эффективный и быстрый (всего за один проход по изображению) способ найти сумму значений пикселей, но и простой способ найти среднее значение яркости в пределах заданного участка изображения.

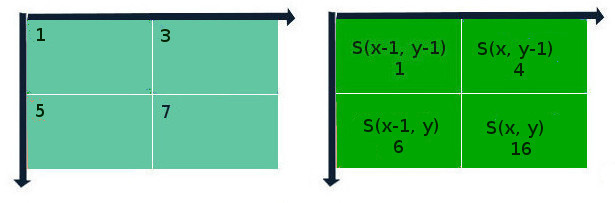

Как это работает? Да элементарно. Допустим, у нас есть 8-битное изображение в оттенках серого (цветное изображение можно перевести в оттенки серого, пользуясь формулой I = 0.2125R + 0.7154G + 0.0721B). В таком случае, значение элемента интегрального изображения рассчитывается по формуле:

S(x, y) = I(x, y) + S(x-1, y) + S(x, y-1) – S(x-1, y-1);

где S – результат предыдущих итераций для данной позиции пикселя, I – яркость пикселя исходного изображения. Если координаты выходят за пределы изображения, они считаются нулевыми. Сущность этого метода „на пальцах“ представлена на схеме ниже:

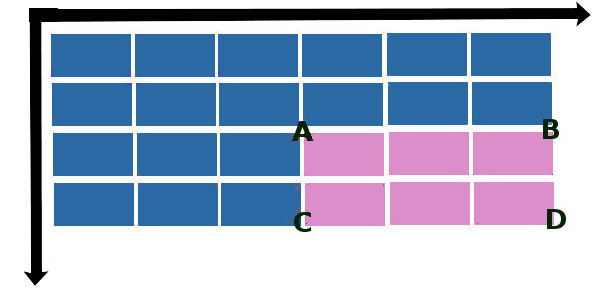

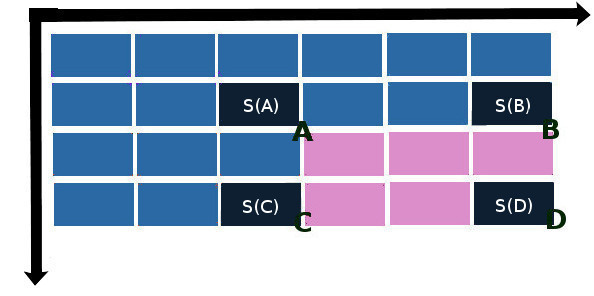

Лайфхак состоит в том, что, один раз составив интегральную матрицу изображения, можно быстро вычислять сумму значений пикселей любой прямоугольной области в пределах этого изображения. Пусть ABCD – интересующая нас прямоугольная область.

Тогда суммарная яркость S в этой области вычисляется по формуле:

S(x, y) = S(A) + S(D) – S(B) – S©

где S(A), S(B), S© и S(D) – значения элементов интегральной матрицы в направлении на „северо-запад“ от пересечений сторон прямоугольника:

Реализация

Если вы дочитали до этого места, то вы почти разобрались в алгоритме Брэдли. Дальше все просто. Разбиваем изображение на несколько областей со стороной d, берем среднее от суммы значений пикселей Im в этой области, добавляем некоторую величину t, сравниваем значение каждого пикселя с получившимся результатом. Im+t – и есть наша искомая пороговая величина. Брэдли и Рот берут значения d и t соответственно 1/8 от ширины изображения и 15% от среднего значения яркости пикселей по области. Ну а вообще говоря, оба этих параметра могут и должны изменяться в соответствии с конкретной ситуацией. Так, если размеры объекта будут больше площади квадрата со стороной, равной d, то центр этого объекта может быть принят алгоритмом как фон, и проблема решается уменьшением значения d, однако при этом могут быть потеряны мелкие детали изображения.

И вот как это выглядит на нашем примере:

После медианной фильтрации:

Реализация алгоритма Брэдли-Рота на С++ представлена ниже:

Достоинства и недостатки

Достоинствами метода Брэдли-Рота являются простота реализации и высокая скорость выполнения; для большинства случаев нет нужды подбирать параметры. Метод хорошо работает с неоднородным фоном.

Из последнего достоинства логически вытекает недостаток метода Брэдли, а именно, плохая чувствительность к низкоконтрастным деталям изображения:

а) оригинальное изображение б) метод Брэдли в) метод Кристиана

Что такое биннинг? В погоне за лучшими чипами

Вот вы принесли с магазина новенький процессор или видеокарту и подключили к своему компьютеру. Работает, вроде бы, отлично, и вы решаете его немного разогнать. Гигагерцы ползут выше и выше, и у вас появляется чувство, будто вы обладаете уникальным магическим кристаллом. А это точно не было так задумано?

Вам не терпится поделиться в интернете своей радостью от выигрыша в силиконовой лотерее, но через пару комментов вам говорят, что вам достался отбинованный чип (binned chip).

Если после этих слов вы представили инженера, который роется в мусорном ведре (bin – “корзина”) и гордо достаёт оттуда ваш супер-чип, тогда вам тем более стоит прочитать эту статью! Добро пожаловать в загадочный мир изготовления процессоров и чип-биннинга.

От пластины до кристалла

Все микросхемы делаются на дисках сверхчистого кремния, покрытого слоями металлизации, изоляции и полупроводниковых компонентов – будь то обычный CPU, какой-то особенный GPU, или DRAM системной памяти, – не важно. Весь производственный процесс очень сложен, а стоимость оборудования, с помощью которого в гигантских объёмах производятся новейшие чипы, исчисляется миллиардами долларов.

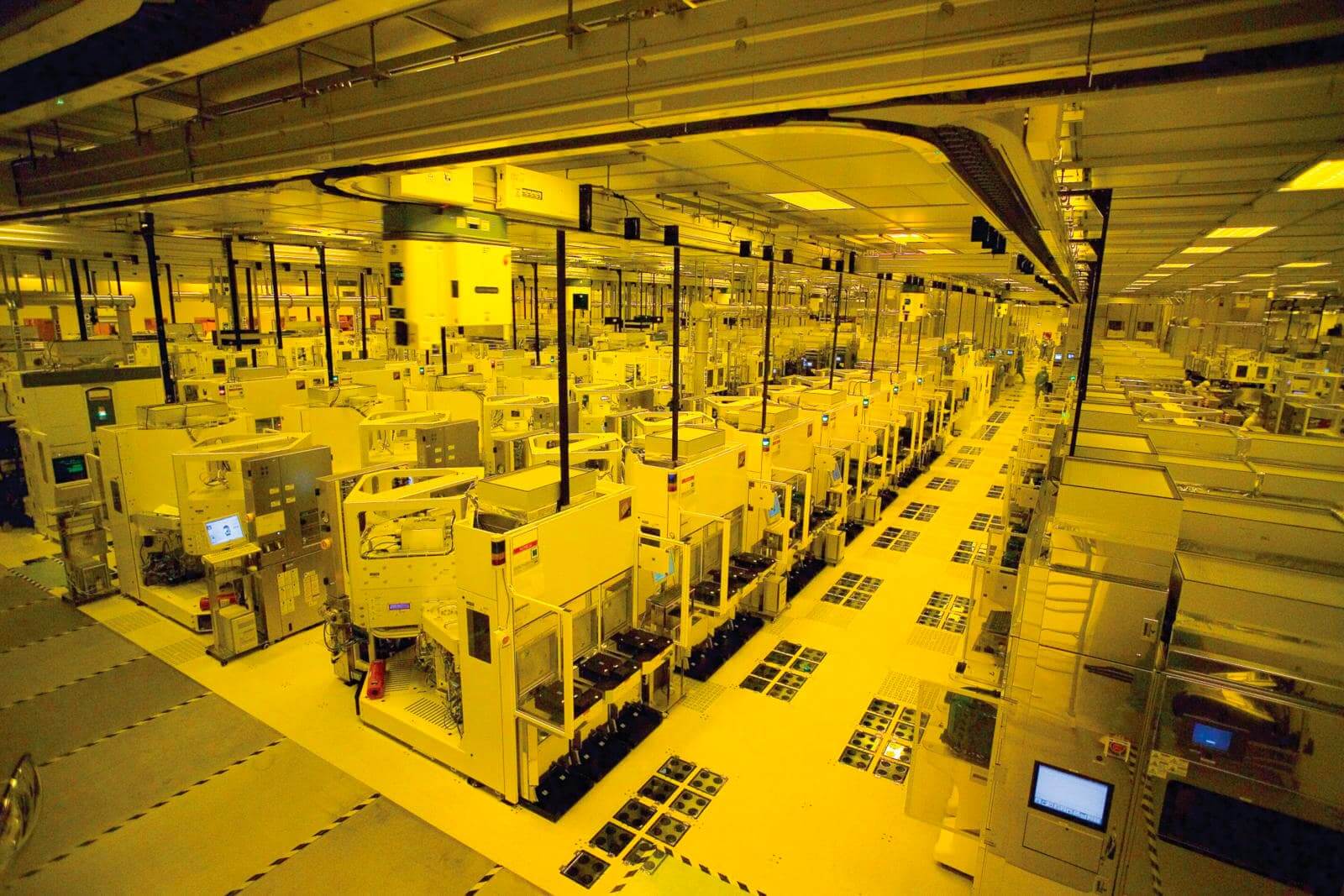

На современном заводе по производству чипов. Источник: TSMC

Эти диски называются полупроводниковыми пластинами (англ. wafer – “вафля”), и такие компании как Intel, GlobalFoundries и TSMC производят их миллионами ежегодно. Для обеспечения соответствия конечного продукта чрезвычайно требовательным к точности расчетам инженеров-микроэлектронщиков, необходимы инструменты и оборудование высочайшего качества.

Чтобы получить максимально безупречный продукт, производственные площади заводов находятся под небольшим давлением, чтобы не допустить попадания внутрь помещений бактерий и частиц пыли. Сотрудники носят защитные костюмы с той целью, чтобы не допустить попадания микроскопических частиц их кожи и волос в оборудование.

Возможно, это самый стерильный завод в мире. Источник: Intel

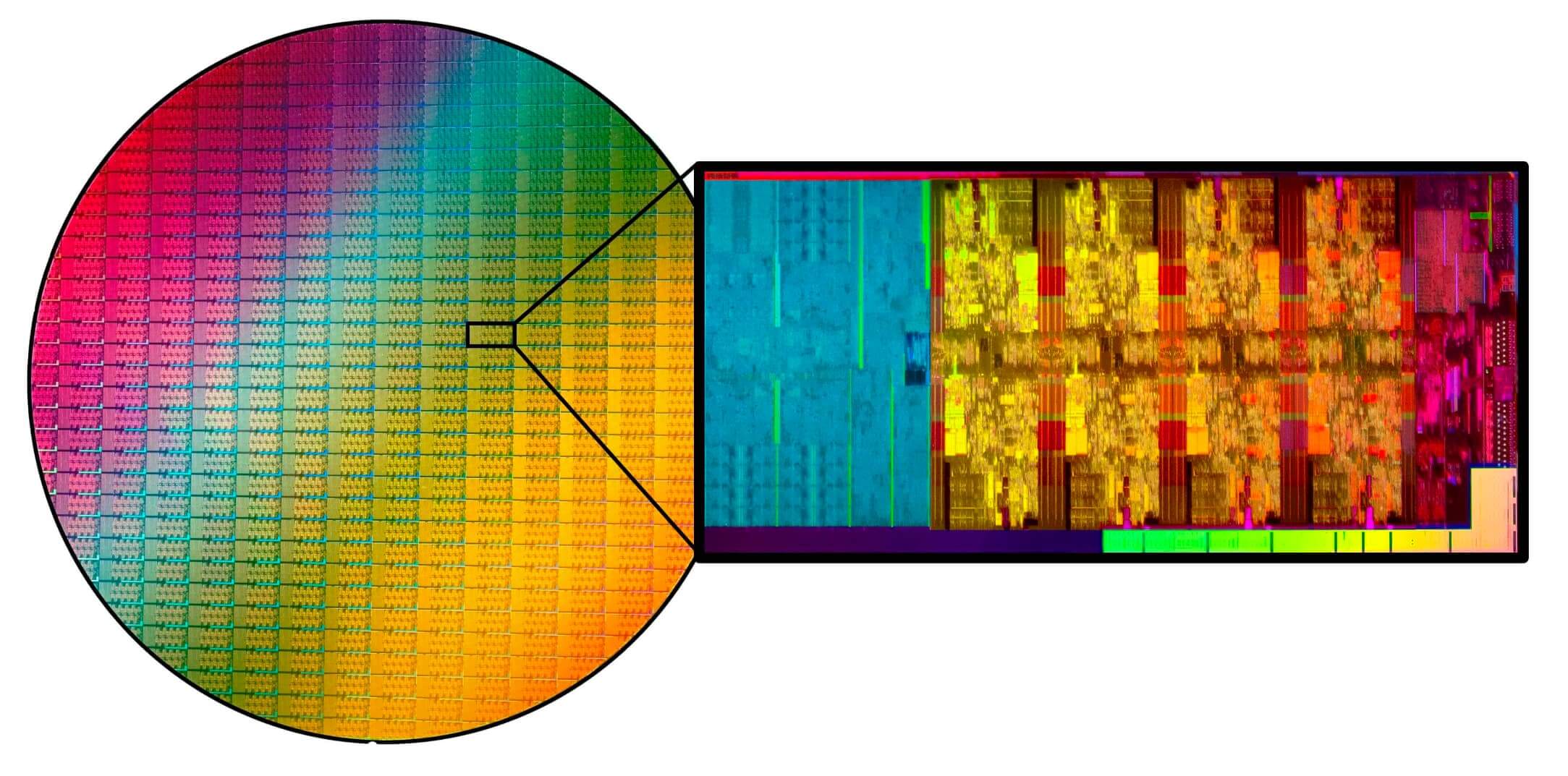

Готовая пластина – вещь красивая, и невероятно ценная. Каждая из них стоит тысячи долларов на изготовление, а весь процесс её создания – от начала до конца, от куска кремния до готового изделия – занимает месяцы. Каждый чип (на данной стадии он более известен как кристалл), который можно вырезать с пластины и продать, критически важен для покрытия затрат на их изготовление.

11.8-дюймовая (300 мм) «вафля» с множеством кристаллов процессоров Intel Core i9.

Для нарезки на отдельные кристаллы используется алмазный рез, при этом известная доля кусочков сразу идёт в отходы, поскольку находясь по краю круглой пластины, они попросту не могут быть полными прямоугольными кристаллами. В такие отходы попадёт от 5 до 25% всей пластины (процент зависит от размеров кристалла).

Оставшиеся монтируются на печатные платы, упаковываются в корпус, и при необходимости – снабжаются теплоотводом, чтобы в конечном итоге стать тем процессором, с которым мы все знакомы.

(Не)равенство ядер

Давайте взглянем на новейший процессор Intel в их семействе моделей Core, наиболее мощным из которых является Core i9-10900K, имеющий 10 ядер и встроенный GPU.

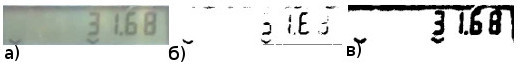

На фото мы видим то, что привыкли видеть, глядя на процессор. Но если отковырять теплораспределительную крышку и с помощью специальных инструментов докопаться до внутренностей, мы увидим совсем другую картину.

Нам откроется целый мегаполис с районами логических блоков, кварталами памяти SRAM, аэропортами интерфейсов и автострадами коммуникационных шин – в каждом чипе содержатся миллиарды отдельных электронных компонентов, работающих в синхронизированной гармонии.

На этой макрофотографии отмечены некоторые ключевые области. Слева находится система ввода-вывода (I/O system), включая контроллеры памяти DDR4-SDRAM, PCI Express и дисплея. А также там имеется система, обеспечивающая циркулярную связь ядер. Над системой ввода-вывода находится интерфейс системной памяти (DRAM interface), а с другой стороны кристалла мы видим встроенный графический чип, GPU. Эти три области присутствуют в любом процессоре Intel Core.

В середине расположены ядра процессора. Каждый из них является точной копией другого, и состоит из вычислительных модулей, модулей перемещения данных и прогнозирования будущих инструкций. По обе стороны от каждого ядра простираются две полосы L3 cache – кэша 3 уровня (другие уровни кэша находятся глубоко в ядре), каждая из которых обеспечивает 1 Мб сверхбыстрой памяти.

Вы думаете, Intel для каждой модели процессора будет производить отдельную пластину? Но фишка в том, что с одной общей пластины «i9-10900» может получиться любая из приведенных моделей:

Модель Кол-во ядер Кол-во потоков Базовая частота All Core Turbo Turbo Boost Объём L3 Cache PL1 TDP

| Модель | Кол-во ядер | Кол-во потоков | Базовая частота | All Core Turbo | Turbo Boost | Объём L3 Cache | PL1 TDP |

| i9-10900K | 10 | 20 | 3.7 | 4.8 | 5.1 | 20 | 125 |

| i9-10900KF | 10 | 20 | 3.7 | 4.8 | 5.1 | 20 | 125 |

| i9-10900 | 10 | 20 | 2.8 | 4.5 | 5.0 | 20 | 65 |

| i9-10900F | 10 | 20 | 2.8 | 4.5 | 5.0 | 20 | 65 |

| i9-10900T | 10 | 20 | 1.9 | 3.7 | 4.5 | 20 | 35 |

| i7-10700K | 8 | 16 | 3.8 | 4.7 | 5.0 | 16 | 125 |

| i7-10700KF | 8 | 16 | 3.8 | 4.7 | 5.0 | 16 | 125 |

| i7-10700 | 8 | 16 | 2.9 | 4.6 | 7.7 | 16 | 65 |

| i7-10700F | 8 | 16 | 2.9 | 4.6 | 4.7 | 16 | 65 |

| i7-10700T | 8 | 16 | 2.0 | 3.7 | 4.4 | 16 | 35 |

| i5-10600K | 6 | 12 | 4.1 | 4.5 | 4.8 | 12 | 125 |

| i5-10600K | 6 | 12 | 4.1 | 4.5 | 4.8 | 12 | 125 |

| i5-10600 | 6 | 12 | 3.3 | 4.4 | 4.8 | 12 | 65 |

| i5-10600T | 6 | 12 | 2.4 | 3.7 | 4.0 | 12 | 35 |

| i5-10500 | 6 | 12 | 3.1 | 4.2 | 4.5 | 12 | 65 |

| i5-10500T | 6 | 12 | 2.3 | 3.5 | 3.8 | 12 | 35 |

| i5-10400 | 6 | 12 | 2.9 | 4.0 | 4.3 | 12 | 65 |

| i5-10400F | 6 | 12 | 2.9 | 4.0 | 4.3 | 12 | 65 |

| i5-10400T | 6 | 12 | 2.0 | 3.2 | 3.6 | 12 | 35 |

«Базовая частота», измеряемая в ГГц, это минимально-гарантированная тактовая частота, на которой будет работать процессор, независимо от нагрузки. «All Core Turbo» – это максимальная частота, на которой все ядра могут работать вместе, но не обязательно длительное время. «Turbo Boost» – то же самое, но речь только о 2 ядрах, работающих одновременно.

PL1 TDP расшифровывается как Power Level 1 Thermal Design Power – “Теплопакет на 1-м уровне мощности”. Это количество тепла, которое процессор будет выделять при работе на своих базовых частотах под любой нагрузкой. Он может и намного больше тепловой мощности произвести, но это замедлит работу процессора, а разработчики материнских плат, в целях предотвращения перегрева CPU, могут ограничить потребляемую чипом мощность.

Модели с буквой F на конце имеют отключенный GPU. А если в конце стоит буква K, то это значит, что процессор не заблокирован по частотам, и вы легко сможете разогнать его. Ну а T указывает на пониженное энергопотребление. Это лишь что касается рядовых моделей для настольных компьютеров, а ведь иные в итоге становятся процессорами Xeon, предназначенными для профессионального рынка, на которых функционируют рабочие станции или небольшие сервера.

Итак, все эти 19 разных моделей являются одним и тем же процессором. Как и почему так происходит?

Мир несовершенен

Какими бы потрясающими ни были заводы по производству чипов, но ни они, ни технологии и используемые материалы не совершенны на все 100%. Всегда будет несколько нано-изъянов – в оборудовании ли, или в глубинах кремния и используемых металлов. Как бы производители ни старались, но они не могут достичь абсолютной безупречности.

И когда вы пытаетесь создавать компоненты, которые настолько малы, что только мощные электронные микроскопы позволяют вам их разглядеть, ничто не ведет себя там так, как в обычном мире. В нанометровом мире гораздо явственней проявляет себя квантовая реальность, а случайности, шумы и прочее делают все возможное, чтобы помешать вам создать момент идеальности. Все эти проблемы стоят на пути производителей процессоров, и конечные результаты их воздействия классифицируются как дефекты.

Дефекты не всегда бывают существенными – иногда они могут просто привести к тому, что определенная часть чипа будет сильнее греться. Но если случай тяжёлый, то целый сектор может оказаться нефункциональным. Первое, что делают производители, это сканируют и тестируют пластины на дефекты.

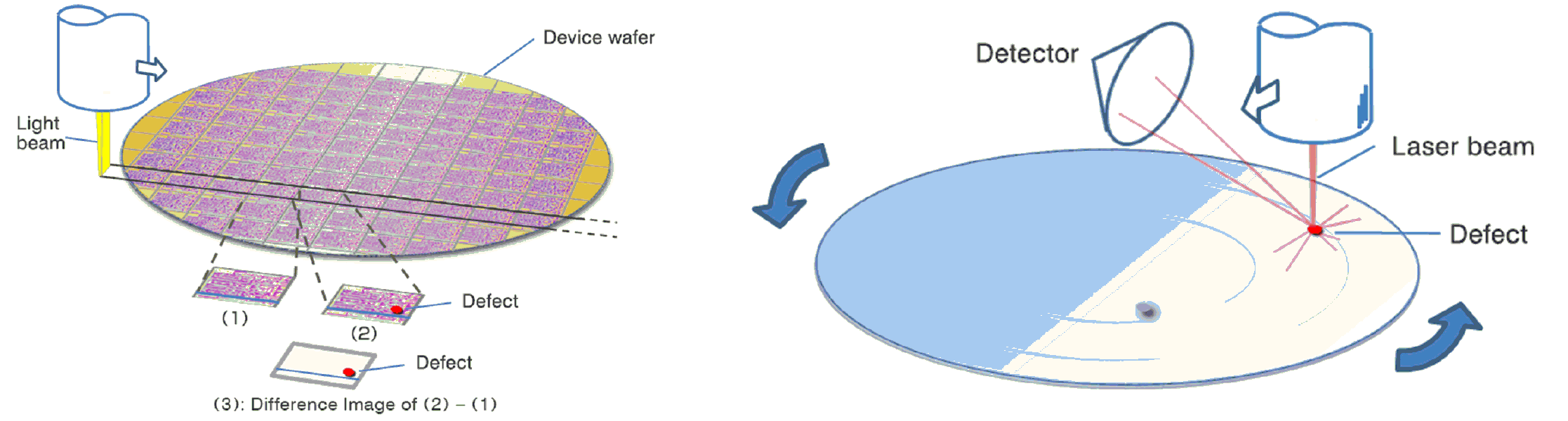

Поиск дефектов с помощью прямого сравнения отпечатков (слева) и с помощью лазерно-отражающего метода (справа). Источник: Hitachi

Дефектоскопическое оборудование используется после изготовления пластины, но до её нарезки на кристаллы. Кристаллы (или пластины целиком), где обнаруживаются проблемы, помечаются для дальнейшего анализа.

Но даже эти шаги не обеспечивают полного детектирования мельчайших недочётов, поэтому после нарезки и сборки, готовые процессоры подвергаются ещё более пристальному тестированию.

Не все корзины – мусорные

Когда специалисты той же Intel садятся за проверку качества своих процессоров, они настраивают чипы для работы с установленным напряжением и с определенной тактовой частотой. В ходе различных стресс-тестов всех областей кристалла, тщательно замеряется количество потребляемой электроэнергии и выделяемого тепла.

В ходе этого специалисты обнаруживают, что одни чипы работают именно так, как требуется, а другие – лучше или хуже.

Для стабильной работы каких-то чипов может понадобиться повышенное напряжение, в то время как другие могут греться сильнее обычного. Ну и очевидно, некоторые вообще не смогут удовлетворительно пройти эти испытания.

Подготовка процессоров к финальному тестированию и проверке. Источник: Intel

Аналогичные исследования выполняются для процессоров с уже помеченными дефектами, только предварительно устанавливается, какие разделы чипа работают полноценно, а какие нет.

В конечном итоге, весь т.н. полезный выход продукции с пластины образует диапазон кристаллов, отличающихся друг от друга по своим функциональным потенциалам, стабильным частотам, вольтажу и тепловыделению. Как назвали эту процедуру сортировки чипов «по разным корзинкам», bin’ам? Чип-биннинг.

Никаких таких больших пластиковых корзин, куда специалисты с умным видом кидают процессоры, на самом деле, конечно, нет. Термин взят из статистики, где некий разброс значений может быть собран в группы, которые и называются bin’ами. К примеру, возрастные группы в каком-то демографическом анализе: от 0 до 5 лет, от 6 до 10, от 11 до 16 и т.д. Это и есть bin’ы.

То же самое и у нас. В нашем примере с i9-10900, у нас будет несколько бинов – по числу функциональных ядер, стабильному диапазону частот, нагреву, и т.д.

Предположим, мы имеем чип Core i9-10900, который был тщательно протестирован, и в нём обнаружилась пара серьезных дефектов, как показано выше. Два ядра и графический процессор оказались повреждены так, что просто не могут функционировать должным образом.

Что делает Intel? Он отключает убитые разделы и определяет данный чип как семиядерный без GPU, то есть теперь это Core i7-10700F. Но необходимо ещё проверить на тактовую частоту, мощность и стабильность. Если чип пройдёт эти испытания, то останется как i7, но если и их «завалит», то ему отключат ещё пару ядер и «понизят» до Core i5.

Учитывая все вышесказанное, чип-биннинг значительно повышает полезный выход пластин, потому что это означает, что больше работоспособных кристаллов можно реализовать.

В случае с процессорами Core 10-го поколения, на своих пластинах, помимо i9, вытравливаются Core i5, i3 и Pentium/Celeron. Последние в идеале имеют 6 ядер, и после проверки отбиновываются вплоть до 2-ядерных продуктов.

Часто спрос на продукцию превышает производственные возможности, поэтому неполноценные процессоры не выбрасываются, а предлагаются как более дешёвые модели, что помогает удовлетворять спрос на них. Порой у идеально работающего чипа отключают некоторые опции только лишь для того, чтобы восполнить нехватку дешёвых моделей за счёт избытка дорогих при выполнении заказов по отгрузке продукции с завода. Вот почему говорят о кремниевой лотерее, когда вы под видом дешёвого чипа можете получить на самом деле топовый чип.

Учитывая все вышесказанное, чип-биннинг значительно повышает полезный выход пластин, потому что это означает, что больше работоспособных кристаллов можно реализовать. Без него самые настоящие мусорные корзины в Intel были бы переполнены кремниевым ломом.

Отбинованные процессоры – уникальные?

Как и многие другие термины в вычислительной технике, значение термина «чип-биннинг» порой используется в несколько искажённом смысле. Интернет-магазины иногда продают специально отобранные штучные процессоры (которые, например, умеют разгоняться до безумных уровней или аномально-слабо греются) как «binned CPU». В реальности же все чипы отбинованные, поскольку все они проходят эту самую процедуру биновки.

Конечно, ничто не мешает розничному продавцу тоже отсортировать закупленную партию чипов. Дважды-отбинованные CPU, так сказать.

Магазины закупают процессоры AMD и Intel оптом (в контейнерах, содержащих десятки, если не сотни чипов), и какой-то сотрудник магазина может сесть за тестовый компьютер и протестировать каждый камень в партии – разогнать или понизить напряжение, зафиксировать температурные показатели, и т.д. Наилучшие образцы из партии могут быть предложены покупателю как уникальные, отборные, и ритейлер абсолютно вправе классифицировать их как «бинованные». Естественно, все эти затраченные на тесты усилия и время отразятся на конечной розничной цене продукта.

Так являются ли эти так называемые отбинованные чипы чем-то таким особенным? И да, и нет. Любой чип, используемый в вашем ПК, телефоне, автомобиле и т.д. так или иначе проходит какую-то сортировку. Это просто один из производственных этапов любых микросхем. Ваш любимый процессор или GPU, который удивляет какими-то выдающимися возможностями, вырезан вместе с другими кристаллами с одной общей кремниевой пластины, сотни тысяч которых производят заводы по всему миру.

Что такое пиксельное биннинг и как оно может помочь моей фотографии на смартфоне?

Хотя это далеко не новая технология, вы, возможно, слышали, что термин «пиксельное объединение» появляется все чаще и чаще в отношении ряда недавно анонсированных смартфонов, таких как Samsung Galaxy S20 Ultra, и поинтересовались, что это означает. Вы можете быть особенно обеспокоены тем, что это означает для качества изображений вашего смартфона.

Во-первых, нам, вероятно, нужно быстрое напоминание о том, что именно представляет собой пиксель. Проще говоря, пиксель, который является сокращением от «элемента изображения», является наименьшей единицей цифрового изображения, часто рассматриваемой как маленькие точки, которые видны, когда вы внимательно смотрите на экран..

Слово «пиксель» также часто используется для описания отдельных полостей захвата света, обнаруженных на датчиках камеры, хотя технически они называются «фотосайтами». Однако, ради простоты в этом объяснителе «пиксельного биннинга», мы будем использовать «пиксель», чтобы описать их тоже.

Чем больше пикселей сенсора (или фотосайтов), тем больше их способность собирать свет. Но вам также нужно много пикселей, если вы хотите визуализировать детали. Также стоит сказать, что не все пиксели созданы одинаково — размер фотосайта называется его «шагом пикселя», и измеряется в микронах. Чем больше число, тем оно больше.

Пиксели камеры смартфона имеют тенденцию варьироваться от довольно маленьких (0,8 микрона) до довольно больших (1,8 микрона). Но они все еще бледны по сравнению с тем, что можно найти на беззеркальной камере или зеркальной камере. Пиксели, найденные в датчиках полнокадровых камер, могут достигать 8,4 микрон, поэтому они, как правило, намного лучше для съемки при слабом освещении, чем смартфон, особенно когда вы внимательно изучаете изображение.

Google Pixel 4 (Изображение предоставлено в будущем).

Проблема, с которой сталкиваются смартфоны, заключается в том, что физический размер их сенсора обязательно мал, поскольку его необходимо размещать в относительно небольшом устройстве. За прошедшие годы размеры сенсоров внутри смартфонов несколько увеличились, но вы никогда не собираетесь втиснуть сенсор размером с DSLR в тонкий смартфон.

Это означает, что у вас есть проблема с попыткой втиснуть множество пикселей в небольшую область. Маленькие пиксели — плохая новость для съемки при слабом освещении, но, в равной степени, уменьшение количества пикселей означает, что вы не получите эти прекрасные четкие изображения при хорошем освещении. Есть несколько способов обойти это с аппаратной точки зрения, но у всех есть свои компромиссы.

Вы можете уменьшить количество пикселей на датчике, чтобы обеспечить максимальный размер каждого пикселя. Но тогда вы получите изображения с довольно низким разрешением. Вы можете увеличить количество пикселей, но также увеличить размер сенсора. Это невозможно физически, не делая смартфоны еще больше или шире.

Хотя некоторые современные смартфоны довольно массивны, если они тоже станут толще, то вряд ли они будут столь популярны. Наконец, вы можете использовать большое количество пикселей на небольшом датчике, надеясь, что большинство пользователей будут снимать в основном при хорошем освещении..

В качестве альтернативы, компромисс, который пытается получить лучшее из всех миров, — это процесс, известный как биннинг пикселей. Но как это работает?

Что такое пиксельный биннинг?

Снимки Xiaomi Mi Note 10 с разрешением 108 Мпикс снимаются до 27 Мп. (Изображение предоставлено: Будущее)

Если вы выберете тему Google, вы найдете множество и разнообразных (и чрезмерно сложных) описаний того, как именно работает пиксельное биннинг, а также множество обсуждений о преимуществах или иных последствиях..

Простое или прямое объяснение состоит в том, что данные по меньшей мере из четырех пикселей объединяются в один. Это создает эффект «суперпикселей», которые лучше способны собирать и обрабатывать свет в сцене. Недостатком является то, что ваше эффективное разрешение будет разделено на четверти при выводе снимка — поэтому, если у вас был 12-мегапиксельный сенсор с использованием пиксельного биннинга, у вас остался бы 3-мегапиксельный снимок.

Вот почему в последнее время на рынке появилось несколько сенсоров с высоким разрешением — 48-мегапиксельный сенсор, использующий пиксельное биннинг, даст вам гораздо более удобный 12-мегапиксельный финальный снимок.

Вы можете подумать — и никто не будет винить вас — зачем беспокоиться о пиксельном биннинге 48 мегапикселей, почему бы не использовать более крупные пиксели для датчика 12 Мп, если большие пиксели лучше? Ну, здесь есть два ответа. Первый, по сути, сводится к маркетингу и, прежде всего, к покупке телефона. Человеческая натура диктует, что вы будете более впечатлены датчиком 48MP, чем датчиком 12MP, даже если результаты будут лучше при меньшем разрешении.

Но есть также кое-что, что можно сказать, чтобы дать вам возможность снимать на 48MP и использовать все эти дополнительные детали, когда позволяет более яркий свет — в конце концов, вероятно, многие из нас делают много снимков в наружных сценариях (например, как пока в отпуске).

Является ли Pixel Binning единственным решением?

IPhone 11 Pro Max имеет особенно хороший ночной режим. (Изображение предоставлено: Будущее)

Pixel binning используется не каждым производителем. Например, Apple и Google используют относительно «скромные» 12-мегапиксельные датчики в своих устройствах, склоняясь к вычислительной фотографии для повышения производительности при слабом освещении. Наличие большого количества деталей также, возможно, совершенно не нужно, если единственное место, где вы когда-либо будете смотреть на свои изображения, находится на экране телефона..

Существуют также способы решения проблемы слабой освещенности, связанные с использованием камеры смартфона и ее программного обеспечения, а не с аппаратным решением, которое обеспечивает пиксельное объединение. В некоторых телефонах есть «Ночные режимы», которые снимают серию коротких экспозиций и объединяют их вместе, создавая впечатление, что они дают больше света. Вы также можете использовать реальные длинные экспозиции, если у вас есть штатив или устойчивая поверхность под рукой..

Итак, каков вывод здесь — это пиксельный биннинг только маркетинговый трюк, призванный заставить нас инвестировать в новые блестящие телефоны, которые обещают улучшить нашу фотографию?

К сожалению, как это часто бывает с этими вещами, ответ на этот вопрос немного и тот, и другой. Pixel binning — это хорошее решение, если вы хотите предлагать наилучшую детализацию при хороших условиях освещения, а также создавать качественные снимки при слабом освещении. Это хороший компромисс, который позволяет вашему смартфону использовать различные условия съемки, в которых вы можете оказаться.

Тем не менее, смартфоны с датчиками низкого разрешения не будут автоматически откладываться, поскольку они также могут создавать превосходные изображения с использованием различных методов, таких как искусственный интеллект или программные настройки..