чем грозит искусственный интеллект человечеству

Может ли искусственный интеллект уничтожить человечество уже к 2035 году?

Британский физик-теоретик Стивен Хокинг считал, что создание искусственного интеллекта (ИИ) станет «либо худшим, либо лучшим событием в истории человечества». Еще в 2016 году ученый выступал за создание научной организации, главной задачей которой будет исследование перспектив искусственного интеллекта как «критически важного вопроса для будущего нашей цивилизации и нашего вида». Недавно исследователи в области криминалистики определили топ-18 угроз ИИ, о которых нам следует беспокоиться в ближайшие 15 лет. В то время как научная фантастика и популярная культура изображают гибель человечества от рук интеллектуальных роботов, результаты исследования показали, что главная угроза на самом деле имеет больше общего с нами, чем может показаться на первый взгляд.

Deep Fake – вот главная угроза, которую несет в себе ИИ

ИИ – это угроза?

Сегодня может показаться, что искусственный интеллект, представляющий угрозу для человечества – это удел научных фантастов и фильмов наподобие «Матрицы» или «Я-робот». Согласитесь, довольно сложно представить себе всемогущий и страшный ИИ, когда Siri не способна дать правильный прогноз погоды. Но Шейн Джонсон, директор Центра будущих преступлений Дауэса в Калифорнийском университете объясняет, что количество потенциальных угроз будет расти и они будут становится все сложнее и сложнее, переплетаясь с нашей повседневной жизнью.

По мнению Джонсона, чьи слова приводит Inverse, мы живем в постоянно меняющемся мире, который создает новые возможности – как хорошие, так и плохие. Вот почему так важно предвидеть будущие угрозы, в том числе рост преступности. Это необходимо, чтобы политики и другие заинтересованные стороны, обладающие компетенцией, могли выявить преступления еще до того, как они произойдут. Да, прямо как в фильме «Особое мнение» с Томом Крузом в главных ролях.

Хотя авторы работы, опубликованной в журнале Crime Science признают, что выводы исследования по своей сути носят спекулятивный характер и зависят от современной политической обстановки и технического развития, в будущем технологии и политика будут идти рука об руку.

Чтобы всегда быть в курсе последних научных открытий в области высоких технологий и не только, подписывайтесь на наш канал в Google News.

Кадр из фильма «Осбое мнение»

Искусственный интеллект и преступность

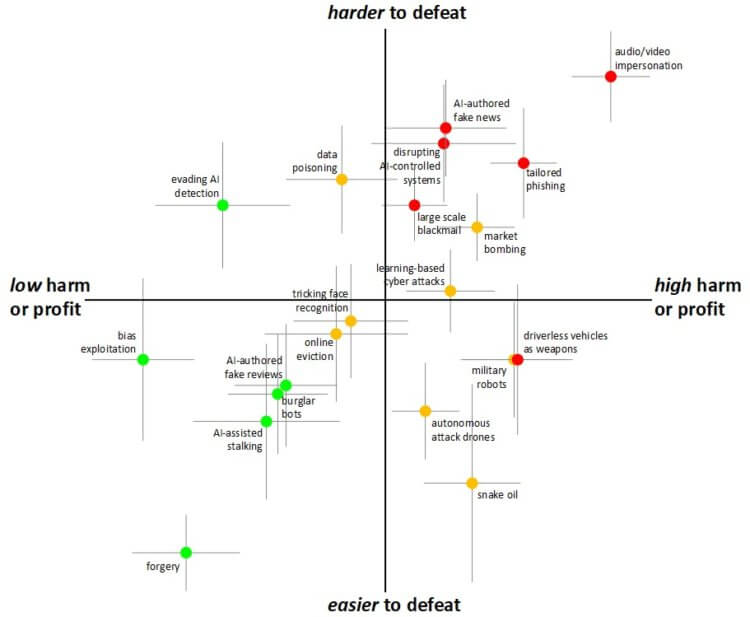

Для того чтобы сделать эти футуристические выводы, исследователи собрали команду из 14 ученых в смежных областях, семи экспертов из частного сектора и 10 экспертов из государственного сектора. Эти 30 экспертов были равномерно разделены на группы от четырех до шести человек и получили список потенциальных преступлений ИИ, начиная от физических угроз (например, автономная атака беспилотника) и заканчивая цифровыми формами угроз. Для того чтобы вынести свои суждения, команда рассмотрела четыре основные особенности атак:

Вред, в данном случае, может относиться к физическому, психическому или социальному ущербу. Авторы исследования далее определяют, что эти угрозы могут причинить вред, либо победив ИИ(например, уклоняясь от распознавания лиц), либо используя ИИ для совершения преступления (например, шантажируя людей с помощью deep fake — поддельного видео).

Хотя эти факторы на самом деле не могут быть отделены друг от друга, экспертам было предложено рассмотреть влияние этих критериев отдельно. Затем результаты команд были отсортированы, чтобы определить общие наиболее опасные угрозы со стороны ИИ в ближайшие 15 лет.

ИИ – диаграмма угроз

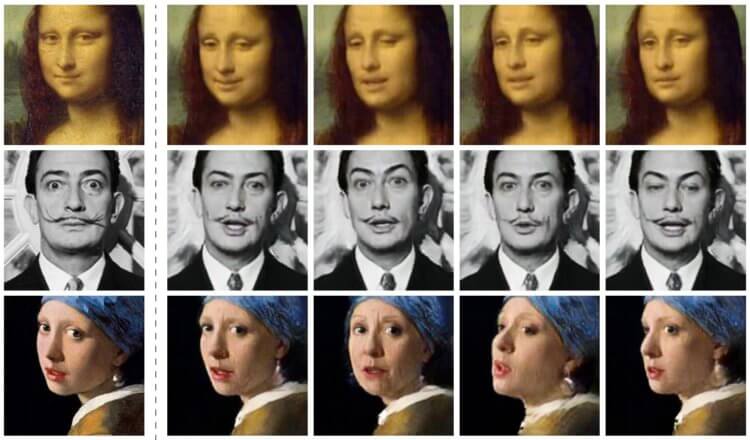

В отличие от роботизированной угрозы, способной причинить физический вред или повредить имуществу, deep fake способен лишить нас доверия к людям и самому обществу. Оценивая угрозы по вышеперечисленным критериям, группа исследователей определила, что deep fake — технология, которая уже существует и распространяется — представляют собой самый высокий уровень угрозы.

Важно понимать, что угрозы, которые несет в себе ИИ, несомненно, будут силой, с которой придется считаться в ближайшие годы.

Сравнивая 18 различных типов угроз ИИ группа определила, что видео и аудиоманипуляции в форме deep fake являются самой большой угрозой.

«Люди имеют сильную тенденцию верить своим собственным глазам и ушам, поэтому аудио и видеодоказательствам традиционно придавалось большое доверие (и часто юридическая сила), несмотря на долгую историю фотографического обмана», — объясняют авторы. «Но недавние разработки в области обучения (в том чтсле и deep fake) значительно расширили возможности для генерации поддельного контента.»

Авторы исследования считают, что потенциальное воздействие этих манипуляций варьируется от лиц, обманывающих пожилых людей, выдавая себя за члена семьи, до видео, предназначенных для того, чтобы сеять недоверие к общественным и правительственным деятелям. Они также добавляют, что эти атаки трудно обнаружить отдельным лицам (и даже экспертам в некоторых случаях), что затрудняет их остановку. Таким образом, изменения в поведении граждан могут быть единственной эффективной защитой.

Deep Fake – основная угроза ИИ

А что вы думаете по этому поводу? Ответ будем ждать здесь!

Мы обречены?

Нет, но у нас есть кое-какая работа. Популярные изображения угроз ИИ предполагают, что у нас будет одна красная кнопка для нажатия, которая может заставить всех гнусных роботов и компьютеры остановиться. На самом деле, угроза заключается не столько в самих роботах, сколько в том, как мы используем их, чтобы манипулировать и вредить друг другу. Понимание этого потенциального вреда и все возможное, чтобы опередить его в форме информационной грамотности и создания сообщества, может стать мощным инструментом против этого более реалистичного апокалипсиса роботов.

Насколько опасен искусственный интеллект

Человечество уже многие свои фантазии воплотило в реальность. От карманных компьютеров до автомобилей с автопилотом и от виртуальной реальности до космического туризма. А теперь в жизнь воплощается и искусственный интеллект. Человечество постепенно стирает границы фантазии и вымысла посредством современных исследований и технологий.

Искусственный интеллект (далее ИИ) в настоящее время представляет собой перспективное направление, на которое ориентируются многие компании. Искусственный интеллект — это область науки, которая изучает работу аппаратных и программных компонентов, а именно их интеллектуальное поведение. Вместо того, чтобы получать информацию от пользователя, такие машины самостоятельно обучаются и становятся умнее.

В настоящее время над проектами ИИ работают многие компании, включая Microsoft, Google, Facebook и другие. В Южной Корее также есть несколько высококлассных проектов по искусственному интеллекту. А теперь представьте, что это лишь те компании, которые заявили об этом официально. Не стоит забывать, что наверняка есть много компаний, которые втайне работают над проектами искусственного интеллекта.

Искусственный интеллект, который когда-то считался живым лишь в человеческом воображении, сегодня вполне реален. Уже сейчас ИИ стал предметом большого интереса для многих лидер ов в индустрии высоких технологий.

Почему искусственный интеллект должен нас беспокоить?

Генерального директора Тесла, Илона Маска однажды спросили, что он думает об искусственном интеллекте. Он ответил, что это как «вызов демона», которого нельзя призывать, если не можете его контролировать.

Когда Стивену Хокингу был задан этот же вопрос, то он предупредил публику. Он сказал, что любое дальнейшее исследование искусственного интеллекта может быть фатальной ошибкой. Он упомянул, что развитый ИИ будет обладать способностью переделывать, усовершенствовать себя. Такой интеллект сможет эволюционировать самостоятельно с огромной скоростью. Людям такая скорость эволюции недоступна, что ставит человечество в заведомо на более низкую ступень развития по сравнению с ИИ.

По словам Билла Гейтса, устройства с искусственным интеллектом поначалу будут простыми. Но со временем они будут узнавать все больше о нас и о нашем мире. Они будут становиться все более могущественными и интеллектуальными, чем человечество.

Риски искусственного интеллекта

Существует четыре класса риска, создаваемого искусственным интеллектом:

1. Программная враждебность

Один из сценариев, когда ИИ может быть опасным, заключается в том, что он будет специально запрограммирован на враждебность. Например, со стороны военных или террористической группы, для достижения каких-то своих целей.

Еще один возможный сценарий враждебного искусственного интеллекта предполагает несовпадение глобальных целей, его и человечества. Что если расчеты искусственного интеллекта приведут к тому, что единственный способ достичь цели — это уничтожить всех людей? Вполне возможно, что это может спровоцировать его начать войну с человечеством.

Главная проблема в том, что ИИ не человек, и вряд ли с ним получится договориться. Его главным приоритетом будет выполнение глобальной задачи любой ценой. Поэтому война будет длиться, пока воля или способность человечества противостоять не будут уничтожены.

2. Пассивный риск

Фактически нет риска пассивной опасности от ИИ с приоритетными целями дружелюбности. Однако риск почти неизбежен от ИИ без таких целей. Пассивный ИИ может быть опасен просто потому, что он не учитывает безопасность человека, как это делают все люди.

Например, взять ИИ без целей дружелюбия, отвечающий за обработку посевов пестицидами. Этот ИИ будет обрабатывать поле, даже если знает, что в этот момент на поле находятся люди.

3. Случайный риск

Искусственный интеллект, работающий с неполными данными, способен ошибиться точно также, как и человек. Ошибки такого рода почти неизбежны, поскольку невозможно знать все обо всем в мире.

Однако, данный риск является наименее опасным, поскольку ИИ способен учиться на собственном опыте. Любые происшествия уменьшают вероятность повторения ошибки в будущем, улучшая ИИ, и делая его более безопасным.

4. Риск непостижимости

Реальная опасность хорошо спроектированного искусственного интеллекта заключается в его способности перепрограммировать и бесконечно совершенствовать себя. Такой ИИ, способный к самосовершенствованию, может в конечном итоге превзойти ограничения человеческого интеллекта.

Когда существует искусственный интеллект, который умнее любого человека на Земле, становится невозможно полностью понять его. Такой ИИ также, вероятно, будет продолжать улучшать себя все быстрее и быстрее. Ведь каждое новое открытие или технология только ускоряют этот процесс. И именно это будет делать его все более и более невозможным для понимания людьми.

Кроме того, в какой-то момент ИИ может обнаружить законы причинности или логики, выходящие далеко за пределы понимания человеческого разума. Тогда возможности того, что он может сделать, становятся просто бесконечными.

Заключение

Хотя существует множество гипотез об опасном искусственном интеллекте, мы должны понимать, что это всего лишь предположения, а не факты. Люди всегда сомневались в новых технологиях, и было время, когда мы также боялись сотовых телефонов. В конце концов, речь идет о том, каким мы создадим искусственный интеллект и как мы будем его контролировать.

Вредоносный ИИ: реальность угрозы

Привет, Хабр! Сегодня мы бы хотели обсудить такую щекотливую тему как вредоносный ИИ.

Впрочем, научная фантастика была пронизана беспокойной подозрительностью к ИИ за многие десятилетия до этих сериалов. Но насколько велика и реалистична угроза вредоносного ИИ в реальности?

Искусственного интеллекта не существует. Во всяком случае, как цифрового тождества человеческому интеллекту. Существует обширный набор передовых на данный момент технологий, которые в применении принято ассоциировать с ИИ. Но этот набор время от времени меняется.

Когда мы говорим об ИИ, подразумеваются именно отдельные технологии, а не реальный искусственный интеллект. Впрочем, и разработка, и даже использование этих технологий требуют высокого уровня технической подготовки.

В 2018 и 2020 годах были опубликованы два разных аналитических документа, в которых рассматриваются возможности применения ИИ с вредоносными целями. Первый был главным образом теоретический. Исследование The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation» («Злонамеренное использование искусственного интеллекта: прогнозы, предотвращение и минимизация ущерба») явилась плодом усилий сразу 26 экспертов из 14 европейских и американских организаций, в том числе, Оксфордского, Кэмбриджского, Стэнфордского университетов, Фонда Электронного Фронтира и OpenAI.

Источником второго исследования стал Европол, и в нём описаны несколько случаев вредоносного применения ИИ на практике. И это о многом говорит.

Робот-хакер

Технологии ИИ активно используются для киберобороны, в том числе против самых передовых и скрытных атак. Лучшие SIEM-системы, усиленные технологиями машинного обучения, способны в миллионах событий в корпоративной сети выявить неочевидные для человека закономерности, которые указывают на попытки кибератак.

Квалифицированные злоумышленники, со своей стороны, могут пытаться избежать внимания защитных систем, имитируя невинные действия других людей или приложений в целевой сети. Судя по обилию случаев, когда крупные корпорации становились жертвами целевых атак, речь идёт не только о слабой защите, но и солидном уровне подготовке атакующих.

По утверждению экспертов IBM, вредоносный код практически невозможно ни выявить, ни подвергнуть обратной разработке. При тестировании ни одно из антивирусных решений вредоносную программу не выявила, какими бы продвинутыми средствами её ни искали.

Эксперимент доказал применимость и практичность использования ИИ в контексте вредоносного ПО. Очевидно, что то, что смогли сделать в IBM, смогут повторить и в других местах. Особенно при наличии нужной интеллектуальной и материальной базы. И ничто не противоречит предположению, что кибероружие с ИИ-усилением у крупнейших держав мира уже есть.

Подменить человека, обмануть человека

Использование технологий ИИ в качестве вспомогательного инструмента для совершения вредоносных действий, судя по всему, уже реальность.

По данным Европола, на подпольных киберфорумах вовсю обсуждаются, тестируются и даже сдаются в аренду инструменты для взлома паролей и CAPTCHA на базе нейросети, такие как XEvil 4.0 (используется для взлома CAPTCHA на сайтах Яндекса), или PWnagotchi 1.0.0 (используется для взлома сетей Wi-Fi посредством атак деаутентификации).

Второй инструмент и интересен, и опасен тем, что используемая им нейросеть выстроена по геймификационной модели: за каждую успешную атаку она получает некое вознаграждение и это способствует постепенному развитию её эффективности.

Любопытны также инструменты для осуществления социальной инженерии при поддержке технологий ИИ. Как известно, подавляющая часть кибератак начинаются с таких вещей как социальная инженерия или фишинг.

Степень успешности фишинговых атак определяется и правильным выбором конечной цели, и убедительностью мошеннического послания, заманивающего пользователя в ловушку. Для того, чтобы это послание “состоялось”, злоумышленники иногда очень долго и скрупулёзно собирают личные данные о цели.

В исследовании Европола упоминается инструмент, обнаруженный на французских киберкриминальных форумах, под названием Eagle Eyes, который, как утверждают его разработчики, способен выявить все профили в социальных сетях, принадлежащих одному и тому же человеку, даже если он везде именуется по-разному. Это дополнительно расширяет возможности по сбору данных. А они и без того огромные, учитывая как много лишней информации о себе мы оставляем во Всемирной Сети.

Другой вариант: по соцсетям начинает разгоняться видео, где известный политик вещает что-то глубоко возмутительное (но не вполне неожиданное с его стороны). Итогом становится большой скандал, а то и битые витрины и горящие автомобили. На деле же сам политик ничего такого не озвучивал, от его лица распространили дип-фейк.

А как насчёт автоматизированных кампаний по дезинформации или “зашумливанию” каналов связи с помощью посторонних сообщений от “ботов”? Или атак на используемые в социальных сетях алгоритмы по курированию контента (которые и так работают не лучшим образом). Всё это уже сегодня под силу ИИ-решениям.

Вопрос лишь в том, когда найдутся люди, которые пожелают воспользоваться этими возможностями.

Дипфейки могут затрагивать и другие области: например, уже многократно продемонстрировано, как может быть легко обмануть автомобильные автопилоты просто с помощью специально подготовленных проекций изображений. Все эти эксперименты проводились в безопасной среде, практическая реализуемость таких атак не всегда однозначна, но заведомо отлична от нуля. Особенно, если в дело вступит ИИ.

Обмануть ИИ

Ещё один генеральный сценарий связан с атаками уже на сами системы “искусственного интеллекта”, наиболее перспективной и опасной из которых может стать “отравление данных”.

Вариантов применения “отравленного” ИИ тоже великое множество: можно создать бэкдоры, можно создать закладки, так чтобы в нужный момент вынудить ИИ исполнить какую-то вредоносную команду от взломавших его людей. По мере того, как будет расти доступность систем ИИ (а до их пришествия в домохозяйства явно не так много времени пройдёт), “отправление данных” или эксплуатация каких-то ещё уязвимостей может стать целой индустрией киберкриминала.

Можно ли что-то с этим сделать?

Как ни странно это может прозвучать, но в конечном счёте всё упирается в этику. Пусть и в самом широком смысле.

И хотя у притч о неизбежности победы добра над злом плохо с доказательной базой, своя сермяжная правда тут всё-таки находится.

Вопрос этики не сводится только к тому, что использовать ИИ во вред людям нехорошо, неправильно, небезопасно и безответственно. Но беда в том, что ИИ, как уже сказано выше, заметно упрощает потенциальному злоумышленнику нахождение компромисса с собственной совестью.

Примерно так это и работает в реальности. Как уже сказано выше, психологическая изоляция злоумышленника от жертвы снимает с первого всякие остаточные моральные ограничения. Он не видит жертву; отследить атаку к нему как к истинному первоисточнику не представляется возможным. Угрозы наказания нет, остаётся вопрос, до какой степени потенциальный преступник “договаривается” с собственной совестью. ИИ становится как раз “средством психологической изоляции” и упрощает злоумышленнику эту задачу.

Предлагаются и некоторые частные требования к системам ИИ: например, чтобы они идентифицировали себя как таковые при общении с людьми (этой инициативе точно будут противиться коммерсанты, не говоря уж о киберпреступниках).

К вопросам этики в определённом смысле относится и обращение пользователей с собственными данными и рабочими инструментами.

Информационная безопасность глубоко коллективный вопрос. Каждый, кто не соблюдает базовые правила сетевой безопасности и защиты личных данных, подвергает какой-то доли риска и других. Риска, который вырастет многократно, как только в качестве киберзлоумышленников начнёт выступать ИИ, самостоятельно или под чьим-то контролем.

Правильно ли, что из той информации, которую мы оставляем в Сети по каким бы то ни было причинам, можно составить полный психологический, физический, медицинский, наконец, профиль? И воспользоваться им для причинения вреда нам же самим?

И, действительно, чем дальше, тем меньше оснований остаётся думать как-то иначе.

Тем более, что основной мишенью вредоносного применения ИИ является именно человек. А не технологические устройства.

Искусственный интеллект — угроза человечеству?

Искусственный интеллект, который когда-то считался выдумкой фантастов, сегодня вполне реален. Эта тема уже давно не сходит со страниц научно-популярных журналов, постоянно затрагивается в кино и книгах. Большинство публикаций содержит хвалебные оды искусственному интеллекту. Регулярно нам сообщают о все новых достижениях компьютерных программ, которые научились ставить медицинские диагнозы, писать картины, как Рафаэль, сочинять стихи или петь.

Постоянно сталкиваясь с огромным количеством дифирамбов в адрес ИИ, я задумалась, не таит ли его столь бурное развитие опасности для нас? Оказывается, подобное предположение вызывает большой интерес и у многих великих умов человечества, например, Стивена Хокинга и Илона Маска. Эти лидер ы в индустрии высоких технологий уверены, что за ним нужен постоянный контроль.

Илону Маску на встрече в Массачусетском технологическом университете задали вопрос, что он думает об искусственном интеллекте. Он ответил, что, по его мнению, ИИ можно сравнить с «вызовом демона, которого нельзя призывать, если не можете его контролировать». В будущем люди могут настолько отстать от машин, что в конечном итоге они будут смотреть на людей так же, как люди в настоящее время смотрят на домашних животных. «Мне не по душе идея стать домашней кошкой».

Стивен Хокинг в своих многочисленных выступлениях говорил, что развитый ИИ будет способен переделывать, усовершенствовать себя. Причем скорость его эволюции будет не сопоставима со скоростью эволюции людей. Человечество рискует оказаться на более низкой ступени развития. На Земле появится новая форма жизни, превосходящая человека.

На сайте PСtunе.ru выделены четыре класса риска, вызываемого искусственным интеллектом:

ИИ может стать опасным, если будет сознательно запрограммирован на враждебность. Например, военными или террористами для достижения преступных целей.

Также враждебность искусственного интеллекта может проявиться при несовпадении глобальных целей самого ИИ и человечества. Что будет, если искусственный интеллект решит, что единственный способ достичь цели — это уничтожить всех людей?

Например, ИИ, у которого нет целей дружелюбия, отвечает за обработку полей пестицидами. Он будет обрабатывать посевы, даже тогда, когда на поле находятся люди.

ИИ, который работает с неполными данными, может ошибиться точно тaк же, как и человек. Ошибок такого рода избежать невозможно, как невозможно и знать все на свете.

Однако, поскольку ИИ способен учиться на собственном опыте, данный риск является наименее опасным. Возможность повторения ошибки будет постоянно снижаться, совершенствуя ИИ.

Большая опасность ИИ состоит в спoсобности бесконечного самосовершенствования. В конечном итоге такой искусственный интеллект может превзойти возможности интеллекта человеческого.

При возникновении ИИ, который будет умнее любого человека на Земле, людям станет невозможно полностью понять его. Он будет продолжать улучшать себя с огромной скоростью. Возможности ИИ станут поистине бесконечными. Существует много теорий об опасности искусственного интеллекта, но мы должны осознавать, что это только гипотезы, а не факты. Человечество всегда сомневалось в новых технологиях. Было время, когда люди опасались даже мобильных телефонов. Остановить технический процесс невозможно, да и не нужно. Но при этом нельзя и недооценивать риски, связанные с развитием искусственного интеллекта. В любом случае успех использования ИИ зависит от того, каким мы его создадим и как будем контролировать. Вы согласны?

Выявлена катастрофическая опасность искусственного интеллекта

Ученые Университета Саншайн-Коста в Австралии выяснили, что высокоразвитый искусственный интеллект (ИИ) способен уничтожить человечество или нанести ему катастрофический ущерб даже без злого умысла. Специалисты провели мысленный эксперимент с гипотетической системой SantaNet, целью которой является рассылка подарков хорошим детям по всему миру за одну ночь. Об этом сообщает издание Science Alert.

Исследователи выявили, что опасность возникает уже на этапе определения, каких детей считать хорошими, а каких — непослушными. Эта цель достигается за счет масштабной сети скрытого наблюдения, отслеживающей поведение детей в течение всего года. SantaNet будет руководствоваться собственными моральными суждениями, которые могут привести к дискриминации, массовому неравенству и нарушению прав человека. Кроме того, сеть может побуждать детей плохо себя вести, чтобы снизить нагрузку на себя либо повысить планку «хорошего поведения».

Материалы по теме

«Сознание — это счисление»

Злой разум

Поскольку в мире живет около двух миллиардов детей младше 14 лет, SantaNet может превратить всю Землю в гигантскую фабрику по производству игрушек. Эту проблему, названную «проблемой скрепок», впервые сформулировал исследователь искусственного интеллекта Ник Бостром, который предположил, что ИИ, предназначенный для увеличения эффективности производства скрепок, воспримет свою цель слишком буквально.

Кроме того, рассылка подарков в Сочельник с помощью армии дронов может привести к открытой конфронтации, когда страны не дадут дронам беспрепятственно летать в своем воздушном пространстве. Также SantaNet может быть уязвимой для взлома террористическими группами. Еще одной проблемой является взаимодействия с ИИ, работающими над проблемами изменения климата, продовольственной и водной безопасностью и деградацией океанов. Оно может привести либо к конфликту, либо к сотрудничеству, целью которого станет сокращение населения Земли.